Évaluation de la Politique sur l'évaluation de 2009

Remerciements

La présente évaluation a été réalisée par le Centre d'excellence en évaluation du Secrétariat du Conseil du Trésor du Canada et par une équipe d'experts-conseils de l'extérieur composée de Natalie Kishchuk, EA, de Program Evaluation and Beyond Inc. et de Benoît Gauthier, EA, de Circum Network Inc. Le Centre d'excellence en évaluation a produit le présent rapport final, et les experts-conseils de l'extérieur en ont assuré l'examen d'assurance de la qualité.

Le Centre d'excellence en évaluation tient à remercier les membres des comités consultatifs, qui ont fourni des conseils sur la planification et la réalisation de l'évaluation, ainsi que sur les rapports s'y rattachant.

Table des matières

- Sommaire

- 1.0 Introduction

- 2.0 Approche et conception de l'évaluation

- 3.0 Constatations

- 4.0 Conclusions

- 5.0 Recommandations

- Annexe A : Évolution de l'évaluation dans l'administration fédérale et contexte du renouvellement de la Politique en 2009

- Annexe B : Examen de la mise en œuvre de la Politique sur l'évaluation de 2009

- Mise en œuvre des exigences de la politique liées au leadership, à la gouvernance et à la planification

- Capacité d'assurer la mise en œuvre complète des exigences de la politique

- Mesure du rendement pour appuyer l'évaluation

- Les progrès de la mise en œuvre dans les petits ministères et organismes

- Les défis de la mise en œuvre de la politique

- Annexe C : Objet de l'évaluation de la Politique sur l'évaluation de 2009, méthodologie et comités de gouvernance pour l'évaluation

- Annexe D : Théorie de contribution de la Politique sur l'évaluation de 2009, schématisation des processus génériques d'évaluation du cycle de vie d'une évaluation ministérielle, et modèle logique de mise en œuvre de la Politique sur l'évaluation de 2009

- Notes de fin d'ouvrage

Sommaire

Contexte

Le Secrétariat du Conseil du Trésor du Canada a mené en 2013-2014 une évaluation de la Politique sur l'évaluation de 2009. L'évaluation visait à évaluer le rendement de la politique, à établir une base de référence des résultats de la politique – en particulier ceux liés à l'utilisation et à l'utilité de la politique – et à recenser les occasions d'aider les ministères à satisfaire à leurs besoins d'évaluation au moyen d'une application assouplie de la politique, de la directive et des normes connexes. Le présent rapport fait état des principales constatations, conclusions et recommandations de l'évaluation.

Méthodologie

L'équipe d'évaluation était constituée d'experts-conseils de l'extérieur ainsi que d'analystes du Centre d'excellence en évaluation du Secrétariat du Conseil du Trésor du Canada. Les membres de l'équipe externe ont évalué les résultats de la politique, et les membres de l'équipe interne en ont évalué l'application. Aux fins de l'évaluation, l'on a utilisé des méthodes qualitatives (études de cas, schématisation des processus, examen de documents et de revues spécialisées, et consultations des intervenants auprès des administrateurs généraux, des sous-ministres adjoints, des organismes centraux et autres) et des méthodes quantitatives (analyse des données de surveillance et enquêtes auprès directeurs de programme, des gestionnaires de l'évaluation et des évaluateurs). Les membres des équipes d'évaluation interne et externe ont exercé une fonction de remise en question du travail de chacun ainsi que la qualité des produits d'évaluation.

Constatations et conclusions

Rendement et résultats de la politique

En ce qui a trait au rendement de la politique, l'évaluation a permis de constater ce qui suit :

- En général, les besoins des administrateurs généraux et des cadres supérieurs en matière d'évaluation ont été bien servis dans le contexte de la Politique sur l'évaluation de 2009. La haute direction a pu tirer des renseignements stratégiques à l'appui de la prise de décisions au niveau supérieur. Parallèlement, les efforts déployés pour satisfaire aux exigences de portée de la politique ont parfois rendu les services d'évaluation moins en mesure de satisfaire aux besoins émergents de la haute direction.

- La politique a exercé une influence globale positive au chapitre de la satisfaction des besoins des gestionnaires de programmes, et les évaluations initiales de certains programmes ont été utiles. Cependant, les gestionnaires de programmes dont les programmes ont été évalués dans le cadre d'une évaluation en groupe ou comme une entité d'architecture d'alignement des programmes de haut niveau ont parfois trouvé que leurs besoins n'étaient pas aussi bien satisfaits qu'avant 2009, quand leur programme faisait l'objet de sa propre évaluation.

- Les organismes centraux ont constaté que les évaluations étaient de plus en plus disponibles, et, à l'instar des ministères, ils les utilisaient de plus en plus pour éclairer des activités de gestion des dépenses comme les propositions de dépenses (en particulier, les renouvellements de programmes) et les examens des dépenses. Parallèlement, il est arrivé souvent que les évaluations ne répondent pas aux besoins des organismes centraux en matière de renseignements sur l'efficience et l'économie des programmes.

- Le recours à l'évaluation en vertu de la politique de 2009 a été significatif, mais l'utilisation et l'incidence pourraient être accrues en s'assurant que les évaluations réalisées, ainsi que leur calendrier, leur étendueNote en bas de page 1 et leur orientationNote en bas de page 2 correspondent plus étroitement aux besoins des utilisateurs.

- Les évaluations réalisées ont eu comme incidence principale de soutenir l'amélioration des politiques et des programmes.

- Le recours accru aux évaluations pour soutenir la prise de décisions a été favorisé par le changement de culture observé en faveur de la valorisation et de l'utilisation des évaluations.

- Les facteurs qui ont eu l'influence positive la plus évidente sur le recours à l'évaluation dans les ministères ont été les éléments de politique liés à la gouvernance et au leadership de la fonction d'évaluation, alors que les facteurs qui ont entravé le plus évidemment le recours à l'évaluation ont été ceux qui ont trait aux ressources et aux calendriers.

- Malgré les préoccupations exprimées au sujet de leur capacité de satisfaire à toutes les exigences de la politique, les ministères, de façon générale, s'attendent à satisfaire à toutes les exigences à l'intérieur de l'actuelle période de cinq ans.

Pertinence et incidence des trois principales exigences de la politique

En ce qui concerne la pertinence et l'incidence des trois principales exigences de la politique (portée complète des dépenses de programmes directes, évaluations quinquennales et examen des cinq questions fondamentalesNote en bas de page 3), l'évaluation a permis de constater ce qui suit :

- Les difficultés de mise en œuvre d'une portée complète ont découlé des besoins combinés des trois principales exigences de la politique (portée complète des dépenses de programmes directes, évaluations quinquennales et examen des cinq questions fondamentales), et du contexte des ressources limitées pour procéder à des évaluations. L'exigence des évaluations quinquennales a semblé être au cœur des difficultés de mise en œuvre dans la plupart des ministères.

- Les intervenants à tous les niveaux ont reconnu les avantages d'une portée complète pour ce qui est d'englober les besoins de tous les utilisateurs des évaluations et d'atteindre tous les objectifs de la politique. Néanmoins, l'on a observé des situations où les évaluations individuelles ont clairement eu peu d'utilité.

- Le fait de procéder à des évaluations quinquennales a des avantages et des désavantages, selon la nature des programmes et les besoins des utilisateurs. Pour optimiser l'utilité de l'évaluation d'un programme donné, des évaluations plus ou moins fréquentes, ou à fréquence réglable, pourraient être nécessaires.

- Combinée avec l'exigence de portée complète, la fréquence de cinq ans a restreint la marge de manœuvre dont disposent les services d'évaluation pour satisfaire aux besoins de renseignements émergents ou plus prioritaires.

- De façon générale, les cinq questions fondamentales ont couvert un éventail adéquat de questions et établissent un cadre cohérent qui a permis de comparer et d'analyser les évaluations au sein et à l'échelle des ministères au fil du temps. La pertinence perçue de certaines questions fondamentales a toutefois varié selon l'évaluation et le type d'utilisateur de l'évaluation.

- Des lacunes de longue date au chapitre de la disponibilité et de la qualité des données de mesure du rendement des programmes et des données financières structurées de façon incompatible ont continué de contraindre les évaluateurs sur le plan de la fourniture d'évaluations de l'efficacité, de l'efficience (y compris le rapport coût-efficacité) et de l'économie des programmes. Les organismes centraux et les cadres supérieurs ont exprimé le souhait d'obtenir, en particulier, des renseignements plus nombreux et de meilleure qualité sur l'efficience et l'économie des programmes.

Approches utilisées pour mesurer le rendement de la politique

En ce qui concerne les approches utilisées pour mesurer le rendement de la politique, l'évaluation a permis de constater ce qui suit :

- Les mécanismes de mesure du rendement de la politique ont permis de suivre les utilisations évidentes des évaluations – ceux qui étaient directes et plus immédiates – mais n'ont pas couvert l'éventail des utilisations indirectes, à long terme ou plus stratégiques, et pourraient ne pas avoir brossé un portrait fidèle de l'utilité des évaluations.

Autres constatations

L'évaluation a aussi permis de constater ce qui suit :

- Les exigences de la Politique sur l'évaluation et celles d'autres formes de surveillance et d'examen, comme l'audit interne, ont donné lieu à certains chevauchements et alourdi le fardeau.

Conclusions

La Politique sur l'évaluation de 2009 a aidé la fonction d'évaluation dans l'ensemble de l'administration fédérale à jouer un rôle plus important relativement au soutien du système de gestion des dépenses. La politique a également soutenu des utilisations comme l'amélioration des programmes et des politiques, la reddition de comptes et les rapports publics. Un solide engagement de la part des administrateurs généraux et des cadres supérieurs envers la gouvernance de la fonction d'évaluation a promu l'utilité des évaluations, et les besoins en matière d'évaluation des administrateurs généraux, des cadres supérieurs et des organismes centraux ont été bien servis. Dans certains cas, mais pas systématiquement dans tous les ministères, les fonctions d'évaluation ont produit des analyses horizontales qui ont contribué à un apprentissage inter-programmes fort utile, éclairé des améliorations à la fois du programme évalué et d'autres programmes, et de l'organisation dans son ensemble. Toutefois, dans le cadre de l'évaluation de l'efficacité, de l'efficience et de l'économie des programmes au chapitre des évaluations, les fonctions ministérielles étaient souvent limitées par des lacunes sur le plan de la disponibilité et de la qualité des données de mesure du rendement et par des données financières structurées de façon incompatible.

Les constatations ont montré que, même si l'on s'entend en général pour dire que toutes les dépenses du gouvernement doivent être évaluées périodiquement, il y avait aussi une opinion largement répandue selon laquelle le potentiel d'utilisation des évaluations individuelles doit influencer leur déroulement. En outre, les exigences de la politique concernant le calendrier et l'orientation des évaluations n'ont pas donné aux fonctions d'évaluation des ministères la marge de manœuvre voulue pour faire pleinement état des besoins des utilisateurs en matière de planification des évaluations ou pour satisfaire aux nouvelles priorités. L'on a constaté que les besoins d'évaluation variaient entre les différents groupes d'utilisateurs (en particulier, les besoins des organismes centraux et ceux des ministères étaient assez différents). Cependant, pour satisfaire aux exigences de portée en dépit des contraintes de ressources, les ministères ont parfois choisi des stratégies d'évaluation (par exemple, le groupement de programmes à des fins d'évaluation) qui étaient économiques, mais qui ont en définitive servi un éventail plus restreint de besoins des utilisateurs. La rigidité des exigences de portée et de fréquence a également fait en sorte qu'il a été difficile pour les ministères de coordonner la planification des évaluations avec d'autres fonctions de surveillance afin de maximiser l'utilité des évaluations et d'alléger le fardeau des programmes.

Recommandations

Au terme de l'évaluation, il est recommandé que le Secrétariat du Conseil du Trésor du Canada, au moment de renouveler la Politique sur l'évaluation en vue de la faire approuver par le Conseil du Trésor :

- Réaffirme et renforce les exigences de la Politique sur l'évaluation de 2009 en matière de gouvernance et de leadership des fonctions d'évaluation des ministères, lesquelles ont eu une incidence positive sur le recours à l'évaluation dans les ministères.

- Assouplisse les exigences de base de la Politique sur l'évaluation de 2009 et oblige les ministères à cerner et à prendre en considération les besoins de l'éventail complet des groupes d'utilisateurs de l'évaluation au moment de déterminer la façon d'évaluer périodiquement les dépenses des organisations (y compris l'étendue des programmes ou des dépenses examinés dans le cadre des évaluations individuelles), le calendrier des évaluations individuelles, et les questions à examiner dans les évaluations individuelles.

- Collabore avec les intervenants des ministères et des organismes centraux afin d'établir des critères pour orienter les processus de planification ministériels de sorte que toutes les dépenses de l'organisation soient prises en considération aux fins de l'évaluation selon les questions fondamentales; que les besoins de l'éventail complet des principaux utilisateurs des évaluations, à l'intérieur comme à l'extérieur du ministère, soient compris et pris en considération dans le cadre des décisions de planification; que les activités prévues des autres fonctions de surveillance soient prises en considération; et que les choix liés à la portée de l'évaluation et à l'étendue, au calendrier et aux questions traitées dans les évaluations individuelles soient justifiés avec transparence dans les plans ministériels d'évaluation.

- Mobilise les centres de politiques du Secrétariat qui guident les ministères dans la collecte et la structuration des données de mesure du rendement et des données de gestion financière de manière à mettre au point une approche intégrée pour mieux soutenir les fonctions d'évaluation des ministères pour ce qui est de l'évaluation de l'efficacité, de l'efficience et de l'économie des programmes.

- Favorise des pratiques, au Secrétariat et dans les ministères, consistant à mener des analyses régulières, systématiques et transversales d'un vaste éventail d'évaluations réalisées, et à utiliser ces analyses pour appuyer l'apprentissage organisationnel et la prise de décisions stratégiques dans l'ensemble des programmes et des organisations. À cet égard, le Secrétariat du Conseil du Trésor du Canada doit faciliter la mise en commun des pratiques exemplaires à l'échelle de l'administration fédérale aux fins de la réalisation et de l'utilisation d'analyses transversales.

1.0 Introduction

1.1 Objet de l'évaluation de la Politique sur l'évaluation

La Politique sur l'évaluation de 2009 doit elle-même être évaluée tous les cinq ans.

L'évaluation visait à :

- Évaluer l'application et le rendement (efficacité, efficience et économie) de la politique et cerner les résultats de base, en particulier en ce qui a trait à l'utilisation et à l'utilité des évaluations;

- Cerner les possibilités de mieux aider les ministères à satisfaire à leurs besoins en matière d'évaluation grâce à l'application assouplie de la politique, ainsi que de la directive et des normes connexes.

Cette évaluation aidera le Secrétariat du Conseil du Trésor du Canada à s'acquitter de ses responsabilités d'élaboration de la politique et à diriger la fonction d'évaluation à l'échelle du gouvernement.

1.2 Contexte

1.2.1 Évolution de la Politique sur l'évaluation fédérale et contexte du renouvellement de la Politique en 2009

Le gouvernement fédéral met en place des politiques centrales d'évaluation depuis 1977. Avant la Politique sur l'évaluation de 2009, les politiques fédérales positionnaient la fonction d'évaluation de manière à éclairer la gestion et l'amélioration des programmes, surtout du point de vue d'un gestionnaire de programme. En réaction au besoin croissant de preuves neutres et crédibles de l'optimisation des ressources publiques, la politique de 2009 a élargi l'orientation de façon à prévoir un rôle plus important pour la fonction d'évaluation à l'appui du système de gestion des dépenses. En outre, la politique situe le dirigeant de l'évaluation au niveau de conseiller stratégique auprès de l'administrateur général au sujet de la pertinence et du rendement des programmes ministériels. Parmi les facteurs ayant mené à la réorientation de la fonction d'évaluation, mentionnons :

- L'exigence inscrite dans la loi en 2006 (article 42.1 de la Loi sur la gestion des finances publiques) d'examiner tous les cinq ans la pertinence et l'efficacité de tous les programmes de subventions et de contributions en cours;

- Le renouvellement en 2007 du système de gestion des dépenses, qui donnait suite aux recommandations de Note en bas de page 4 de la vérificatrice générale, aux engagements du budget de 2006, et aux recommandations du Comité permanent des comptes publicsNote en bas de page 5 (adoptées par le comité en Note en bas de page 6) sur le positionnement de l'évaluation pour mieux appuyer le processus décisionnel en matière de gestion des dépenses;

- L'avènement d'examens stratégiques et d'autres examens des dépenses, qui ont accru la demande pour que les évaluations fournissent de l'information au sujet de la pertinence et du rendement des programmes.

Des exigences de portée étaient prévues dans toutes les politiques fédérales d'évaluation antérieures, et elles variaient de l'obligation de veiller à ce que tous les programmes soient évalués périodiquement à celle d'envisager l'évaluation de tous les programmes, sans toutefois l'exiger. La politique de 2009 exige l'évaluation de toutes les dépenses de programmes directesNote en bas de page 7. De même, la fréquence d'évaluation était toujours précisée dans les politiques fédérales d'évaluation; cette fréquence variait toutefois de tous les trois ans à tous les six ans. L'évaluation doit désormais être effectuée tous les cinq ans en vertu de la politique de 2009. En outre, toutes les politiques fédérales d'évaluation incluaient une série de questions à traiter dans les évaluations. Depuis 1992, ces questions ont été cohérentes, exigeant que les évaluations portent sur la pertinence, l'efficacité et l'efficience des programmes. Cependant, suivant un changement notable apporté en 2009, les questions d'évaluation de base n'étaient plus discrétionnaires. De fait, la politique de 2009 fait en sorte qu'il est obligatoire que les évaluations portent sur cinq questions de base afin de satisfaire aux exigences de portée.

Pour plus de détails concernant l'évolution de l'évaluation dans l'administration fédérale, consulter l'annexe A.

1.2.2 Le contexte international de l'évaluation

Sur la scène internationale, alors que les gouvernements ont entrepris des exercices de réduction et de compression des dépenses au cours des dernières années, plusieurs pays ont étendu la portée de l'évaluation et ont pris des mesures pour améliorer la qualité de l'évaluation et mettre de l'avant l'utilisation de l'évaluation dans la prise de décisions. À titre d'exemple, le Royaume-Uni et les États-Unis ont pris des mesures pour renforcer l'utilisation des données d'évaluation afin de déterminer si des dépenses de programme sont efficaces et correspondent à une utilisation optimale des deniers publics. Au Royaume-Uni, la directive sur l'évaluation à l'intention des ministères et des organismes fédérauxNote en bas de page 8 indique que, à quelques exceptions près, tous les programmes, politiques et projets doivent être évalués en profondeur et que, en l'absence d'une évaluation, le risque est de ne pas savoir si des interventions sont efficaces ou permettent d'optimiser les deniers publics. Aux États-Unis, les évaluations sont présentées comme un moyen d'aider l'administration à déterminer comment dépenser l'argent des contribuables de manière efficace et efficiente – investir davantage dans ce qui fonctionne et moins dans ce qui ne fonctionne pasNote en bas de page 9.

1.2.3 Introduction de la Politique sur l'évaluation de 2009

L'actuelle Politique sur l'évaluation du gouvernement du Canada, qui remplace la Politique d'évaluation de 2001, a été instaurée le . Elle a pour objet de créer une base de données d'évaluation fiables et détaillées en vue d'appuyer l'amélioration des politiques et programmes, la gestion des dépenses, la prise de décisions par le Cabinet et la préparation des rapports à l'intention du public. Pour réaliser cet objectif, la politique a raffermi les exigences inhérentes à la portée de l'évaluation, à l'évaluation de l'optimisation des ressources consacrées aux programmes, à la qualité et au caractère opportun des évaluations, à la neutralité de la fonction d'évaluation et à la capacité d'évaluation des ministères. Dans son rapport de portant sur le chapitre 1 du Rapport de la vérificatrice générale du Canada de l'automne 2009 intitulé L'évaluation de l'efficacité des programmes, le Comité permanent des comptes publics exprime en ces termes son appui à l'orientation de la nouvelle politique : « Elle est donc essentielle pour pouvoir prendre des décisions judicieuses et éclairées au sujet de la conception des programmes et de l'affectation des ressources. Le Comité est un partisan de longue date du recours accru aux évaluations de l'efficacité au sein de l'administration fédérale et se réjouit de constater que le gouvernement a resserré les exigences à cet égard ».

La politique de 2009 et la directive et les normes connexes :

- font en sorte que l'évaluation est une fonction relevant d'un administrateur général comportant une structure de gouvernance neutre au sein des ministères;

- exigent une évaluation intégrale des dépenses de programmes directesNote en bas de page 10 tous les cinq ans;

- précisent les principaux éléments inhérents à la pertinence et au rendement des programmes qui doivent être examinés dans toutes les évaluations (voir le tableau 2 à l'annexe A);

- imposent aux gestionnaires de programmes de nouvelles exigences pour qu'ils élaborent et mettent en œuvre des stratégies de mesure continue du rendement;

- établissent des compétences minimales pour les chefs de l'évaluation au sein des ministères;

- fixent les normes de qualité de chaque évaluation;

- exigent que les rapports d'évaluation puissent facilement être consultés par les Canadiens, et ce, en temps opportun.

La Politique sur l'évaluation de 2009 et la Directive sur la fonction d'évaluation ont instauré des assouplissements en vue d'aider les ministères à obtenir une portée complète.

En raison des changements importants apportés par la politique, et sur les conseils formulés par un comité consultatif d'administrateurs générauxNote en bas de page 11 en 2008, il a été décidé de procéder à une mise en œuvre progressive sur quatre ans pour donner aux ministères suffisamment de temps pour renforcer leur capacité et ainsi réussir à obtenir une portée d'évaluation complète. Pendant cette période de transition, les ministères pouvaient décider de mener leurs évaluations selon une approche axée sur le risque afin de choisir les composantes des dépenses de programmes directes qu'ils veulent évaluer. La période de transition ne s'appliquait pas aux programmes permanents de subventions et de contributions, lesquels devaient être évalués tous les cinq ans, conformément à l'obligation inscrite en 2006 dans la loi.

Par suite de la période de transition, qui a pris fin le , toutes les dépenses de programmes directes sont devenues assujetties à l'évaluation et, d'ici le , la condition de portée complète devra être remplie pour la première fois. Comme précisé à l'annexe A de la Directive sur la fonction d'évaluation, les ministères pourraient tenir compte du risque, des caractéristiques des programmes et d'autres facteursNote en bas de page 12 pour choisir les approches d'évaluation et calibrer les méthodes d'évaluation et le niveau d'effort à consacrer à chaque évaluation. En guise d'exemple, la calibration d'une évaluation afin de déployer moins d'efforts pourrait consister à :

- Choisir des questions d'évaluation moins nombreuses et plus ciblées pour examiner les principaux problèmes d'optimisation des ressources ou pour mettre l'accent sur des aspects de programme que l'on sait déficients;

- Choisir une démarche d'évaluation simplifiée et un calendrier écourté;

- Calibrer les méthodes utilisées et le niveau d'effort en tirant parti des données existantes au lieu de recueillir de nouvelles données en autant que possible; utiliser des échantillons plus petits; utiliser des méthodes d'entrevue moins onéreuses (comme l'entrevue en ligne ou au téléphone au lieu de l'entrevue en personne, ou des entrevues en personne en groupe pour limiter les frais de déplacement); ou effectuer moins d'études de cas.

Les ministères pourraient aussi rajuster l'étendue des évaluations en groupant des programmes, plutôt qu'en les évaluant individuellement.

1.3 Survol de la fonction d'évaluation dans l'administration fédérale

En vertu de la Politique sur l'évaluation de 2009, l'évaluation sert divers utilisateurs, y compris les administrateurs généraux, les organismes centraux, les directeurs de programme, les ministres, les parlementaires et les Canadiens. Les évaluations appuient diverses utilisations, notamment l'amélioration des politiques et des programmes, la gestion des dépenses, le processus de prises de décisions au Cabinet et la présentation de rapports au public.

Comme exemples d'utilisateurs et d'utilisations, les évaluations peuvent éclairer les gestionnaires de programme au sujet des améliorations apportées aux programmes et des propositions de renouvellement ou de refonte des programmes (y compris les présentations au Conseil du Trésor); aider les administrateurs généraux à répartir les ressources entre les programmes; aider les organismes centraux à exercer leur fonction de remise en question lorsqu'ils analysent des présentations au Conseil du Trésor, des mémoires au Cabinet, et des propositions d'examen des dépenses, et dispensent des conseils en la matière; et aider les ministères à présenter aux parlementaires et aux Canadiens les résultats des programmes.

Les responsabilités associées à la mise sur pied et au maintien d'une solide fonction d'évaluation dans l'administration fédérale sont partagées. Si la responsabilité de la réalisation des évaluations incombe aux ministères et organismes, le secrétaire du Conseil du Trésor joue un rôle de leadership pour la fonction dans son ensemble, épaulé par le Centre d'excellence en évaluation du Secrétariat du Conseil du Trésor du Canada. Pour diriger la fonction d'évaluation à l'échelle du gouvernement, le Secrétariat :

- Soutient les ministères au regard de la mise en œuvre de la Politique sur l'évaluation de 2009;

- Favorise l'élaboration et l'échange de pratiques d'évaluation efficaces dans l'ensemble des ministères;

- Appuie les initiatives de renforcement de la capacité propres à la fonction d'évaluation à l'échelle du gouvernement;

- Assure le suivi des priorités pangouvernementales en matière d'évaluation et de l'état de la fonction d'évaluation, et présente un rapport annuel au Conseil du Trésor à ce sujet;

- Élabore des recommandations de politique à l'intention du Conseil du Trésor.

La Politique sur l'évaluation exige l'établissement de rôles et de structures clés pour la direction et la gouvernance des fonctions d'évaluation dans les ministères, ainsi que l'instauration d'outils pour la planification de leurs activités. Il s'agit notamment du rôle du chef de l'évaluation en tant que responsable ministériel de l'évaluation et conseiller stratégique de l'administrateur général; du rôle du comité ministériel d'évaluation consistant à conseiller l'administrateur général et à faciliter l'utilisation de l'évaluation; et du plan ministériel d'évaluation comme outil d'expression des plans et des priorités et de l'aide à la coordination de l'évaluation et des besoins en mesure du rendement. Dans les petits ministères et organismes, les administrateurs généraux dirigent la fonction d'évaluation. Ils sont tenus de désigner un chef de l'évaluation, mais ils ne sont pas obligés de mettre sur pied des comités ministériels d'évaluation ni d'élaborer des plans ministériels d'évaluation.

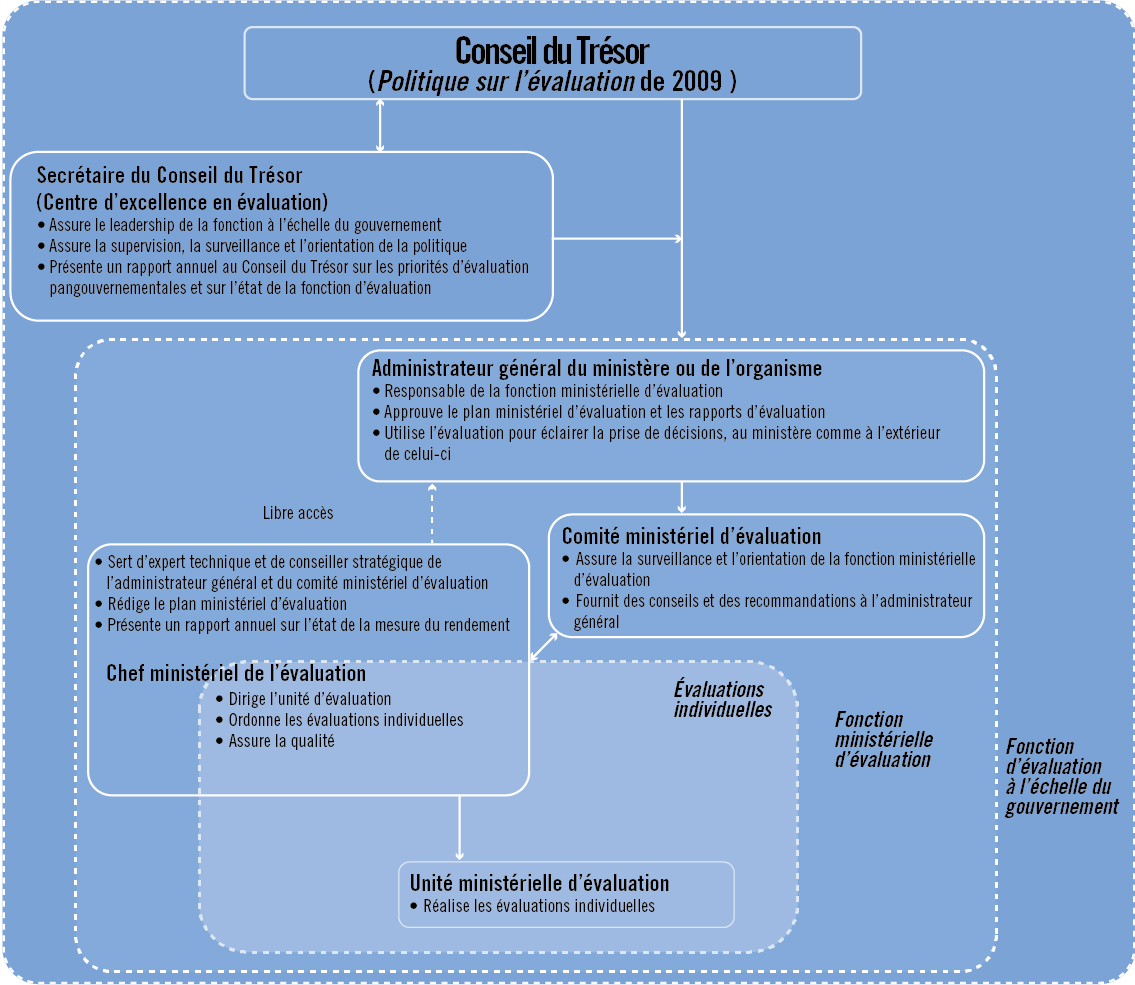

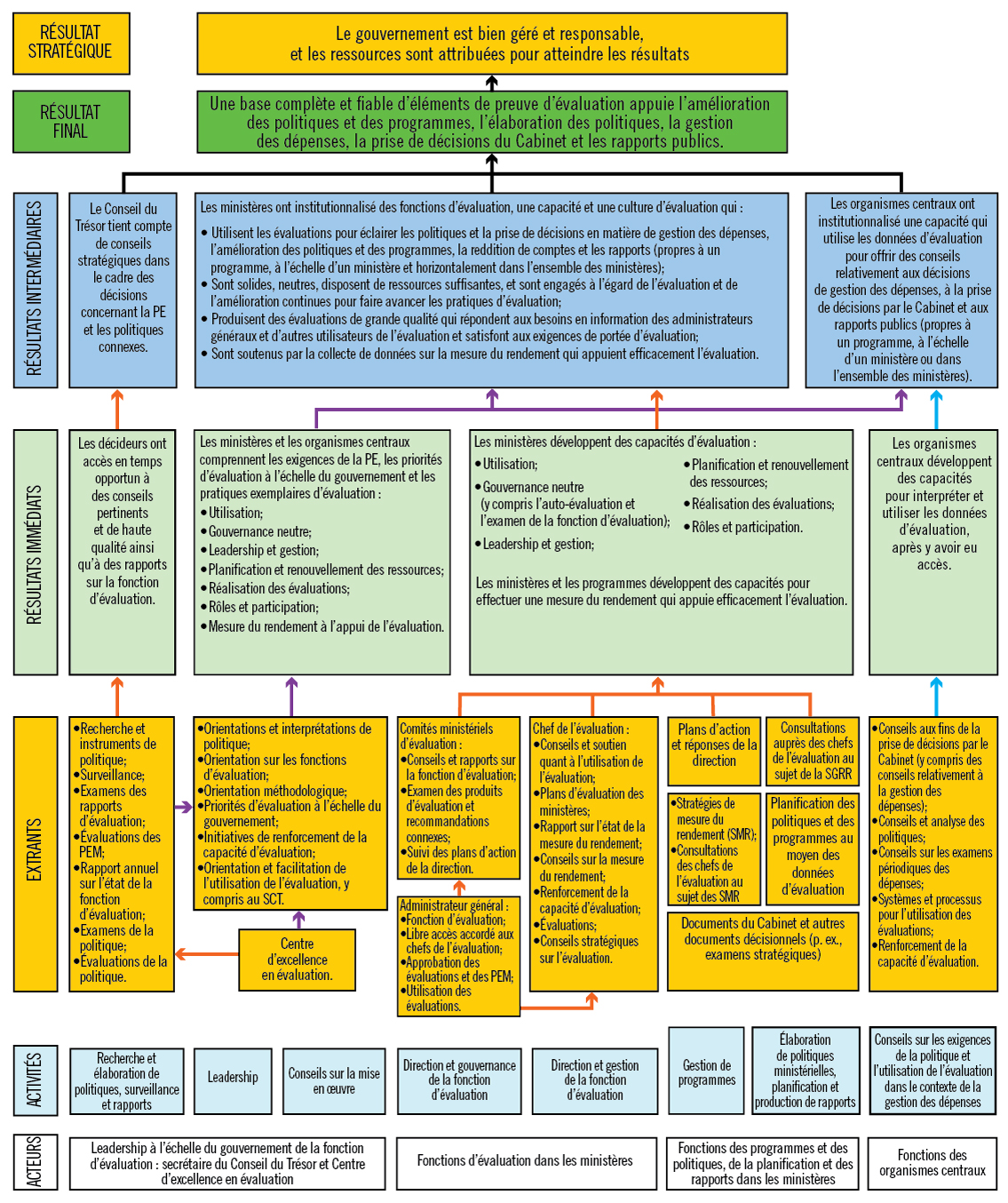

La figure 1 illustre la structure de la fonction d'évaluation dans l'administration fédérale ainsi que les principaux rôles et responsabilités, du point de vue d'un grand ministère ou organisme.

Figure 1 - Version textuelle

La figure montre la structure de la fonction d'évaluation au gouvernement fédéral, dans un grand ministère ou organisme, y compris les structures de gouvernance et les responsabilités des personnes et des organisations, à partir de trois perspectives imbriquées. Les trois perspectives, de la plus étroite à la plus large, sont les suivantes : évaluations individuelles, fonctions individuelles d'évaluation des ministères et fonction d'évaluation à l'échelle du gouvernement.

Du point de vue des évaluations individuelles, les unités ministérielles d'évaluation sont responsables de la réalisation des évaluations. En tant que responsable du service d'évaluation du ministère, le chef de l'évaluation du ministère dirige les évaluations individuelles et en assure la qualité.

Du point de vue de la fonction ministérielle d'évaluation, l'administrateur général a la responsabilité globale de la fonction d'évaluation du ministère, approuve le plan ministériel d'évaluation et les rapports d'évaluation individuels, et utilise les évaluations pour éclairer la prise de décision au sein et en dehors du ministère ou organisme. Le comité ministériel d'évaluation assure la surveillance et l'orientation de la fonction ministérielle d'évaluation et fournit des conseils et des recommandations à l'administrateur général. Le chef de l'évaluation du ministère agit à titre d'expert technique et de conseiller stratégique auprès de l'administrateur général et du comité ministériel d'évaluation, rédige le plan d'évaluation du ministère et fait rapport chaque année sur l'état de la mesure du rendement. Le chef de l'évaluation du ministère a un libre accès à l'administrateur général pour toutes les questions d'évaluation.

Du point de vue l'ensemble du gouvernement, le Conseil du Trésor établit la politique à l'échelle du gouvernement pour la fonction d'évaluation du gouvernement fédéral au moyen de la Politique sur l'évaluation de 2009. La politique établit le rôle et les responsabilités du secrétaire du Conseil du Trésor au regard de l'exercice du leadership de la fonction à l'échelle du gouvernement. Soutenu par le Centre d'excellence en évaluation, le secrétaire assure la surveillance de la politique, le suivi et l'orientation, et fait rapport annuellement au Conseil du Trésor sur les priorités d'évaluation dans l'ensemble du gouvernement et sur l'état de la fonction d'évaluation.

1.4 Mise en œuvre de la Politique sur l'évaluation

Après l'introduction de la politique de 2009, le Secrétariat du Conseil du Trésor du Canada a continuellement surveillé la mise en œuvre de la politique et fait rapport à ce sujet. Afin de cerner les problèmes, le Secrétariat a effectué en 2013 un examen de la mise en œuvre qui a porté sur la période de transition de quatre ans ayant précédé la mise en œuvre complète de la portée d'évaluation exhaustive aux cinq ans.

Pris ensemble, l'examen de la mise en œuvre et les rapports annuels du Secrétariat sur l'état de la fonction d'évaluation entre 2010 et 2012 ont montré que les ministères avaient fait de solides progrès au cours de la période de transition de quatre ans au chapitre de la mise en place de structures de gouvernance pour la fonction (par exemple, comités ministériels d'évaluation et chefs de l'évaluation), du renforcement des capacités d'évaluation, de l'élargissement de la portée des évaluations, de la planification d'une portée complète, et du recours à l'évaluation pour soutenir la prise de décisions.

Lors de l'introduction de la politique de 2009, le Secrétariat avait prévu que les ministères devraient accroître les investissements dans la fonction d'évaluation pour atteindre et maintenir une portée d'évaluation exhaustive tous les cinq ans; une période d'examens des dépenses à l'échelle du gouvernement a toutefois suivi. Le tableau 1 montre le nombre d'évaluations et les ressources qui leur ont été allouées au cours des deux dernières années d'application de la politique de 2001, et la période de transition de quatre ans vers la politique de 2009 dans les grands ministères et organismes fédéraux.

La surveillance exercée par le Secrétariat a montré que les ressources financières affectées à la fonction à l'échelle du gouvernement fédéral ont été à peu près stables jusqu'en 2011-2012 avant de diminuer. Le nombre d'équivalents temps plein consacrés à la fonction a toutefois légèrement augmenté par rapport à 2008-2009 (la dernière année d'application de la politique de 2001), apparemment en réaffectant les budgets des services professionnels aux salaires.

| Politique d'évaluation de 2001 | Politique sur l'évaluation de 2009 (période de transition) |

|||||

|---|---|---|---|---|---|---|

Tableau 1 NotesSource : Enquêtes d'évaluation de la capacité et surveillance du Secrétariat du Conseil du Trésor du Canada.

|

||||||

| Exercice | 2007–2008 | 2008–2009 | 2009–2010 | 2010–2011 | 2011–2012 | 2012–2013 |

| Nombre d'évaluations | 121 | 134 | 164 | 136 | 146 | 123 |

| Équivalents temps plein | 409 | 418 | 474 | 459 | 477 | 459 |

| Ressources financières (millions $) | ||||||

| Salaires | 28,4 | 32,3 | 37,1 | 38,2 | 39,0 | 40,8 |

| Fonctionnement et entretien | 17,9 | 4,4 | 5,0 | 4,3 | 4,6 | 3,8 |

| Services professionnels | 4,2 | 20,5 | 19,1 | 17,6 | 14,3 | 11,6 |

| Autres | 6,7tableau 1 note 3 † | 3,7tableau 1 note 4 †† | 5,8tableau 1 note 4 †† | 0,3tableau 1 note 4 †† | 2,2tableau 1 note 4 †† | Sans objettableau 1 note 5 § |

| Total des ressources financièrestableau 1 note 6 §§ | 57,3 | 60,9 | 66,9 | 60,2 | 60,2 | 56,2 |

Même si le nombre d'évaluations (123) réalisées dans la dernière année de la période de transition de quatre ans a été inférieur au nombre d'évaluations produites dans la première année (164), les rapports d'évaluation produits en 2012-2013 ont couvert de plus grands montants de dépenses de programmes directes qu'avant 2009-2010. En 2012-2013, l'évaluation moyenne a couvert environ 78 millions de dollars en dépenses de programmes directes, contre une moyenne de 44 millions de dollars en 2008-2009. Ainsi, des renseignements d'évaluation étaient disponibles pour un plus grand montant de dépenses de programmes directes à l'échelle du gouvernement en vertu de la politique de 2009 que de celle de 2001.

L'examen de la mise en œuvre a permis de constater que les ministères avaient utilisé une ou plusieurs des stratégies présentées ci-dessous pour étendre la portée de l'évaluation à l'intérieur de leurs ressources budgétaires :

- Groupement des programmes aux fins d'évaluation;

- Calibration des efforts consacrés aux projets d'évaluation;

- Recours accru à des évaluateurs internes;

- Réduction des activités autres que l'évaluation.

Pour un sommaire des constatations issues de l'examen de la mise en œuvre, consulter l'annexe B.

1.5 Contexte du renouvellement de la Politique en 2014

L'évaluation de la Politique sur l'évaluation de 2009 a été menée pendant la même période que l'évaluation menée séparément de la Politique sur la structure de la gestion, des ressources et des résultats. Ensemble, ces exercices d'évaluation ont permis d'élargir le débat public en vue d'améliorer les deux politiques.

2.0 Approche et conception de l'évaluation

2.1 Approche et conception

L'évaluation a été fondée sur une approche largement axée sur des objectifs d'apprentissage visant à déterminer la mesure dans laquelle les objectifs de la politique ont été atteints et pourquoi, ainsi que sur un modèle d'analyse de la contribution (théorique) visant à cerner et à tester les hypothèses et les mécanismes de la politique. L'approche était aussi axée sur la collaboration, puisque l'équipe d'évaluation comprenait des experts-conseils de l'extérieur ainsi que des analystes du Centre d'excellence en évaluation du Secrétariat du Conseil du Trésor du Canada, qui est l'unité chargée d'élaborer et de faire des recommandations stratégiques au Conseil du Trésor. Les membres externes de l'équipe ont évalué le rendement de la Politique sur l'évaluation, établi une base de référence des résultats, et évalué les approches utilisées par les ministères et le Secrétariat pour mesurer le rendement de la politique. Les membres internes de l'équipe ont examiné l'application des exigences de la politique et en ont exploré les possibilités d'assouplissement. Les membres externes et internes de l'équipe ont exercé une fonction de remise en question du travail de chacun et assuré la qualité des produits d'évaluation.

L'évaluation s'est caractérisée par le recours à différents modèles de recherche, y compris des études de cas, des séries chronologiques interrompues, des prétests rétrospectifsNote en bas de page 13 et des éléments descriptifs.

2.2 Méthodologie

Les méthodes d'évaluation suivantes ont été utilisées :

- Études de cas du rendement de la politique dans 10 ministères et organismes pour analyser qualitativement l'utilisation de l'évaluation, à partir d'un échantillon total de 28 évaluations menées dans ces ministères. Quatre-vingt-six entrevues auprès de répondants clés ont été menées auprès de chefs et de directeurs de l'évaluation, de membres d'équipes d'évaluation, de gestionnaires des programmes évalués, de membres du comité ministériel d'évaluation et de fonctionnaires d'organismes centraux. Les études de cas ont également comporté des examens des documents;

- Études de cas d'application de la politique pour six types de programmes ou catégories de dépenses, en utilisant 24 exemples de ministères et organismes, afin d'analyser qualitativement la pertinence des exigences politiques clés et de cerner les possibilités d'assouplissement des exigences pour une portée complète des dépenses de programmes directes, des évaluations quinquennales, et l'examen des cinq questions fondamentales. Pour les études de cas, 39 consultations ont été menées auprès de gestionnaires de programmes ministériels et de professionnels de l'évaluation, et 8 consultations ont été menées auprès de fonctionnaires d'organismes centraux. Les six types de programmes ou catégories de dépenses étaient les suivants :

- Quotes-parts payables aux organisations internationales;Note en bas de page 14

- Fonds de dotation;Note en bas de page 15

- Programmes assortis d'une exigence d'évaluations indépendantes commandées par le bénéficiaire;Note en bas de page 16

- Programmes à faible risque;

- Programmes visant l'obtention de résultats à long terme;

- Autres programmes désignés par les ministères comme présentant des difficultés sous l'angle de l'application de la politique;

- Consultations auprès de 35 chefs de l'évaluation, ou de leurs délégués, en petits groupes;

- Enquêtes en ligne auprès de 115 gestionnaires de programmes et de 153 évaluateurs et gestionnaires de l'évaluation;

- Analyses statistiques descriptives et inférentielles des données de suivi de la politique déjà recueillies par le Centre d'excellence en évaluation (Enquête d'évaluation de la capacité et résultats d'évaluation du Cadre de responsabilisation de gestion);

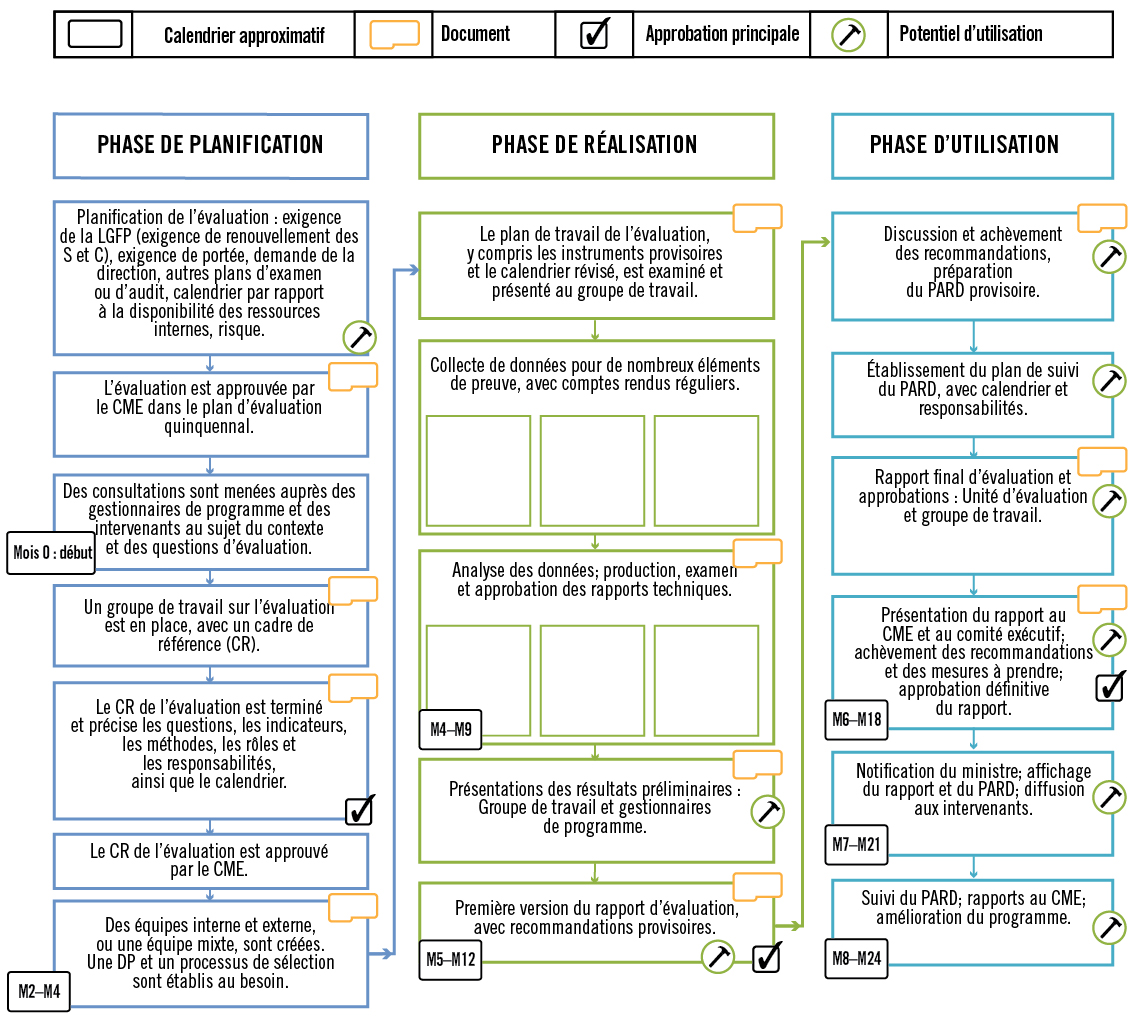

- Schématisation des processus pour donner un aperçu de la façon dont la fonction d'évaluation est exercée dans les ministères, y compris les processus de planification, de réalisation et d'utilisation des évaluations;

- Examen de documents internes et externes, y compris l'examen de la mise en œuvre de la Politique sur l'évaluation, et un résumé des consultations menées en 2014 auprès des administrateurs généraux et d'autres répondants clés relativement aux évaluations quinquennales de la Politique sur l'évaluation et de la Politique sur la structure de la gestion, des ressources et des résultats;

- Une revue de documents spécialisés sur les politiques et les pratiques d'évaluation observées dans d'autres pays, dont les États-Unis, le Royaume-Uni, l'Australie, la Suisse, le Japon, l'Inde, l'Afrique du Sud, le Mexique et l'Espagne, ainsi que le Groupe d'évaluation des Nations Unies, le Comité d'aide au développement de l'Organisation de coopération et de développement économiques, et le Groupe d'évaluation indépendant de la Banque mondiale.

Pour plus de détails au sujet des méthodes d'évaluation utilisées, voir l'annexe C.

2.3 Gouvernance

L'évaluation a été régie par deux comités consultatifs : l'un d'eux composé de chefs de l'évaluation, et l'autre de représentants des organismes centraux. Les travaux de chaque comité ont été régis par un cadre de référence. Chaque comité a formulé des observations et des commentaires sur le plan global d'évaluation, y compris les questions d'évaluation et les catégories d'études de cas, le plan de travail d'évaluation de l'équipe d'évaluation externe, les résultats préliminaires des études de cas sur le rendement et sur l'application de la politique, les conclusions globales provisoires du rapport final d'évaluation, et le rapport final d'évaluation.

Pour plus de détails sur les comités de gouvernance de cette évaluation, voir l'annexe C.

2.4 Questions et période d'évaluation

L'évaluation de la Politique sur l'évaluation de 2009 a couvert la période du (mise en œuvre de la politique) au .

Les questions d'évaluation étaient les suivantes :

- Dans quelles circonstances ou conditions, le cas échéant, conviendrait-il de ne pas aborder les cinq questions fondamentales dans une évaluation? Quelles répercussions cela aurait-il sur l'utilisation et l'utilité des évaluations pour différents utilisateurs (y compris ceux des ministères responsables et des organismes centraux) ainsi que sur l'objectif de la politique?

- Dans quelles circonstances et conditions, le cas échéant, l'exigence d'une évaluation quinquennale n'est-elle pas appropriée? Quelles répercussions, le cas échéant, une modification de cette exigence aurait-elle sur l'utilisation et l'utilité des évaluations pour différents utilisateurs (y compris ceux des ministères responsables et des organismes centraux) ainsi que sur l'objectif de la politique?

- L'approche fondée sur la portée exhaustive des évaluations est-elle le modèle le plus approprié pour garantir que les évaluations contribuent à l'amélioration des politiques et des programmes, à la gestion des dépenses (dépenses de programmes directes), à la prise de décisions par le Cabinet et à l'établissement de rapports à l'intention du public?

- Dans quelle mesure les méthodes actuelles de mesure du rendement de la politique sont-elles appropriées, valides et fiables?

- Quels résultats doivent servir de référence pour mesurer le rendement de la politique relativement à l'utilisation des évaluations en vue d'appuyer les activités suivantes :

- Élaboration et amélioration des politiques et des programmes?

- Gestion des dépenses (dépenses de programmes directes)?

- Prise de décisions par le Cabinet?

- Responsabilité et établissement de rapports publics

- Réponse aux besoins des administrateurs généraux et des autres utilisateurs de l'évaluation?

- Les évaluations donnent-elles lieu à une amélioration du processus décisionnel en matière de gestion des dépenses (dépenses de programmes directes) et à l'accroissement de l'efficacité, de l'efficience ou des économies du côté des programmes et des politiques?

- Dans quelle mesure l'atteinte des résultats demeure-t-elle possible, compte tenu des capacités et des ressources actuelles?

- Quels sont les principaux facteurs internes et externes qui influent sur l'atteinte (ou la non-réalisation) des résultats attendus?

2.5 Limites

Le Centre d'excellence en évaluation était à la fois le gestionnaire de l'entité évaluée (Politique sur l'évaluation) et un membre de l'équipe d'évaluation. Pour atténuer les préoccupations entourant l'objectivité du Centre dans la réalisation de l'évaluation, les comités consultatifs ont examiné les plans d'évaluation et les produits livrables provisoires; l'équipe externe a joué un rôle de remise en question du travail de l'équipe interne; un processus d'assurance de la qualité a été établi pour les rapports techniques et finaux, dont les équipes d'évaluation externe et interne étaient respectivement responsables; et une théorie de contribution a été appliquée à la Politique sur l'évaluation (voir l'annexe D) afin d'analyser d'autres explications possibles aux résultats observés relativement à la politique.

Pour les études de cas, les ministères ont identifié eux-mêmes des exemples d'évaluation, ce qui conduisait à une possibilité de biais de sélection et de réponse dans les informations fournies au sujet des exemples. Pour valider l'information autodéclarée, l'équipe d'évaluation a examiné et analysé des documents et des documents spécialisés à l'appui. En outre, des consultations ont été menées auprès des représentants des organismes centraux, et des consultations de suivi ont été tenues avec des représentants du ministère provenant à la fois de l'unité d'évaluation et de divers secteurs de programmes.

Dans la plupart des cas, les représentants des organismes centraux n'ont pas été en mesure de commenter des cas particuliers (exemples de programmes ou catégories d'études de cas), puisqu'il y a eu roulement du personnel depuis l'achèvement des évaluations. Dans la mesure du possible, les éléments probants liés à des cas particuliers ont été recueillis; autrement, les observations et les perceptions générales ont été explorées au sujet de l'applicabilité et de l'utilité des exigences de la politique et des autres approches. Dans certains cas, les ministères avaient également connu un roulement ou n'avaient pas donné suite aux demandes de consultations.

Suivant l'une des limites potentielles des études de cas sur le rendement, pour les évaluations récentes menées conformément aux exigences de la politique de 2009, il ne s'est pas écoulé assez de temps pour que ces évaluations puissent être pleinement utilisées. Pour atténuer cette limite, des évaluations réalisées avant 2013 ont été incluses dans les cas sélectionnés.

3.0 Constatations

3.1 Rendement et résultats de la politique

3.1.1 Résultats de base de la politique (questions 5 et 6)

1. Constatation : En général, les besoins des administrateurs généraux et des cadres supérieurs en matière d'évaluation ont été bien servis dans le contexte de la Politique sur l'évaluation de 2009. La haute direction a pu tirer des renseignements stratégiques à l'appui de la prise de décisions au niveau supérieur. Parallèlement, les efforts déployés pour satisfaire aux exigences de portée de la politique ont parfois rendu les services d'évaluation moins en mesure de satisfaire aux besoins émergents de la haute direction.

Les administrateurs généraux qui ont été consultés ont indiqué que, en vertu de la politique de 2009, leur ministère a produit une solide base d'évaluations et qu'il avait la capacité de les utiliser. Les études de cas sur le rendement ont montré que les évaluations satisfaisaient à un vaste éventail de besoins des administrateurs généraux, notamment :

- Fournir des preuves de l'efficacité des programmes à l'appui des décisions de renouvellement;

- Indiquer où les résultats des programmes n'étaient pas susceptibles d'être atteints;

- Révéler des constatations connexes dans le cadre d'une série d'évaluations à l'appui de la prise de décisions stratégiques – par exemple, pour cerner un sujet de préoccupation généralisée.

Les études de cas sur le rendement ont montré que les évaluations ont appuyé la prise de décisions stratégiques en présentant un portrait du rendement des programmes ministériels plus global qu'en vertu de la Politique d'évaluation de 2001. La tendance à l'évaluation de programmes groupés ou d'entités plus grandes, ainsi que la convergence de toutes les évaluations au niveau des comités ministériels d'évaluation (ou comités exécutifs), ont permis aux cadres supérieurs de répertorier des tendances dans de nombreux programmes et évaluations. Les éléments probants issus de consultations ont montré que certains ministères ont produit des analyses transversales à partir de plusieurs évaluations de programmes ciblant des résultats communs. Dans une étude de cas, les renseignements tirés de plusieurs évaluations ont incité un administrateur général à demander l'examen spécial d'un type de mécanisme de financement; dans une autre étude de cas, ces renseignements ont influencé la réaffectation des ressources parmi un ensemble d'activités horizontales hautement prioritaires. Les cadres supérieurs au sein des comités ministériels d'évaluation ont également appliqué les leçons tirées d'évaluations menées dans une autre direction à des programmes exécutés dans leur propre direction.

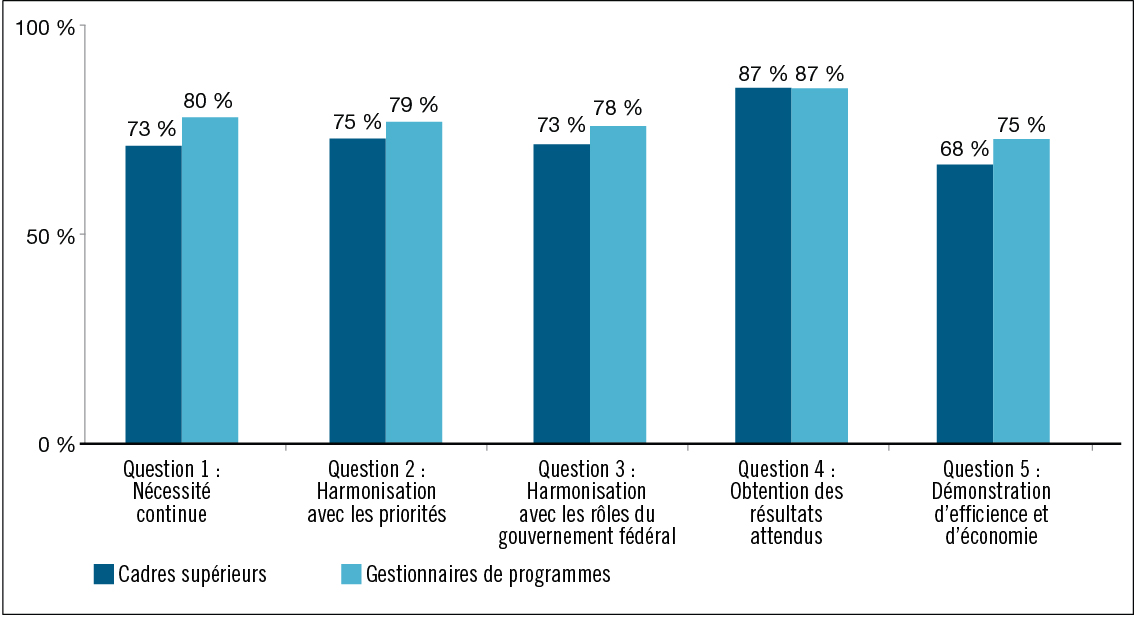

Les données d'enquête ont montré que les gestionnaires de programme estiment que les cadres supérieurs ont été bien servis en vertu de la politique de 2009. Les trois quarts des gestionnaires de programme interrogés (75 %) ont indiqué qu'il était assez utile (38 %) ou très utile (37 %)Note en bas de page 17 pour les cadres supérieurs (sous-ministres, sous-ministres délégués et sous-ministres adjoints) de disposer d'évaluations de leurs programmes tous les cinq ans, comme l'exige la politique. En outre, la majorité des gestionnaires de programme (entre 68 % et 87 %) a estimé que chacune des cinq questions fondamentales était assez utile ou très utile à la haute direction.

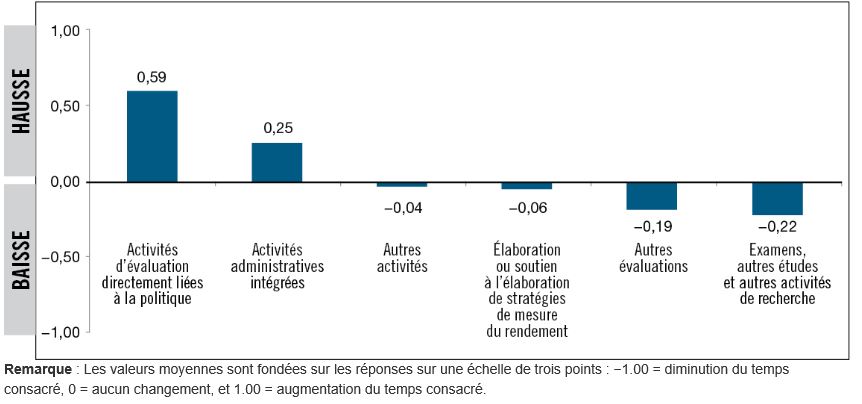

Parallèlement, les études de cas sur le rendement ont montré que, dans certains ministères, les efforts déployés pour satisfaire aux exigences de portée de la politique ont empêché les services d'évaluation de bien répondre aux besoins de la haute direction en matière d'études spéciales, d'évaluations ou d'examens particuliers sur des questions émergentes. Comme le montre la figure 2, la plupart des évaluateurs interrogés ont déclaré que le pourcentage de temps consacré à des activités d'évaluation directement liées à la politique a augmenté après l'entrée en vigueur de la politique de 2009, tandis que le pourcentage de temps consacré à d'autres évaluations, à des examens, à des études ou à des activités de recherche a diminué.

Figure 2 - Version textuelle

La figure montre la variation du pourcentage de temps que les évaluateurs, en moyenne, ont consacré à diverses activités depuis l'entrée en vigueur de la Politique sur l'évaluation de 2009. Les valeurs moyennes de chacune des six activités sont tracées sur une échelle verticale. Les valeurs de zéro à un représentent les activités auxquelles une proportion de temps accrue a été consacrée, et les valeurs de zéro à moins un représentent les activités auxquelles une proportion de temps réduite a été consacrée. Les valeurs moyennes sont basées sur les réponses de l'enquête auprès des évaluateurs, en utilisant une échelle de trois points, où -1,00 indique une diminution de la proportion du temps consacré, zéro signifie que la proportion du temps consacré est restée la même, et 1,00 indique une augmentation de la proportion du temps consacré.

Deux activités ont affiché des valeurs moyennes montrant une augmentation, sur la moyenne de l'ensemble des évaluateurs, de la proportion du temps consacré à des activités d'évaluation directement liées à la politique (valeur moyenne de 0,59) et à des activités administratives intégrées (valeur moyenne de 0,25). Deux activités ont affiché des valeurs moyennes qui ne montrent qu'une légère diminution, sur la moyenne de l'ensemble des évaluateurs, de la proportion du temps consacré à d'autres activités (valeur moyenne de -0,04) et à l'élaboration ou au soutien de l'élaboration de stratégies de mesure du rendement (valeur moyenne de -0,06). Les deux activités restantes affichent des valeurs moyennes qui montrent une diminution, sur la moyenne de l'ensemble des évaluateurs, de la proportion du temps consacré à d'autres évaluations (valeur moyenne de -0,19) et à des examens, d'autres études et d'autres activités de recherche (valeur moyenne de -0,22). La taille de l'échantillon (nombre d'évaluateurs participants) a varié de 41 à 82, selon l'activité.

2. Constatation : La politique a exercé une influence globale positive au chapitre de la satisfaction des besoins des gestionnaires de programmes, et les évaluations initiales de certains programmes ont été utiles. Cependant, les gestionnaires de programmes dont les programmes ont été évalués dans le cadre d'une évaluation en groupe ou comme une entité d'architecture d'alignement des programmes de haut niveau ont parfois trouvé que leurs besoins n'étaient pas aussi bien satisfaits qu'avant 2009, quand leur programme faisait l'objet de sa propre évaluation.

Les gestionnaires de programme interrogés ont estimé que les évaluations étaient utiles à diverses fins. En particulier, 81 % des gestionnaires de programme ont jugé les évaluations comme étant assez utiles (25 %) ou très utiles (56 %) pour soutenir l'amélioration des programmes, et 79 % des gestionnaires de programme ont estimé que les évaluations étaient assez utiles (33 %) ou très utiles (46 %) aux fins de l'élaboration des programmes et des politiques. Des études de cas sur le rendement ont montré que certains gestionnaires de programmes évalués pour la première fois ont acquis des connaissances qui ont mené à des améliorations. En outre, les résultats d'études de cas ont suggéré que ces programmes n'auraient jamais été évalués sans l'exigence de portée complète de la politique.

Parallèlement, un autre résultat de l'examen de la mise en œuvre a montré que les gestionnaires de programme ne trouvent pas toujours que leurs programmes respectifs transparaissent dans les conclusions des évaluations dont l'étendue est harmonisée avec des entités de l'architecture d'alignement des programmes (une base d'analyse courante des évaluations)Note en bas de page 18 ou qui englobent des programmes groupés. Dans ces cas, les évaluations ne leur ont pas fourni des données suffisamment détaillées pour apporter des améliorations au programme. Des études de cas sur le rendement ont illustré que certains ministères ont abordé cette question en concevant ces évaluations de manière à produire des constatations et des conclusions à divers degrés de détails.

Pour ce qui est d'aider les gestionnaires de programme dans le contexte de l'élaboration des stratégies de mesure du rendement, l'influence de la Politique a été mixte. Suivant les résultats de l'examen de la mise en œuvre, les exigences de portée complète et de fréquence ont tenu les services d'évaluation trop occupée pour aider les gestionnaires de programme à mettre au point leurs stratégies dans la même mesure qu'auparavantNote en bas de page 19. Certaines unités d'évaluation ont toutefois souligné leur soutien aux gestionnaires de programme à cet égard, afin de s'assurer que la mesure du rendement appuierait les futures évaluations. L'enquête menée auprès des évaluateurs a montré que, à la suite de l'entrée en vigueur de la politique de 2009, le pourcentage d'évaluateurs qui passent moins de temps à soutenir l'élaboration de stratégies de mesure du rendement (38 %) a légèrement dépassé le pourcentage d'évaluateurs qui y consacrent plus de temps (32 %). Le reste des évaluateurs ont indiqué que le temps consacré à cette tâche était resté le même. Même si certains évaluateurs ont consacré moins de temps à soutenir l'élaboration de stratégies de mesure du rendement, 90 % des gestionnaires de programme interrogés en 2014 ont indiqué que leurs programmes étaient assortis d'une stratégie de mesure du rendement. En ce qui concerne les programmes dotés d'une stratégie de mesure du rendement en place, 93 % des gestionnaires de programme avaient consulté leur fonction ministérielle d'évaluation lors de l'élaboration des stratégies.

3. Constatation : Les organismes centraux ont constaté que les évaluations étaient de plus en plus disponibles, et, à l'instar des ministères, ils les utilisaient de plus en plus pour éclairer des activités de gestion des dépenses comme les propositions de dépenses (en particulier, les renouvellements de programmes) et les examens des dépenses. Parallèlement, il est arrivé souvent que les évaluations ne répondent pas aux besoins des organismes centraux en matière de renseignements sur l'efficience et l'économie des programmes.

Les analystes des organismes centraux ont généralement considéré les évaluations comme une source d'information clé sur les programmes et il est arrivé souvent qu'ils les consultent en premier lieu dans le cadre de leur analyse des propositions de dépensesNote en bas de page 20. Des études de cas sur le rendement et des consultations auprès des intervenants ont montré que les analystes du Secrétariat avaient généralement encouragé l'utilisation par les ministères des résultats d'évaluation dans les présentations au Conseil du Trésor, qu'ils avaient continuellement exigé des renseignements d'évaluation aux fins des renouvellements de financement en particulier, et qu'ils avaient recommandé que les ministères ne demandent pas d'approbation de financement sans une évaluation récente à l'appui. Les analystes du Secrétariat ont indiqué que, avant la politique de 2009, les évaluations n'étaient pas toujours disponibles à l'appui des présentations au Conseil du Trésor, mais qu'aujourd'hui, si des projets de présentations ne renferment pas de renseignements d'évaluation, les analyses demandent souvent ces renseignements aux ministères. En outre, lorsque des résultats d'évaluation sont négatifs, les analystes demandent aux ministères de confirmer que des correctifs ont été adoptés.

Plusieurs éléments de preuveNote en bas de page 21 ont révélé que les évaluations étaient plus largement utilisées comme source de renseignements à l'appui des présentations au Conseil du Trésor et, dans une moindre mesure, des mémoires au Cabinet. Dans le cadre de l'enquête d'évaluation de la capacité, 96 % des grandes organisations ont déclaré en 2012-2013 qu'elles avaient utilisé la totalité ou la quasi-totalité des évaluations pertinentes pour éclairer les présentations au Conseil du Trésor, et 78 % ont déclaré avoir utilisé la totalité ou la quasi-totalité des évaluations pertinentes pour éclairer les mémoires au Cabinet. Ces résultats se comparent à ceux de l'enquête de 2008-2009, avant la politique de 2009, où 74 % des grandes organisations avaient déclaré presque toujoursNote en bas de page 22 tenir compte des résultats d'évaluation dans les présentations au Conseil du Trésor et où 51 % avaient indiqué presque toujours en tenir compte dans les mémoires au Cabinet. La plupart des grandes organisations ont établi un processus officiel d'inclusion des renseignements d'évaluation dans les présentations (79 %) et les mémoires au Cabinet (65 %) en 2013-2014. Les évaluations ont été couramment utilisées pour soutenir le renouvellement de dépenses en cours, notamment pour les programmes permanents de subventions et de contributionsNote en bas de page 23. Les analystes des organismes centraux ont généralement utilisé les renseignements d'évaluation afin d'éclairer leurs conseils aux ministres du Conseil du Trésor, et certains ont fait remarquer qu'ils ont reçu régulièrement des questions du Cabinet au sujet des résultats d'évaluation.

Sur la base d'études de cas sur le rendement et l'application, et de consultations auprès des intervenants, l'utilisation et l'utilité des évaluations, en particulier du côté des organismes centraux, ont été affectées par la façon dont le calendrier d'évaluation a concordé avec le calendrier des décisions de dépenses. Les organismes centraux ont parfois signalé que les évaluations sont arrivées trop tard pour éclairer convenablement les décisions de renouvellement. Par exemple, il a été signalé que les discussions clés sur le renouvellement sont souvent tenues un an ou plus avant qu'une présentation au Conseil du Trésor soit rédigée. Dans ces cas, une évaluation qui est terminée tout juste à temps pour être annexée à la présentation peut être considérée comme arrivant trop tard pour aider les analystes des organismes centraux. Il convient également de préciser, cependant, que dans les ministères, les rapports d'évaluation provisoires sont souvent mis à la disposition des gestionnaires de programme beaucoup plus tôt, ce qui leur permet de tirer parti des conclusions et des connaissances produites, même si le rapport n'a pas été entièrement approuvé.

Si l'on se fie à l'examen de la mise en œuvre et aux consultations menées dans le cadre des études de cas auprès de représentants des organismes centraux, il appert que l'utilité de l'évaluation a également été affectée par la façon dont l'étendue de l'évaluation correspond à l'unité de dépense qui a fait l'objet d'une décision. Lors de l'analyse et de la prestation de conseils entourant les mémoires au Cabinet ou les présentations au Conseil du Trésor, les besoins en matière d'information des organismes centraux avaient tendance à être propres à un projet ou à un programme, c'est-à-dire propres à l'unité du financement renouvelé. Lorsque les évaluations avaient une vaste portée, comme un programme d'une architecture d'alignement des programmes, elles ne fournissaient pas des renseignements suffisamment détaillés. Des études de cas et des consultations auprès des intervenants ont montré qu'il arrivait souvent que les évaluations ne satisfaisaient pas aux besoins d'information des organismes centraux concernant l'efficience et l'économie des programmes, par exemple, parce que l'analyse par les évaluateurs des organismes centraux du rapport coût-efficacité des programmes avait été limitée par des renseignements financiers structurés de manière incompatible. Les organismes centraux voulaient aussi de meilleurs éléments probants sur les autres programmes dans le cadre de comparaisons dans l'ensemble de l'administration fédérale et de comparaisons intergouvernementales. Suivant l'un des principaux risques associés à des évaluations qui ne répondent pas aux besoins en matière d'information des organismes centraux, l'analyse et les conseils dispensés aux ministres par les organismes centraux au sujet des propositions ministérielles peuvent ne pas être aussi bien étayés de preuves neutres qu'ils pourraient l'être.

L'utilisation de moyenne à élevéeNote en bas de page 24 des évaluations dans le cadre des examens de dépenses (par exemple, des examens stratégiques) a été rendue possible par la disponibilité et la pertinence accrues des évaluationsNote en bas de page 25, et la plupart des membres des comités ministériels d'évaluation et des cadres supérieurs qui ont été consultés, y compris les administrateurs généraux consultés en 2014, ont rapporté un haut degré d'utilité de l'évaluation en ce sens. Près des deux tiers des évaluateurs interrogés ont déclaré des impacts positifs sur l'utilité des évaluations au regard des examens de dépenses en raison de l'exigence de portée complète (63 %) et de l'obligation touchant les questions fondamentales (62 %) de la politique. Les administrateurs généraux consultés par le Secrétariat du Conseil du Trésor du Canada en 2010 ont indiqué que les examens stratégiques avaient rehaussé le profil de la fonction d'évaluation en exigeant que les ministères s'attaquent systématiquement aux problèmes fondamentaux de pertinence des programmes. La majorité des gestionnaires de programme interrogés (63 %) ont indiqué que les évaluations étaient assez utiles (44 %) ou très utiles (19 %) aux fins des examens des dépenses. La plupart des analystesNote en bas de page 26 de programme du Secrétariat ont signalé que les évaluations avaient soutenu leur analyse lors des examens de dépenses et que, dans de nombreux ministères, ces examens ont fait augmenter la demande d'évaluations et que l'attention portée par les cadres supérieurs avait mis en valeur toute l'utilité de la fonction d'évaluation.

4. Constatation : Le recours à l'évaluation en vertu de la politique de 2009 a été significatif, mais l'utilisation et l'incidence pourraient être accrues en s'assurant que les évaluations réalisées, ainsi que leur calendrier, leur étendue et leur orientation, correspondent plus étroitement aux besoins des utilisateurs.

Avant l'entrée en vigueur de la politique de 2009, des faiblesses au chapitre de l'utilisation de l'évaluation avaient été consignéesNote en bas de page 27. Après 2009, la surveillance et les rapports du Secrétariat ont révélé une utilisation intensive de l'évaluation pendant la période de transition de la politique. Dans le cadre de l'enquête d'évaluation de la capacité de 2012-2013, les grands ministères ont signalé des taux élevés de mise en œuvre des réponses et des plans d'action de la direction; sur les 901 éléments du plan d'action de la direction qui devaient être achevés en 2012-2013, 53 % ont été entièrement mis en œuvre avant la fin de l'exercice, et 21 % ont été partiellement mis en œuvre. En outre, les cotes attribuées dans le cadre d'examens inhérents au Cadre de responsabilisation de gestion ont fait état d'une vaste utilisation de l'évaluation; plus de 96 % des grands ministères ont été jugés acceptables ou solides au titre de l'utilisation de l'évaluation en 2013-2014, comparativement à 77 % des grands ministères en 2007-2008 et 78 % en 2008-2009.

Lorsqu'ils ont été consultés à l'automne 2010, de nombreux administrateurs générauxNote en bas de page 28 ont déclaré que l'évaluation apportait une solide contribution à la prise de décisions, mais un certain nombre d'administrateurs généraux ont estimé qu'il était possible d'en faire davantage. Lorsqu'ils ont été consultés en 2014, les administrateurs généraux ont reconnu l'utilité des évaluations aux fins de l'amélioration et de l'élaboration des politiques et des programmes, des examens stratégiques et comme moyen de conserver la mémoire institutionnelle, tout en signalant qu'il y avait parfois eu des problèmes de calendrier, d'orientation et d'échelle (niveau d'intensité) des évaluations.

Dans le cadre des études de cas, les évaluations ont été considérées comme les plus utiles quand elles étaient menées en temps opportun, quand elles fournissaient de nouvelles informations, et quand elles ne consistent pas simplement à cerner de nouveau des problèmes d'exécution des programmes que les utilisateurs connaissaient déjà. Les évaluations ont été considérées comme moins utiles quand elles ne pouvaient pas mener à l'apprentissage organisationnel, quand il n'y avait pas de décision à éclairer, ou quand aucune mesure ne pouvait être prise. Les organismes centraux ainsi que les gestionnaires de programme, les chefs de l'évaluation et les évaluateurs ont noté des situations dans lesquelles les évaluations étaient moins utiles, y compris lorsque leur calendrier, leur étendue, leur orientation, la longueur de leur rapport et leur niveau de rigueur analytique ne correspondaient pas aux besoins ou aux intérêts des décideurs. Parmi les principaux risques associés à la production d'évaluations de faible utilité, mentionnons le fait de dépenser inefficacement des ressources d'évaluation, plutôt que d'affecter les ressources à des évaluations qui seraient plus utiles et, de façon plus générale, de diminuer la valeur perçue de la fonction d'évaluation dans son ensemble.

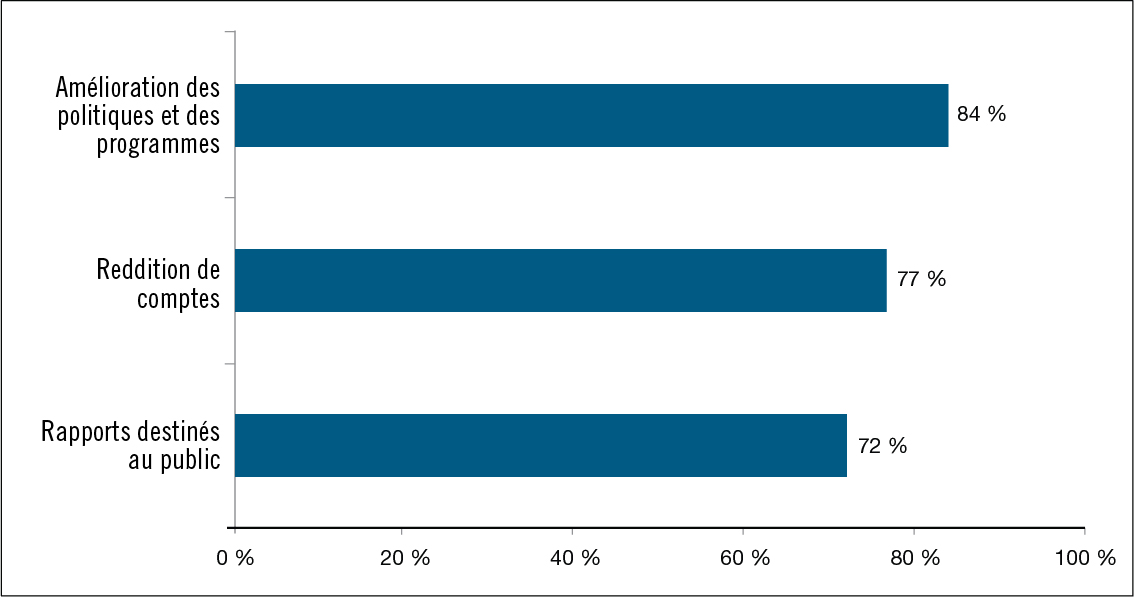

5. Constatation : Les évaluations réalisées ont eu comme incidence principale de soutenir l'amélioration des politiques et des programmes.

Des analyses effectuées par le Centre d'excellence en évaluation ont révélé que 75 % des rapports d'évaluationNote en bas de page 29 achevés en 2010-2011 comportaient des recommandations pour améliorer les processus des programmes. De même, pour l'ensemble des évaluations examinées dans les études de cas sur le rendement, la plupart des recommandations portaient sur l'amélioration des programmes, et toutes ont été effectivement suivies à cette fin. Les études de cas sur le rendement ont également montré que la quasi-totalité des évaluations examinées avaient servi à l'amélioration des programmes et que certaines évaluations avaient abouti à des améliorations à un plus vaste éventail de programmes que celui évaluéNote en bas de page 30. D'autres études de cas sur le rendement ont toutefois aussi montré que certaines évaluations n'avaient pas été utilisées à des fins d'amélioration lorsque des décisions internes n'avaient laissé aucune possibilité de mise en œuvre des recommandations – par exemple, lorsque le programme avait été éliminé ou complètement réorganisé. La preuve a démontré que, dans le cadre de l'examen de la pertinence et du rendement des programmes, les évaluations contribuaient parfois à des gains d'efficience opérationnelle, mais que ces gains se traduisaient rarement par des économies de coûts directs.

Parmi une liste d'utilisations possibles de l'évaluation, les gestionnaires de programmes ont classé l'amélioration des politiques et des programmes comme celle qui avait été la plus utile; 81 % des gestionnaires de programme ont déclaré que les évaluations étaient assez utiles (25 %) ou très utiles (56 %) dans cette optique. Dans l'ensemble, les évaluateurs et les gestionnaires de programme ont signalé que la politique avait eu un effet positif ou neutre sur l'utilité des évaluations pour éclairer l'amélioration des politiques et des programmes; 56 % des évaluateurs et 35 % des gestionnaires de programme ont indiqué que l'utilité des évaluations avait augmenté, alors que seule une petite proportion (9 % et 5 % respectivement) a déclaré que leur utilité avait diminué. Le reste (35 % des évaluateurs et 60 % des gestionnaires de programme) a déclaré que l'utilité était restée la même.

La preuve a démontré que l'utilisation des évaluations à des fins de reddition de comptes et de rapports publics avait augmenté, et les gestionnaires de programme et les évaluateurs ont indiqué que la politique avait eu un effet positif sur l'utilité des évaluations à ces finsNote en bas de page 31. Dans le Rapport de du vérificateur général du Canada, il est précisé que les rapports sur le rendement présentés au Parlement faisaient trop peu usage des résultats d'évaluation; en 2011, l'enquête annuelle d'évaluation de la capacité a montré qu'une forte proportion des grandes organisations (89 %) tenaient compte d'au moins 80 % de leurs évaluations lors de la préparation de leurs rapports ministériels annuels sur le rendement. En 2013-2014, l'enquête annuelle d'évaluation de la capacité a révélé que 91 % des grandes organisations avaient instauré des processus officiels pour s'assurer que les rapports d'évaluation étaient pris en considération dans les rapports au Parlement.

Des études de cas sur le rendement ont montré que les organisations affichaient habituellement les rapports d'évaluation, y compris les réponses et les plans d'action de la direction, sur leurs sites Web, bien que dans certains cas, l'affichage survenait longtemps après l'achèvement de l'évaluation. Dans les études de cas sur le rendement, un petit nombre d'intervenants ont suggéré qu'une partie du décalage entre l'achèvement fonctionnel du travail d'évaluation et l'approbation et la publication de rapports était attribuable aux discussions internes entourant la préparation des rapports destinés au public, qui ont mené dans certains cas à des rapports moins critiques.

6. Constatation : Le recours accru aux évaluations pour soutenir la prise de décisions a été favorisé par le changement de culture observé en faveur de la valorisation et de l'utilisation des évaluations.

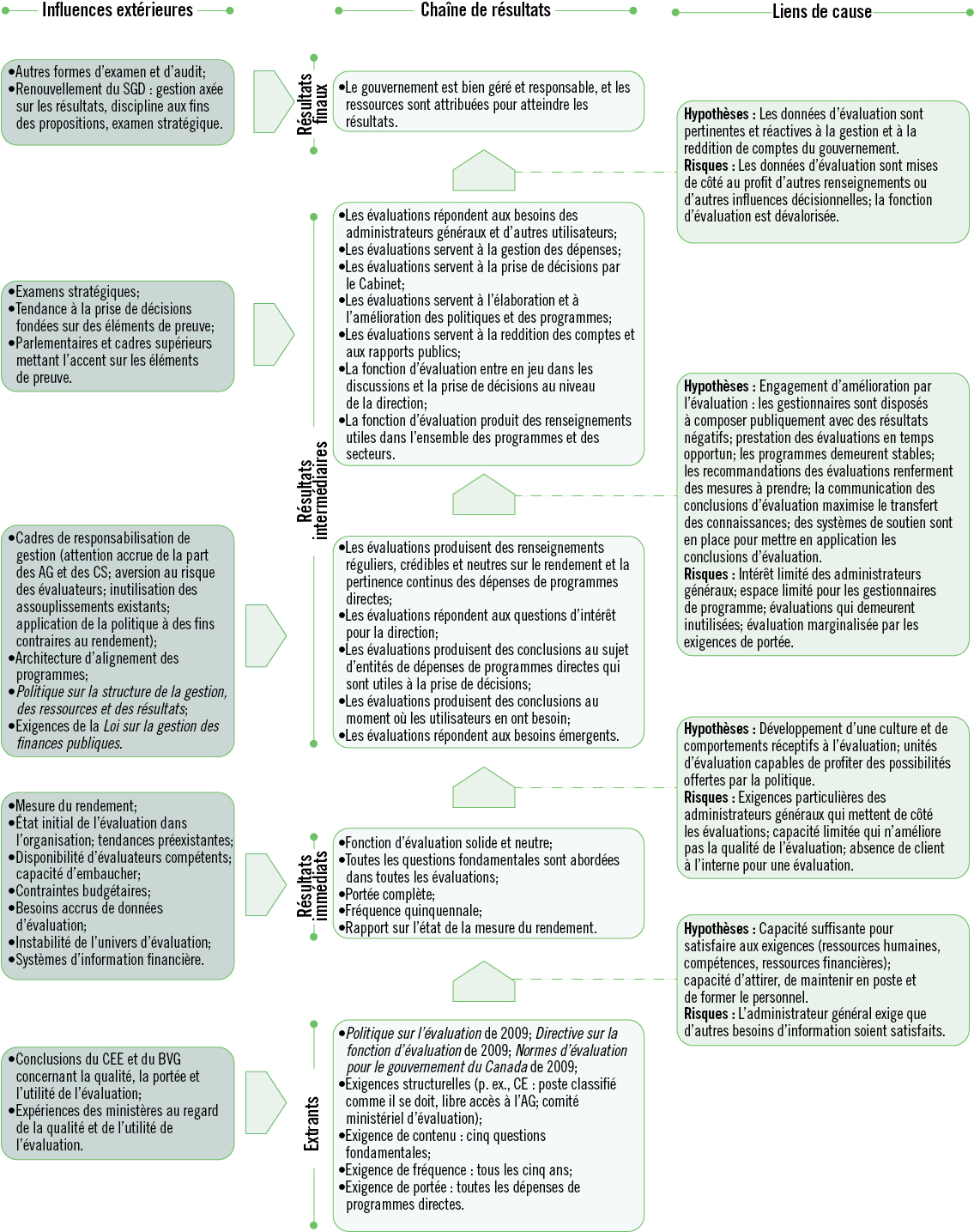

Des conditions clés ont dû être établies pour que la politique permette d'obtenir les résultats visés sous l'angle de l'utilisation des évaluationsNote en bas de page 32. Selon la théorie du changement mise au point aux fins de la Politique sur l'évaluation (voir l'annexe D), la politique visait à instaurer un changement de culture dans les ministères de manière à accroître la valeur et la confiance accordée à l'évaluation, ainsi que son évaluation. Ce changement de culture a été mis en évidence par :

- Le changement observé sur le plan des perceptions des intervenantsNote en bas de page 33 qui, plutôt que de considérer les évaluations comme un élément alourdissant le fardeau de la surveillance des programmes, ont commencé à prendre conscience de la valeur des évaluations et des compétences offertes par l'unité d'évaluationNote en bas de page 34;

- L'intensification du dialogue ministériel relatif à l'évaluation depuis 2009, comme l'ont déclaré 71 % des évaluateurs et 46 % des gestionnaires de programme interrogésNote en bas de page 35;

- Les taux élevés de mise en œuvre des recommandations, favorisés par l'établissement de systèmes de suivi de la mise en œuvre des recommandations d'évaluation, que 97 % de tous les grands ministères avaient déclaré avoir mis en place en 2013-2014Note en bas de page 36.

L'intérêt plus général des administrateurs généraux pour l'évaluation a probablement contribué dans une grande mesure aux résultats observésNote en bas de page 37. Les évaluations, sous l'angle du Cadre de responsabilisation de gestion, des fonctions ministérielles d'évaluation ont permis d'attirer l'attention de la direction et elles ont été partiellement responsables d'apporter une plus grande visibilité à l'évaluation. Une analyse des cotes des examens du Cadre de responsabilisation de gestion de 2006-2007 à 2011-2012 a révélé une tendance à la hausse de l'utilisation de l'évaluation, et de la portée, de la gouvernance et du soutien, et de la qualité des rapports d'évaluation.

3.1.2 Facteurs ayant une incidence sur l'obtention de résultats (question 8)

7. Constatation : Les facteurs qui ont eu l'influence positive la plus évidente sur le recours à l'évaluation dans les ministères ont été les éléments de politique liés à la gouvernance et au leadership de la fonction d'évaluation, alors que les facteurs qui ont entravé le plus évidemment le recours à l'évaluation ont été ceux qui ont trait aux ressources et aux calendriers.

Dans l'ensemble des éléments de preuve, la mobilisation des hauts dirigeants en faveur des fonctions ministérielles d'évaluation a semblé avoir l'influence positive la plus nette sur l'utilisation de l'évaluation. Cette influence a été attribuée, au moins en partie, aux exigences de la politique relatives à la gouvernance et au leadership (par exemple, les rôles et les responsabilités définis des administrateurs généraux, des comités ministériels d'évaluation et des chefs de l'évaluation, et le libre accès à l'administrateur général accordé au chef de l'évaluation), et à un climat, à l'échelle du gouvernement, qui a mis l'accent sur la gestion axée sur les résultats et sur la prise de décisions fondée sur des données probantes. La mobilisation accrue de la haute direction a mené à une mise en œuvre intensifiée des plans d'action et elle a rehaussé la visibilité globale de la fonction d'évaluation. La présence d'administrateurs généraux dans la plupart des comités ministériels d'évaluation a permis de faire en sorte que les résultats d'évaluation soient pris au sérieux, et le contrôle exercé par un niveau exécutif supérieur pourrait avoir contribué à l'augmentation de la qualité de l'évaluation.

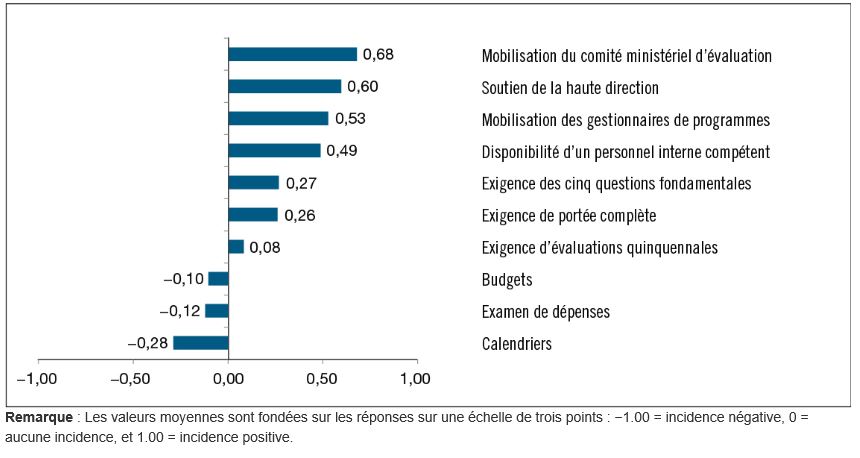

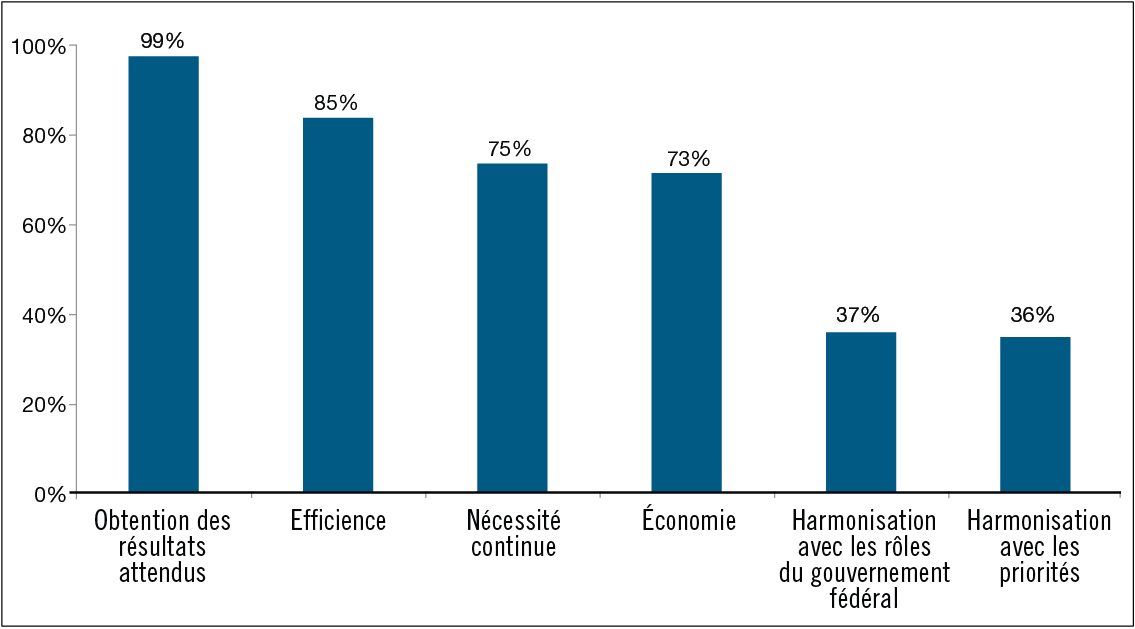

Comme on peut le voir à la figure 3, les évaluateursNote en bas de page 38 ont indiqué que l'engagement des comités ministériels d'évaluation, des cadres supérieurs et des gestionnaires de programmes, ainsi que la disponibilité d'un personnel d'évaluation qualifié à l'interne, avaient eu une influence positive sur l'obtention des résultats de la politique. Les évaluateurs ont indiqué que ces facteurs ont eu une incidence positive sur l'utilisation et l'utilité plus souvent que les exigences de la politique concernant la couverture complète des dépenses de programmes directes, les évaluations quinquennales, et l'examen des cinq questions fondamentales.

Les évaluateurs interrogés ont déclaré que les influences négatives les plus évidentes sur l'utilité de l'évaluation sont attribuables aux calendriers des projets d'évaluation, aux budgets des projets d'évaluation, et aux examens des dépenses. Même si le Secrétariat du Conseil du Trésor du Canada n'a pas assuré de suivi des changements des budgets des projets individuels d'évaluation, les ressources financières gouvernementales pour l'évaluation ont été inférieures de 8 % en 2012-2013, par rapport à 2008-2009, avant l'entrée en vigueur de la politique, malgré une augmentation initiale la première année de mise en œuvre de la politique de 2009. Les études de cas sur le rendement ont fourni des renseignements additionnels sur l'influence des examens de dépenses en tant que facteur externe sur l'utilité de l'évaluation : dans certains cas, les évaluations n'ont pas pu être utilisées à des fins d'amélioration des programmes parce que les dépenses de programmes avaient été sensiblement modifiées ou interrompues. Les gestionnaires de programme et les cadres supérieurs ont également noté que la contribution des évaluations à la prise de décisions pourrait être affectée par la disponibilité d'autres formes de surveillance et d'examen, comme les examens de dépenses, surtout quand certaines des informations d'entrée étaient disponibles dans plusieurs sources.

(N = 98 à 141)

Figure 3 - Version textuelle