Guide sur l’évaluation rapide de l’impact

Utilisation du présent document

Le présent guide donne un aperçu de la méthode d’évaluation rapide de l’impact (ERI) et de son meilleur usage au sein du gouvernement du Canada. Il est fondé sur les résultats de trois projets pilotes menés dans trois ministères fédéraux. Les projets pilotes ont utilisé une approche à méthodes mixtes et, par conséquent, ils ne devraient pas être considérés comme des modèles définitifs en ce qui concerne l’utilisation de l’ERI dans d’autres contextes. Les ministères sont priés d’adapter la méthode d’ERI en fonction de leurs exigences et de leurs besoins particuliers.

Remerciements

Le guide a été élaboré par le Centre d’excellence en évaluation du Secrétariat du Conseil du Trésor du Canada. Il est fondé sur des projets pilotes appuyés par M. Andy Rowe, Ph. D, qui a conçu la méthode d’ERI en 2004 et 2005 pour évaluer les effets environnementaux et économiques des décisions liées à la gestion des ressources naturelles.

La Division des résultats tient à remercier M. Rowe de son soutien et de ses conseils, ainsi que Ressources naturelles Canada, l’Agence de la santé publique du Canada et Sécurité publique Canada de leur participation aux projets pilotes. La Division remercie également les ministères et organismes qui ont examiné les versions préliminaires du présent document et fournit des commentaires.

Résumé : Qu’est-ce qu’une évaluation rapide de l’impact?

L’évaluation rapide de l’impact (ERI) offre une façon structurée de recueillir des jugements d’experts sur l’impact d’un programme. Une ERI fait appel à un certain nombre d’experts pour obtenir une juste perspective des impacts d’un programme et, au bout du compte, accroître l’acceptation et l’adoption des conclusions de l’ERI. Chaque expert évalue les résultats du programme par rapport à uncontrefactuel, lequel est un modèle de rechange du programme ou une autre situation, pour en évaluer l’impact par rapport aux solutions de rechange. Trois types d’experts sont consultés :

- intervenants du programme ayant une incidence sur le programme ou qui sont touchés par celui-ci;

- experts en la matière provenant de l’extérieur;

- conseillers techniques.

Temps requis pour une ERI

Selon la disponibilité des experts, une période de deux à six mois est nécessaire pour effectuer une ERI. Il est également nécessaire de consacrer du temps à l’apprentissage lorsqu’une organisation effectue une ERI pour la première fois.

Ressources requises pour une ERI

Selon le modèle d’évaluation, une ERI exige uniquement des ressources de faibles à moyennes.

Principaux avantages d’une ERI

Une ERI :

- est une méthode relativement rapide et peu coûteuse par rapport à d’autres méthodes d’évaluation et ne nécessite pas de données existantes sur le rendement, ce qui lui permet d’être utilisé pendant et après la conception du programme;

- résume clairement et quantitativement les évaluations d’experts sur l’impact d’un programme par rapport à la solution de rechange, ce qui aide à éclairer les cadres, les gestionnaires et les analystes de programme;

- permet de donner la priorité à l’obtention de perspectives externes, qui mettent parfois en évidence des points de vue intéressants qui ne sont pas toujours pris en compte dans les évaluations des programmes fédéraux et qui renforcent la légitimité et l’exactitude d’une évaluation;

- permet de comparer les différentes versions du programme au moyen d’un contrefactuel;

- appuie l’utilisation de l’évaluation au moyen d’une vaste mobilisation effectuée au cours de son exécution.

Quand utiliser une ERI

Il est recommandé d’utiliser une ERI dans les cas suivants :

- une évaluation appréciera l’impact d’un programme, mais ne peut observer ou estimer raisonnablement les effets du programme, d’une intervention au programme ou dans son contrefactuel, ce qui rend difficile l’utilisation d’autres méthodes d’évaluation comme les modèles expérimentaux ou quasi expérimentaux);

- il est avantageux de comparer l’impact de plusieurs versions d’un programme, par exemple, lors de sa conception ou de son renouvellement;

- il faut obtenir des points de vue provenant de l’extérieur du programme ou de la fonction publique, notamment ceux d’experts en la matière.

Glossaire

conseiller technique

expert interne ou externe (bien qu’il soit hors du programme) dans un domaine précis lié à l’évaluation, comme dans le contexte général du programme ou d’un domaine technique ou scientifique relatif au programme.

expert en la matière

universitaire ou autre expert interne possédant une expertise générale dans le champ d’activité du programme.

impact différentiel

la différence entre ce qui s’est produit lors d’une intervention et ce qui se serait produit dans une autre situation (le contrefactuel). Un impact différentiel est donc l’effet « supplémentaire » ou différentiel du programme sur un résultat, au-delà de l’effet que le contrefactuel n’aurait pu obtenir.

impact général

mesure agrégée, en pourcentage, de l’impact différentiel du programme pour l’ensemble des résultats. Par exemple, les experts en la matière peuvent évaluer à 15 % l’impact général du programme, ce qui signifie que la présence du programme, par rapport au contrefactuel, a entraîné un impact global de 15 % plus important.

Impacte

Effet à long terme, positif ou négatif, primaire ou secondaire, induit par une intervention à l’étape de développement, directement ou non, et intentionnellement ou nonVoir la note en bas de page 1. La définition des effets non intentionnels est un point fort de l’ERI parce qu’elle tient compte de nombreux points de vue.

intérêt

perspective ou point de vue sur un problème. Les intervenants du programme dont les intérêts doivent être pris en compte peuvent comprendre, entre autres, les bénéficiaires du programme, le gestionnaire du programme, les partenaires de mise en œuvre, les cadres et d’autres. Il est utile de disposer d’une définition suffisamment large des intérêts afin de veiller à ce que tous les points de vue pertinents soient obtenus.

intervenant du programme

personne qui a une incidence directe sur le programme ou est touchée directement par celui-ci, et a une connaissance approfondie de son fonctionnement.

résultat

conséquence externe attribuable en partie, à une organisation, à une politique, à un programme ou à une initiative. Les résultats ne découlent pas d’une seule organisation, d’une politique, d’un programme ou d’une initiative, mais ils s’inscrivent dans la zone d’influence de l’organisation.

résultat direct

effet découlant directement d’un programme ou d’une intervention. De tels effets sont généralement des résultats immédiats ou intermédiaires, selon l’intervention. Les « résultats directs » sont utilisés, car il est plus facile pour les experts de déterminer la probabilité et l’importance des effets d’un programme sur les résultats directs plutôt que sur les résultats indirects.

1.0 Introduction et aperçu

Une ERI est une façon structurée de recueillir des jugements d’experts sur l’impact d’un programme. Les ERI comprennent trois étapes principales :

- Les évaluateurs créent un sommaire du programme, qui :

- établit un consensus entre les groupes d’intervenants;

- cerne des questions d’évaluation robustes et pertinentes;

- affirme la légitimité des résultats et la probabilité qu’ils soient utilisés.

- Les évaluateurs communiquent constamment avec trois groupes d’experts pour obtenir leur évaluation de l’impact de l’intervention par rapport à l’impact du contrefactuel fondé sur un scénario.

- Les jugements d’experts sont analysés, pondérés et regroupés pour connaître l’impact général estimé du programme.

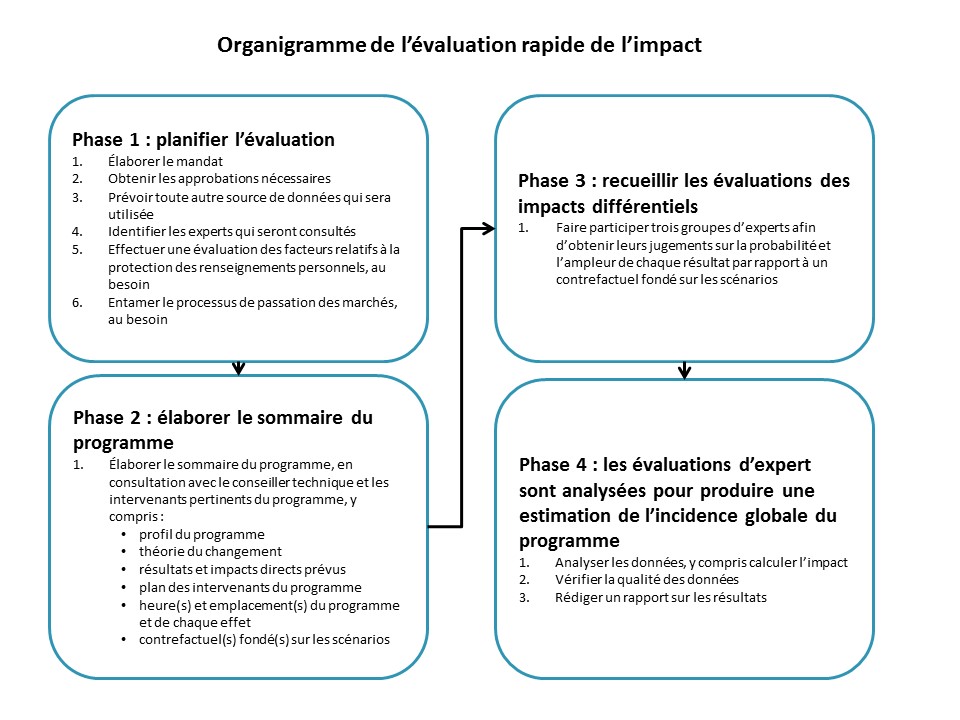

Ces étapes, ainsi qu’une étape de planification initiale, sont saisies dans l’organigramme de l’ERI à l’annexe A du présent guide.

Le contrefactuel fondé sur un scénario constitue la base d’une ERI. En consultation avec les groupes pertinents, l’évaluateur trouve une solution de rechange à l’intervention évaluée. L’objectif est de décrire ce qui aurait pu se produire si le programme avait été mis en œuvre différemment. La solution de rechange doit être plausible, faisable et légale. Les experts apprécient les résultats du programme évalué et ceux du contrefactuel.

Dans quelle mesure les ERI sont-ils fiables?

Les ERI sont une nouvelle méthode et il y a encore peu de littérature et d’orientation à ce sujet. Les essais ont démontré que les ERI ont une forte fiabilité interne, atteignant un coefficient alpha de Cronbach (une mesure courante de cohérence interne) de plus de 0,9 (excellent). La validité externe est bonne aussi par rapport aux prévisions techniques et aux observations empiriques subséquentes. Les résultats de l’ERI lors des projets pilotes correspondaient à ceux du reste de l’évaluation, avec une source de données complémentaire. On ne cherche pas à remplacer un modèle expérimental ou quasi expérimental approprié, mais plutôt à offrir une source de données supplémentaire visant à compléter d’autres méthodes d’évaluation.

Tout comme un groupe témoin dans un modèle expérimental, le contrefactuel rend possible l’évaluation de l’impact différentiel (la différence attribuable au programme) par rapport à ce qui se serait produit dans le cas d’un autre type de mise en œuvre du programme. Sans le contrefactuel, l’évaluation ne peut déterminer l’impact différentiel, car elle ne peut indiquer ce qui se serait produit si les choses s’étaient passées différemment.

La méthode d’ERI a été conçue en 2004 et 2005 par Andy Rowe, Ph. D, dans le but d’évaluer les effets économiques et environnementaux des décisions liées à la gestion des ressources naturelles. Depuis, elle a été utilisée dans le Sud-Est asiatique, aux États-Unis et ailleurs.

Entre mai 2015 et avril 2016, l’ERI a été mise à l’essai au sein des trois ministères suivants :

- l’Agence de la santé publique du Canada;

- Sécurité publique Canada;

- Ressources naturelles Canada.

Le présent guide est fondé sur les leçons apprises dans le cadre de ces projets pilotes.

Dans l’ensemble, l’ERI peut être une méthode rapide et efficace pour recueillir des jugements d’experts sur l’impact d’un programme, en quelques mois. Toutefois, elle peut également avoir une courbe d’apprentissage considérable à mesure que les ministères apprennent la méthode d’ERI et l’adaptent.

2.0 Quand utiliser une évaluation rapide de l’impact

Les projets pilotes ont utilisé l’ERI dans des contextes plutôt simples où l’élaboration d’un contrefactuel probant a permis à des experts d’évaluer l’impact du programme d’une façon relativement simple. Si le programme ou le contrefactuel est compliqué ou mal compris, l’ERI perd de son efficacité. Cela dit, quelle que soit la méthode, un programme complexe peut être difficile à évaluer. Or, l’ERI peut produire des estimations pour des impacts très compliqués. L’ERI peut être très efficace quand l’évaluateur doit évaluer l’impact, mais n’a pas accès à d’autres méthodes d’évaluation, comme les modèles d’étude de cas expérimentaux, quasi expérimentaux ou comparatifs (par exemple, pour des motifs logistiques, temporels ou éthiques).

L’ERI s’avère également utile lorsque les évaluateurs s’intéressent aux perspectives externes sur l’impact d’un programme, entre autres lorsqu’il s’adresse directement aux Canadiens ou qu’il est fondé sur un programme d’envergure internationale. La participation de divers intervenants peut aider l’évaluateur à veiller à ce que l’évaluation soit fondée sur les meilleures questions possible et approfondit ses connaissances du programme. L’ERI peut fournir un tableau plus complet des forces et des faiblesses du programme au-delà de ce qui peut être apparent aux autres. Par conséquent, l’ERI peut être utile lorsqu’il y a des évaluations contradictoires sur l’impact du programme.

Finalement, l’ERI est peut-être la méthode la plus précieuse lorsque l’évaluation cherche à comparer plusieurs versions d’une intervention potentielle, comme pendant la conception ou le renouvellement du programme. Dans une telle situation, l’ERI peut être menée avant ou après la mise en œuvre du programme afin de déterminer le mérite relatif de plusieurs modèles, autrement dit :

- changer de cap ou rajuster l’orientation du programme en cours de mise en œuvre;

- tirer des leçons après la mise en œuvre du programme et éclairer les itérations subséquentes.

L’ERI possède un avantage sur d’autres méthodes d’évaluation par sa capacité de comparer plusieurs scénarios à l’aide d’un contrefactuel fondé sur un scénario.

Dans bien des cas, il est logique d’adopter une approche à méthodes mixtes et d’utiliser une version de l’ERI conjuguée à d’autres méthodes d’évaluation. Une telle approche a été adoptée pour les projets pilotes. Diverses méthodes et techniques, en fonction de contraintes liées aux ressources, aux échéanciers et aux objectifs, ont été utilisées pour répondre aux questions de l’évaluation.

Par exemple, un évaluateur peut décider de ne pas créer de sommaire du programme, mais plutôt d’utiliser une méthode structurée pour mener les sondages et les ateliers décrits ci-dessous en vue d’obtenir des jugements d’experts sur l’impact du programme. Autrement, l’évaluateur pourrait aussi déterminer qu’il a recueilli assez de données sur l’impact du programme avec son approche actuelle, mais qu’il aimerait créer un sommaire du programme pour établir un consensus et affirmer la légitimité des constatations et la probabilité que les recommandations soient adoptées.

3.0 Contrefactuels

Un élément clé de l’ERI est le contrefactuel. Un contrefactuel fondé sur un scénario est une solution de rechange pour ce qui s’est produit. Autrement dit, il s’agit d’une approche ou d’un modèle différent à l’exécution dont les objectifs sont les mêmes que ceux évalués. Les experts évaluent les effets du contrefactuel de la même façon qu’ils évaluent les effets du programme réel. De cette façon, l’évaluation peut déterminer ce qui se serait produit si la situation était différente et démontrer les effets relatifs de plusieurs options. Le choix d’un bon contrefactuel est donc l’une des étapes les plus importantes de l’évaluation. Sans un bon contrefactuel, il est impossible d’évaluer l’impact différentiel.

Une évaluation peut comprendre un ou plusieurs contrefactuels. L’un des points forts de l’ERI est qu’elle permet de comparer des modèles « avec » et « avec différent » au moyen de contrefactuels fondés sur un scénario. Dans la fonction publique, il est rare que rien ne soit fait lorsqu’un programme n’est pas mis en œuvre tel qu’il a été conçu initialement. En règle générale, on crée un autre programme à la place. L’utilisation d’un contrefactuel signifie qu’il est possible de comparer ces deux situations, à savoir le modèle initial du programme (« avec ») et la solution de rechange (« avec différent »).

Les contrefactuels de l’ERI sont fondés sur un scénario parce qu’ils prennent pour modèle un autre état et ne demandent pas ce qui se serait produit si le programme n’avait pas été mis en œuvre. Selon les objectifs de l’évaluation, il peut être instructif d’inclure un scénario du statu quo ou de ce qui se serait produit en l’absence du programme. Cela pourrait particulièrement intéresser l’évaluateur d’un programme faisant l’objet d’un examen dans un tel cas. D’autres évaluateurs peuvent davantage s’intéresser à la comparaison de plusieurs modèles possibles.

Le contrefactuel permet aussi de comparer des solutions de rechange hypothétiques lors de la conception du programme et avant sa mise en œuvre. Un exemple serait d’avoir la gamme d’options pour éclairer une proposition stratégique. Autrement, grâce à l’ERI, on peut comparer un programme établi depuis longue date au remplacement proposé afin de déterminer les effets possibles du changement.

Pour déterminer le bon contrefactuel, il peut être utile de :

- consulter la liste des options envisagées lors de la conception du programme;

- passer en revue les études et les évaluations du programme;

- analyser la façon dont il diffère des programmes similaires qui ont été proposés ou abordés dans diverses publications;

- se pencher sur ce que font d’autres administrations.

Le contrefactuel peut être quelque chose déjà mis en œuvre ailleurs ou pourrait être quelque chose qui n’a jamais été mis en œuvre. Pour une évaluation menée au cours de la conception du programme (évaluation ex ante), les contrefactuels pourraient être deux ou plusieurs possibilités qui sont envisagées. Les intervenants, les experts en la matière et les conseillers techniques du programme peuvent également avoir de précieux points de vue sur les contrefactuels possibles.

Fait important, le contrefactuel doit être faisable, plausible et légal. Par exemple, le programme d’une autre administration peut avoir les mêmes objectifs. Toutefois, s’il est illégal au Canada ou s’il a dix fois le financement affecté, ce ne serait pas un contrefactuel raisonnable et il ne fournirait pas une comparaison significative.

Il faudrait alors consulter les intervenants du programme pour établir le bon contrefactuel et il reviendra à l’évaluateur de déterminer la faisabilité. Par exemple, si le contrefactuel proposé porte sur un programme réglementaire plutôt que sur une mesure incitative, il peut être une solution de rechange possible, selon le contexte.

Il est important que les intervenants du programme discutent du contrefactuel, en particulier à la deuxième phase de l’ERI, lors de la création du sommaire du programme. Autrement, certains intervenants pourraient éventuellement remettre en question le contrefactuel, et donc la légitimité et les points essentiels de l’évaluation. Sans un examen du contrefactuel par l’ensemble des intérêts, le contrefactuel risque d’être biaisé ou impraticable en raison du manque de ressources ou d’autres contraintes.

4.0 Guide pratique de l’évaluation rapide de l’impact

Il faut habituellement deux à six mois pour mener une ERI, selon la façon dont l’évaluateur conçoit le modèle d’évaluation, exécute la passation de marchés et fait participer les experts.

Le présent guide décrit les quatre phases d’une ERI :

- la planification de l’évaluation;

- la création du sommaire du programme;

- la collecte des jugements d’experts sur les impacts;

- l’analyse des résultats et les rapports connexes.Voir la note en bas de page 2

Pour chaque phase, le présent guide comporte les étapes à suivre ainsi que la motivation pour les étapes et la théorie qui sous-tend chacune des étapes. On invite les évaluateurs à suivre ces étapes ou à s’en inspirer pour élaborer leurs propres processus ou méthodes fondés sur les objectifs de leur évaluation.

4.1 Phase 1 : planification d’une évaluation rapide de l’impact

| Phase | Objet |

|---|---|

| 1 | Planifier l’évaluation, dresser la liste d’experts et obtenir les approbations nécessaires. |

| 2 | Créer le sommaire du programme, remplir le cadre de l’évaluation, et obtenir la participation de conseillers techniques et des principaux intervenants du programme. |

| 3 | Discuter avec les trois groupes d’experts afin de recueillir leur évaluation de l’impact différentiel du programme. |

| 4 | Analyser les données produites au cours de la phase 3, en vérifier la qualité et rédiger des rapports sur les résultats. |

Avant d’entamer l’évaluation, examinez les deux grands facteurs qui peuvent avoir une incidence sur sa durée : la passation de marché et la méthode de participation. La planification doit tenir compte de ces facteurs lors de l’établissement de l’échéancier :

- Passation de marché : Selon le cas, l’évaluateur peut retenir par contrat les services de conseillers techniques, d’experts en la matière ou d’un animateur pour l’atelier d’experts. Il faut donc ajouter le temps requis pour la passation de marché à l’échéancier.

- Méthode de participation : La méthode d’ERI recommande de consulter les experts en la matière lors de la phase 3 dans le cadre d’un atelier animé, en personne ou par conférences en ligne, pour s’assurer qu’ils comprennent suffisamment le programme et les concepts à évaluer. Les projets pilotes ont adopté une approche mixte où les experts en la matière ont été consultés par le biais de sondages. La fiabilité de cette méthode n’a pas été mise à l’essai pour l’ERI, mais pourrait être envisagée, au besoin.

L’ERI peut se faire en deux mois seulement lorsque la passation de marché peut se faire rapidement ou a été faite à l’avance, et lorsque la participation d’experts est simple. Une ERI qui dure six mois peut donner plus de latitude pour conclure les contrats, choisir les experts et déterminer leur mode de participation. Le temps consacré à ces deux facteurs dépend des questions d’évaluation posées et des ressources disponibles.

En gardant à l’esprit la passation de marché et la méthode de participation, l’évaluateur devrait faire ce qui suit au cours de la phase 1 :

- Déterminer les éléments à inclure au mandat, entre autres ce qui suit :

- l’approche utilisée;

- la détermination des sources de données et des méthodes de collecte de données;

- le budget pour la passation de marché;

- les échéanciers;

- les questions d’évaluation (celles-ci seront probablement peaufinées à la phase 2 lors de la création du sommaire du programme).

- Obtenir les approbations nécessaires, entre autres pour ce qui suit :

- le mandat;

- le budget;

- l’approche proposée.

- Prévoir d’autres sources utiles à la création du sommaire initial du programme ou à l’évaluation par exemple, l’examen de la documentation, l’analyse des données existantes ou l’examen de la littérature.

- Identifier les experts qui seront consultés au cours de l’évaluation, comme il est indiqué dans le tableau 1 :

- tous les intérêts des intervenants du programme doivent être représentés;

- les conseillers techniques peuvent être utiles pendant toute l’évaluation, mais, dans certains cas, les évaluateurs pourraient juger qu’il n’est pas nécessaire d’avoir un tel conseiller. Si un conseiller technique sera consulté, il doit être identifié lors de la phase 1;

- une ERI repose sur la volonté de divers groupes d’experts à participer au processus et est conçue de manière à réduire leur fardeau au minimum. Il serait utile d’adapter votre approche en conséquence.

- Effectuer une évaluation des facteurs relatifs à la protection des renseignements personnels, au besoin.

- Si l’évaluation fera appel à des experts dont les services doivent être retenus par contrat, procéder à la passation de marché.

Au tableau 1, vous trouverez des détails sur les groupes d’experts consultés pour une ERI.

| Groupe | Exemple | Attributs | Processus de mobilisation | Extrant principal | Nombre proposé |

|---|---|---|---|---|---|

| Intervenants du programme | Bénéficiaires du programme, principaux décideurs, gestionnaires de programme, personnel du programme et partenaires d’exécution |

|

Discussion ou entrevues au cours de la phase 2 Sondage Web au cours de la phase 3 On pourrait devoir adapter les sondages aux différents intérêts | Analyse des résultats directs, du rapport coût-efficacité, autres questions ou enjeux liés à l’évaluation | Tous les intérêts des intervenants sont représentés |

| >Experts en la matière | Chercheurs, universitaires, dirigeants de l’industrie et personnes connaissant un domaine pertinent (lors du projet pilote, RNCan a utilisé un fournisseur de carburant et un gestionnaire de parc automobile, entre autres) |

|

Phase 3 seulement Atelier animé (en personne ou au moyen de conférence en ligne); les projets pilotes ont eu recours à des entrevues et à des sondages Web | Analyse des résultats directs, des commentaires sur l’amélioration, du programme, ses besoins et sa pertinence | 4 à 6 |

| >Conseillers techniques | Corps professoral émérite d’une université ou un praticien chevronné dans un domaine essentiel du programme |

|

Phases 2, 3 et 4 Le sondage Web devrait être identique ou semblable à celui mené auprès des intervenants du programme | Analyse des résultats directs, des commentaires sur l’amélioration du programme et les besoins du programme | 1 à 2 |

La théorie de la phase 1

Trois groupes principaux sont consultés lors de l’ERI :

- les intervenants du programme;

- les experts en la matière;

- les conseillers techniques.

Comme le parti pris axé sur le programme représente un risque clé auquel fait face une évaluation, le but est d’obtenir un large éventail de points de vue sur les résultats et l’impact du programme. Si l’on n’utilise que des sources internes pour le sommaire du programme ou la collecte des données, on peut omettre certains points de vue. Voilà pourquoi il faut s’intéresser à tous les points de vue sur le programme et faire appel à des experts en la matière pour en évaluer l’impact.

L’ERI fait appel à des experts de l’extérieur pour contrebalancer ce parti pris et affirmer la légitimité ainsi que la crédibilité des évaluations. Cependant, le recours à des experts internes de l’extérieur du ministère ou du programme concerné peut être suffisant en raison des contraintes liées à l’échéancier et à la passation de marché. Il est important de retenir que seuls les conseillers techniques et les intervenants du programme sont consultés à la phase 2 pour la création d’un sommaire du programme rigoureux alors que les trois groupes d’experts participent à l’évaluation de l’impact différentiel au cours de la phase 3.

L’identification de bons experts en la matière est une partie importante du processus. Tout dépend de l’objet évalué pour les identifier et les trouver. En règle générale, vous pouvez amorcer la recherche dans les universités, les autres ministères et les institutions de recherche. Ce sont de bons endroits pour trouver des gens qui connaissent le sujet sans être liés au programme.

Au cours de la phase 1, il est important de déterminer s’il faut retenir les services d’experts. Plus vite on les trouve, plus tôt le processus de passation de marché (au besoin) peut être amorcé et on peut procéder à l’évaluation plus rapidement. La meilleure approche varie d’un ministère à l’autre, mais il est utile d’examiner diverses options, par exemple :

- contrat de faible valeur à fournisseur unique;

- services professionnels et fournisseurs préqualifiés ou autres bassins d’expertise préapprouvés;

- protocoles d’entente;

- contrat d’employé temporaire;

- tout autre mécanisme contractuel applicable.

Un modèle pertinent pourrait être le mode de participation des groupes de discussions au sein de votre ministère.

Les intervenants du programme sont divisés en sous-groupes, appelés intérêts. Les intérêts sont les personnes ou organisations touchées et celles qui ont une incidence sur le programme. Chaque sous-groupe a un intérêt différent à l’égard du programme, et ses priorités et points de vue en découlent. Par exemple, les intervenants du programme peuvent être divisés en trois intérêts différents :

- gestionnaires du programme;

- employés du programme;

- bénéficiaires du programme.

Ces trois intérêts sont consultés en tant que groupe d’experts du programme, mais leurs points de vue sur l’impact sont très différents. Il peut y avoir d’autres intérêts en fonction du programme, entre autres les partenaires de mise en œuvre, la famille des bénéficiaires, les cadres et autres.

Il n’y a pas de méthode exacte pour répartir les intervenants en groupes d’intérêts. La façon dont ils sont répartis dépend du programme évalué et de la taille de l’échantillon. Les évaluateurs peuvent en discuter avec les intervenants et examiner les évaluations pertinentes ou la littérature à ce sujet. On doit consulter un échantillon des groupes d’intérêts lors de l’élaboration du sommaire du programme et tous les groupes d’intérêts doivent être consultés pendant la collecte de données. Procéder ainsi permettra de s’assurer que le sommaire du programme n’est pas axé sur le programme et n’est pas un parti pris occasionné par la consultation des employés du programme seulement.

On a eu de la difficulté à trouver des conseillers techniques pour les projets pilotes, car ce sont généralement des experts dans le contexte plus large du programme ou des spécialistes sur un aspect technique ou scientifique pertinent. Ils ne doivent pas nécessairement connaître le programme. En réalité, les conseillers techniques et les experts en la matière se ressemblent, mais l’on attend des conseillers techniques qu’ils mettent systématiquement leurs connaissances à contribution pour la conception du modèle d’évaluation et lors de l’analyse. Ces conseillers peuvent aider l’évaluateur à élaborer le sommaire du programme au cours de la phase 2, notamment les résultats directs, la théorie du changement et le contrefactuel fondé sur un scénario. Ils jouent ensuite un rôle au sein d’un groupe d’experts pour évaluer l’impact. Comme il arrive souvent que le conseiller technique ne connaisse pas au préalable les particularités du programme évalué, sa participation à l’élaboration du sommaire lui permettra de se familiariser avec le sujet.

L’aptitude d’une personne à être un conseiller technique dépend en partie des besoins de l’évaluation et du programme à évaluer. Par exemple, pour une évaluation d’un projet de gestion des pêches, le conseiller technique pourrait être un écologiste ou un spécialiste des sciences sociales, comme un spécialiste organisationnel. L’Agence de la santé publique du Canada a eu recours à un expert scientifique pour son projet pilote.

Toutes les évaluations n’ont pas nécessairement besoin d’un conseiller technique, notamment celles où l’évaluateur possède déjà une expertise de la science ou de la nature du programme. Cela dit, un conseiller technique peut être un point de triangulation utile qui peut souvent apporter une optique qui, autrement, passerait inaperçue dans le cadre de l’évaluation.

- À la fin de la phase 1, vous avez planifié l’évaluation et identifié les experts qui seront consultés.

4.2 Phase 2 : élaborer le sommaire du programme

| Phase | Objet |

|---|---|

| 1 | Planifier l’évaluation, dresser la liste d’experts et obtenir les approbations nécessaires. |

| 2 | Créer le sommaire du programme, remplir le cadre de l’évaluation, et obtenir la participation de conseillers techniques et des principaux intervenants du programme. Sources de données : un examen de la documentation, de la littérature et des entrevues d’experts et d’intervenants du programme. |

| 3 | Discuter avec les trois groupes d’experts afin de recueillir leur appréciation de l’impact différentiel du programme. |

| 4 | Analyser les données produites au cours de la phase 3, en vérifier la qualité et rédiger des rapports sur les résultats. |

Au cours de la phase 2, les évaluateurs collaborent avec les intervenants du programme et le conseiller technique à l’élaboration d’un résumé de deux à trois pages qui contient les renseignements requis pour la phase 3. Comme la phase 2 est le fondement du reste du travail d’évaluation, elle consomme souvent un pourcentage important des ressources et de l’effort requis pour l’ensemble de l’évaluation, parfois jusqu’à 75 %. Il s’agit d’une phrase cruciale de l’ERI en raison de la consultation à venir des experts au cours de la phase 3. Le sommaire du programme permet d’assurer ce qui suit :

- la participation des intervenants;

- les intervenants, les évaluateurs et les conseillers techniques comprennent de la même façon le programme et les concepts connexes;

- l’évaluation répond aux bonnes questions.

La participation de tous les intérêts représentés entre les intervenants du programme et le conseiller technique permettra d’élaborer un sommaire de grande qualité et très utile. Le processus d’élaboration pourrait nécessiter plusieurs consultations des intervenants. Ce sommaire devrait au moins comprendre ce qui suit :

- Profil du programme : Brève description du programme.

- Théorie du changement : Façon dont les activités et extrants du programme donneront les résultats attendus et la façon dont chaque étape aura une incidence sur l’étape suivante. Les principaux mécanismes de changement devraient être clairement définis.

- Résultats directs et impacts souhaités : Les résultats directs sont les effets qui découlent directement du programme, par exemple, la confiance accrue acquise grâce à une formation professionnelle. Il peut s’agir de résultats immédiats ou de résultats intermédiaires. Le processus permettant de déterminer les résultats directs et les impacts souhaités en collaboration avec les intervenants du programme et les conseillers techniques peut également s’avérer utile pour cerner les résultats inattendus (par exemple, les résultats qui ne figurent pas au modèle logique).

- Organigramme des intervenants du programme : Liste des intervenants du programme et des intérêts représentés par chacun. Des renseignements permettant de les identifier aux fins de l’évaluation devraient aussi figurer à l’organigramme.

- Heure(s) et lieu(s) du programme et de chaque effet : La détermination de l’heure et du lieu peut être particulièrement importante si le programme compte plusieurs emplacements, et que la mise en œuvre, les résultats et les intervenants varient d’un emplacement ou d’une heure à l’autre.

- Contrefactuels fondés sur un scénario : Solutions de rechange qui ont été mises en œuvre et qui servent de comparaison aux fins de l’analyse de l’impact différentiel.

La phase 2 est un bon moment pour inciter le conseiller technique à appuyer l’élaboration du contrefactuel fondé sur un scénario, la théorie du changement et le reste du sommaire.

Voici les étapes clés pour l’élaboration du sommaire du programme (menées en consultation avec le conseiller technique, au besoin) :

- Rassembler les éléments de preuve nécessaires de la documentation sur le programme et de sources secondaires pour informer le sommaire. Par exemple :

- le mémoire au cabinet original ou les présentations au Conseil du Trésor;

- profils de l’information sur le rendement;

- évaluations;

- données existantes;

- littérature pertinente.

- À partir des éléments de preuve assemblés, élaborer des sommaires provisoires (d’une à deux pages) sur les activités du programme, y compris les extrants, les résultats, le but et les intervenants.

- Déterminer ou concevoir la théorie du changement.

- Rédiger des énoncés d’impact (s’il n’y en a pas).

- Élaborer les contrefactuels fondés sur un scénario. Il s’agit de l’une des étapes les plus importantes de l’évaluation et elle devrait être menée avec soin. Consulter les renseignements à la section 3 pour obtenir plus de détails.

- Élaborer des guides d’entrevue et des sondages pour l’étape 7.

- Mener des entrevues auprès d’une partie ou de la totalité des intervenants en vue d’obtenir leur rétroaction sur les documents du sommaire et les contrefactuels, de concert avec le conseiller technique. Les entrevues se font en personne ou par téléphone. Il est important de retenir ce qui suit :

- Une attention particulière devrait être accordée à la confirmation des contrefactuels fondés sur un scénario et d’en vérifier la plausibilité, la faisabilité et la légalité.

- Il peut être pratique pendant cette phase d’obtenir la participation de seulement quelques intervenants du programme plutôt que de la totalité des intervenants. On pourrait ainsi limiter à la phase 3 les difficultés temporelles à retenir les services d’experts. Dans la mesure du possible, toutefois, tous les intérêts devraient être représentés.

- Prendre en compte la rétroaction des trois groupes d’experts et les consulter de nouveau, s’il y a lieu, pour établir un consensus sur les éléments du sommaire.

Un exemple du sommaire du programme pour l’évaluation de RNCan (annexe B) est disponible.

La théorie de la phase 2

Le sommaire du programme est très différent du profil de programme normalisé aux fins des évaluations, étant donné qu’il s’intéresse davantage à la façon dont le programme est concrètement exécuté. C’est à la fois un produit et un processus.

Comme produit, le sommaire du programme comprend les éléments de base de l’évaluation, qui sont les suivants :

- les fondements servant à définir les impacts;

- les intérêts concernés par l’intervention;

- la théorie du changement;

- les contrefactuels.

Le sommaire du programme est un élément clé de la conception du modèle d’évaluation qui contribue à la « rapidité » de l’exécution de l’ERI.

Comme processus, l’élaboration du sommaire s’avère utile pour inciter les intérêts à participer à l’évaluation. Cette participation contribue ainsi à affirmer sa légitimité, favorise des réponses de haute qualité lors des sondages et augmente la probabilité de son utilisation une fois achevée. Le sommaire permet aussi de peaufiner les questions d’évaluation et les impacts pour qu’ils soient pertinents aux yeux des intérêts et éclairent les mécanismes de causalité du programme. Le sommaire confirme ou détermine également les indicateurs à mesurer pour répondre aux questions.

À la phase 2, l’évaluateur consulte deux des trois groupes d’experts participant à l’ERI :

- les intervenants;

- les experts techniques.

Cette consultation permettra de vérifier que l’évaluation et les questions connexes sont fondées sur une compréhension exhaustive du programme. Les points de vue des experts en la matière sont moins importants, car ils connaissent moins bien le programme. Les conseillers techniques sont consultés dans le but d’offrir du contexte et des renseignements généraux sur les connaissances scientifiques ou spécialisées pertinentes aux fins de l’évaluation.

Selon la décision prise à la phase 1, la participation d’experts peut se faire par des entrevues individuelles ou en groupe (en personne ou par téléphone), ou par l’envoi de documents demandant leur rétroaction. Il n’est pas nécessaire que l’entrevue soit longue, mais elle devrait avoir pour objectif de confirmer que le sommaire est une représentation raisonnable du programme ou de ce qui doit être modifié. Les intervenants peuvent aussi contribuer à l’élaboration du contrefactuel ou apporter des suggestions. Si des changements sont proposés, y compris les résultats inattendus, ils devraient être ajoutés au sommaire révisé qui sera distribué à nouveau et fera l’objet de discussions.

Certains intervenants et conseillers techniques peuvent être consultés à deux reprises :

- au cours de la phase 2 lors de l’élaboration du sommaire du programme;

- à la phase 3 lors de l’évaluation de l’impact du programme.

Les projets pilotes ont démontré que les intervenants étaient généralement ouverts à l’idée d’être consultés deux fois, mais qu’il serait utile de les informer à la phase 2 qu’une autre consultation est prévue et d’en préciser l’objet.

Une attention particulière devrait être accordée à la confirmation des contrefactuels fondés sur un scénario et d’en vérifier la plausibilité, la faisabilité et la légalité. Le contrefactuel n’est peut-être pas l’option préférée des principaux intervenants, mais tous devraient le trouver acceptable.

Les évaluateurs doivent trouver un juste milieu entre la nécessité de consulter et la nécessité d’entreprendre l’évaluation. Ils devraient s’efforcer d’obtenir un consensus sur ce qui est élaboré, notamment sur le contrefactuel. Dans certains cas, il peut être nécessaire de reconnaître les désaccords, d’en faire état dans le rapport, s’il y a lieu, et de poursuivre l’évaluation.

Une caractéristique importante du sommaire est l’accent mis sur les impacts et les résultats. En bref, les résultats directs sont les changements découlant directement du programme. Par exemple, un programme de formation axée sur les compétences peut être utile pour accroître la confiance en soi ou aider quelqu’un à trouver un emploi. L’impact est un effet à plus long terme et de plus haut niveau, et l’impact différentiel est la différence entre ce qui s’est produit avec l’intervention et ce qui se serait produit avec le contrefactuel.

Le but de l’élaboration du sommaire du programme est de s’assurer que tous les résultats possibles sont traités, y compris ceux qui ne figurent pas au modèle logique ou dans une présentation au Conseil du Trésor. Les experts peuvent trouver des résultats inattendus, qui ne figurent pas au modèle logique, qui pourraient ensuite être utiles pour éclairer une phase ultérieure de l’évaluation. Une telle découverte de résultats inattendus dans le cadre de l’ERI peut s’avérer importante.

L’approche adoptée dans l’un des projets pilotes était d’inclure la liste des résultats immédiats et intermédiaires au modèle logique et de demander aux intervenants si :

- ils prévoyaient que le programme atteignent ces résultats;

- il y avait d’autres résultats qu’ils avaient observé ou s’attendaient à observer qui n’y figuraient pas.

Dresser une telle liste et poser ces questions peut faciliter la tâche aux experts consultés qui souhaitent faire des commentaires. Les évaluateurs peuvent ensuite discuter des résultats qui n’ont pas été atteints aux yeux des intervenants, puis dresser une liste de résultats inattendus qui feront l’objet d’une étude plus approfondie au cours de l’évaluation.

Finalement, si le programme ne présente pas déjà une théorie du changement, on l’élabore en même temps que le sommaire du programme. Comme toute autre théorie du changement, elle devrait expliquer la façon dont les activités et les extrants du programme permettront l’atteinte des résultats attendus et dont chaque niveau de résultat aura une incidence sur le niveau subséquent. Ces théories peuvent être utiles pour toutes les évaluations en cernant la logique d’un programme et la façon dont ses activités entraînent ses résultats.

Une théorie du changement est particulièrement importante dans le cadre de l’ERI, car on demandera aux experts de déterminer la probabilité et l’ampleur de l’impact du programme, et leurs connaissances et leur compréhension de la logique du programme joueront un rôle clé. Lors de l’élaboration du sommaire, l’établissement d’un consensus sur la logique du programme et les principaux mécanismes de changement permettra d’éviter les problèmes occasionnés lorsque divers experts préconisent des mécanismes de changement différents.

Un exemple de la théorie du changement élaborée pour RNCan (annexe A) est disponible en ligne.

Si l’ERI est menée comme source de données dans le cadre d’une évaluation plus large, la phase 2 peut être le bon moment de préparer les autres parties de l’évaluation. Par exemple, si l’évaluation se penchera aussi sur d’autres méthodes d’exécution, l’amélioration du processus ou la mise en œuvre, il peut être utile de profiter de l’occasion et d’en discuter avec des experts.

- À la fin de la phase 2, vous avez achevé le sommaire du programme, y compris le contrefactuel, et les principaux intervenants s’entendent sur sa pertinence.

4.3 Phase 3 : collecte de jugements sur l’impact différentiel du programme

| Phase | Objet |

|---|---|

| 1 | Planifier l’évaluation, dresser la liste d’experts et obtenir les approbations nécessaires. |

| 2 | Créer le sommaire du programme, remplir le cadre de l’évaluation, et obtenir la participation de conseillers techniques et des principaux intervenants du programme. |

| 3 | Discuter avec les trois groupes d’experts afin de recueillir leur appréciation de l’impact différentiel du programme. Sources de données : sondages, atelier animé, entrevues |

| 4 | Analyser les données produites au cours de la phase 3, en vérifier la qualité et rédiger des rapports sur les résultats. |

Après avoir identifié vos trois groupes d’experts à la phase 1 (intervenants du programme, experts en la matière et conseillers techniques), chaque groupe doit maintenant être consulté pour connaître son évaluation de l’impact différentiel.

Voici les principales étapes de la consultation des groupes d’experts :

- Déterminer les renseignements requis de chaque groupe d’experts :

- On demande aux trois groupes d’experts d’estimer les effets du programme et du contrefactuel. Pour ce faire, on leur demande de juger deux choses : la probabilité que l’intervention ait le résultat souhaité et l’ampleur des effets obtenus, lesquels ont effectivement une incidence sur le résultat. On utilise habituellement une échelle de 0 à 4.

- Il faudrait interroger les experts sur la probabilité et l’ampleur de chacun des résultats directs figurant au sommaire du programme.

- Vous pouvez aussi inclure d’autres questions pertinentes, entre autres sur le rapport coût-efficacité du programme ou les façons de l’améliorer pour mieux atteindre ses objectifs et les objectifs stratégiques. Dans l’optique de la théorie du changement, il peut être utile de demander aux experts de déterminer l’importance des activités et des extrants liés aux résultats immédiats.

- Selon le temps disponible et la décision prise à la phase 1 sur la façon d’obtenir la participation d’experts et de préparer les documents pertinents :

- Il peut être utile d’adapter les sondages en fonction des différents groupes d’experts et des différents intérêts représentés dans le groupe d’intervenants du programme. Cela est particulièrement vrai pour les répondants externes au ministère, qui pourraient moins bien connaître le processus d’évaluation et les objectifs et, par conséquent, qui ont besoin de plus de renseignements généraux et contextuels comparativement aux intervenants internes.

- Recueillir les évaluations de la probabilité et de l’ampleur auprès de tous les experts dans les trois groupes d’experts :

- Par exemple, un expert peut estimer qu’il est hautement probable qu’un programme ait un effet sur un résultat (peut-être 3 sur 4) mais qu’il est probable que cet effet soit très petit (1 sur 4). Avec ces deux chiffres, l’évaluateur peut calculer l’évaluation des résultats du programme par l’expert, comme présenté de façon détaillée à la phase 4.

Exemple du programme écoÉNERGIE pour les carburants de remplacement de RNCan

L’exemple ci-dessous a été utilisé par l’un des projets pilotes de Ressources naturelles Canada (RNCan) pour estimer la probabilité et l’ampleur de chaque résultat direct déterminé au cours de la phase 1. Après avoir répondu aux questions concernant le programme, on a expliqué le contrefactuel aux répondants et on leur a demandé de répondre aux mêmes questions.

Veuillez indiquer dans quelle mesure vous croyez que le programme écoÉNERGIE pour les carburants de remplacement de RNCan a donné ou donnera les résultats suivants pour ce qui suit :

- La probabilité que le résultat est atteint ou le sera en utilisant une échelle de 0 à 4, où 0 signifie qu’il n’a pas été ou ne sera pas atteint et 4 qu’il a été atteint ou qu’il le seraVoir la note en bas de page 3.

- Quelle est ou sera la taille du résultat, à l’aide d’une échelle de 0 à 4, où 0 signifie « grande ».

Le but de la présente question est d’estimer dans quelle mesure le programme a mené ou mènera aux résultats (c’est-à-dire, les résultats sont attribuables au programme) et l’ampleur (actuelle ou éventuelle) des résultats. Il est essentiel d’indiquer une cote dans les deux colonnes.

| Probabilité | Ampleur | |

| Résultat | Quelle est la probabilité que le résultat est atteint ou le sera? | Quelle est ou quelle sera l’importance du résultat s’il est atteint? |

| L’amélioration des connaissances dans le milieu de la normalisation lui permet d’harmoniser et de mettre à jour les codes et les normes. | ||

| Les codes et les normes sur les carburants de remplacement, en particulier le gaz naturel dans les véhicules de poids moyens et les véhicules lourds (y compris l’infrastructure de ravitaillement), sont mieux harmonisés. | ||

| Efficacité accrue dans le déploiement des véhicules au gaz naturel. | ||

| Les décideurs connaissent mieux les débouchés des carburants de remplacement, en particulier le gaz naturel. | ||

| Les producteurs ou des distributeurs de carburants connaissent mieux les débouchés des carburants de remplacement, en particulier le gaz naturel. | ||

| Les utilisateurs de carburants connaissent mieux les débouchés des carburants de remplacement, en particulier le gaz naturel. | ||

| Les investisseurs connaissent mieux les débouchés des carburants de remplacement, en particulier le gaz naturel. | ||

| Sensibilisation accrue des utilisateurs finaux aux avantages présentés par les options de carburants de remplacement, en particulier le gaz naturel. | ||

| Sensibilisation accrue des producteurs de carburants aux avantages des options de carburants de remplacement, en particulier le gaz naturel. | ||

| Sensibilisation accrue des fabricants de véhicules et d’équipement aux avantages des options de carburants de remplacement, en particulier le gaz naturel. | ||

| Les consommateurs d’énergie adoptent des technologies écoénergétiques (par exemple, liées au gaz naturel). | ||

| Les consommateurs d’énergie adoptent des pratiques énergétiques de remplacement, en particulier le gaz naturel. |

La théorie de la phase 3

C’est à la phase 3 de l’ERI que commence la participation des experts en la matière externes. Le recours aux experts externes pour l’évaluation de l’impact contrebalance les partis pris de l’équipe du programme et aide à affirmer la légitimité ainsi que la crédibilité de l’évaluation. Dans certains cas, le recours à des experts internes peut suffire, mais ils devraient à tout le moins provenir de l’extérieur du ministère où le programme est exécuté. Pour certaines évaluations, notamment dans le cadre de l’un des projets pilotes, le point de vue externe était très différent de celui des autres groupes de répondants. Cela peut donner à penser à un autre volet d’enquête ou à un domaine de recherche intéressant aux fins de l’évaluation.

Les intervenants du programme et les conseillers techniques peuvent être mobilisés au moyen d’un sondage Web ou d’entrevues afin d’obtenir leur évaluation de l’impact. Parfois, il faut faire preuve de souplesse selon la personne consultée. Par exemple, lors de la consultation des intervenants, certains cadres peuvent être moins enclins à répondre à un sondage et il serait alors préférable de recourir à l’entrevue en raison de contraintes de temps.

Pour l’ERI, on recommande de mobiliser les experts dans le cadre d’un atelier animé, au moyen d’outils comme la conférence en ligne ou en personne. L’atelier est idéal, car on peut s’assurer que les experts externes comprennent le programme et le contrefactuel, ce qui affirmera la légitimité de l’évaluation. Les ateliers permettent l’interaction entre les experts en la matière et mettent en évidence les sujets de préoccupation ou de confusion. Cependant, il peut aussi arriver que des experts influencent la décision des autres au cours d’un atelier. L’un des rôles de l’animateur consiste donc à s’assurer que cela ne se produise pas et que chaque expert présente sa propre évaluation de la probabilité et de l’ampleur de chaque impact, de façon éclairée et non influencée par les discussions avec les autres.

Pour les trois projets pilotes du gouvernement fédéral, on a choisi le sondage au lieu de l’atelier pour assurer la participation des experts en la matière en raison de contraintes temporelles et logistiques. Cette approche n’a pas été mise à l’essai de la même façon que les ateliers (en ligne et en personne) et peut donc ajouter d’autres variables à l’évaluation. À l’avenir, il faudrait utiliser ce qui convient le mieux à l’évaluation dans le contexte de la fonction publique fédérale. Pour que les consultations soient comparables, toutefois, la même question devrait être posée à tous les experts, même si la méthode varie.

Il peut également être utile de demander aux experts d’estimer l’importance de chaque résultat par rapport à l’effet général du programme. Comprendre la façon dont les experts perçoivent l’importance relative des différents résultats dans l’interprétation et la compréhension des constatations de l’évaluation peut également être utile. Si les évaluateurs choisissent de faire appel à des experts, la demande devrait être formulée à la phase 3 pour éviter de les consulter de nouveau au cours de la phase 4. Par exemple, on pourrait demander aux experts à quel point chaque résultat immédiat est important par rapport aux résultats intermédiaires, et à quel point chaque résultat intermédiaire est important par rapport aux résultats ultimes. Si l’évaluation prévoit évaluer l’impact général, comme il en a été question au cours de la phase 4, ces évaluations peuvent permettre d’éclairer ce processus.

À la fin de la phase 3, vous devriez avoir ce qui suit :

- des jugements d’expert sur la probabilité et l’ampleur des effets, tant sur les résultats directs du programme que ceux du contrefactuel fondé sur un scénario;

- une estimation des autres questions liées à l’évaluation (par exemple, la pertinence, l’efficacité, et l’efficience) et, tel que souhaité, des suggestions sur les points à améliorer.

4.4 Phase 4 : analyse et présentation des résultats

| Phase | Objet |

|---|---|

| 1 | Planifier l’évaluation, dresser la liste d’experts et obtenir les approbations nécessaires. |

| 2 | Créer le sommaire du programme, remplir le cadre de l’évaluation, et obtenir la participation de conseillers techniques et des principaux intervenants du programme. |

| 3 | Discuter avec les trois groupes d’experts afin de recueillir leur appréciation de l’impact différentiel du programme. |

| 4 | Analyser les données produites au cours de la phase 3, en vérifier la qualité et rédiger des rapports sur les résultats. |

Analyse

L’analyse de l’ERI peut être menée au moyen d’une feuille de calcul et ne nécessite pas d’outils statistiques avancés. Même s’il y a un certain nombre d’étapes à suivre, l’analyse ne se veut pas compliquée. En règle générale, les trois objectifs de l’ERI sont les suivants :

- Calculer l’évaluation moyenne de la probabilité et de l’ampleur pour chaque groupe d’experts, ainsi que pour les sous-groupes représentant les intérêts de chaque intervenant du programmeVoir la note en bas de page 4.

- Calculer l’impact différentiel attribuable au programme évalué par chaque groupe d’experts (la différence entre les résultats dans le cadre du programme et du contrefactuel).

- Calculer l’impact général du programme.

Calculer l’évaluation moyenne de la probabilité et de l’ampleur pour chaque groupe d’experts

- Réunissez les données des sondages, des ateliers animés, des entrevues et de toute autre méthode de collecte de données quantitatives dans une feuille de calcul et classez les réponses selon le groupe d’experts ou le sous-groupe d’intervenants qu’ils représentent. Vous devriez obtenir, entre autres, un jugement d’expert sur la probabilité d’un résultat donné et l’ampleur de l’effet, le cas échéant.

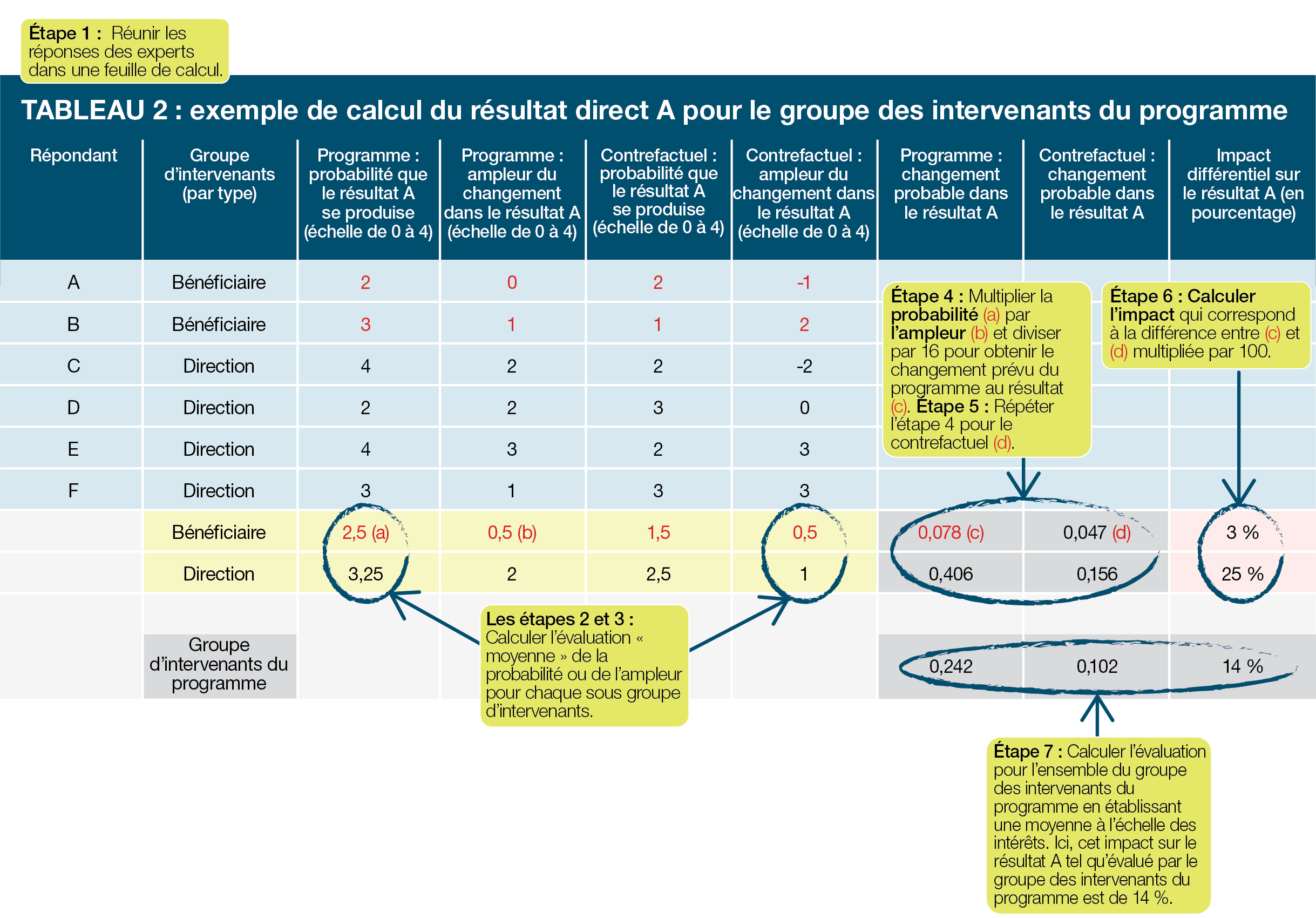

- Pour chaque groupe d’experts et de conseillers techniques, et chaque résultat, trouvez l’estimation moyenne de la probabilité et de l’ampleur (tableau 2).

- Pour les intervenants du programme, calculez les réponses moyennes par sous-groupe et intérêt. Ce calcul permet de s’assurer que l’évaluation des résultats d’un sous-groupe ne l’emporte pas sur d’autres sous-groupes en raison de la taille de l’échantillon (tableau 2)Voir la note en bas de page 5.

Vous disposez maintenant de la probabilité et de l’ampleur moyennes pour chaque résultat :

- des experts en la matière;

- des conseillers techniques;

- de chaque sous-groupe d’intervenants.

Impact attribuable au programme (tableau 2)

- Pour chaque groupe ou sous-groupe, calculez le changement prévu dans chaque résultat direct dans le cadre du programme. Le changement prévu aura toujours une valeur située entre 0 et 1.

- Pour calculer le changement prévu dans un résultat direct, multipliez la probabilité évaluée du résultat par son ampleur évaluée. Le résultat de ce calcul peut ensuite être normalisé entre 0 et 1 et en le divisant par la cote maximale autorisée par les échelles. Sur une échelle de 0 à 4, la cote maximale est 16; sur une échelle de 10 points, la cote maximale est 100.

- Par conséquent, si pour le résultat A les experts en la matière ont estimé que la probabilité que le résultat A se produise se situe à 3 sur 4 et que son ampleur, s’il se produisait, à 2 sur 4, le changement prévu au résultat A serait (3 × 2)/16=0,375.

- Répétez les calculs à l’étape 4 pour obtenir le changement prévu pour chaque résultat du contrefactuel fondé sur un scénario ou de chaque contrefactuel si vous en avez plusieurs.

- Calculer l’impact différentiel ou le changement marginal dans chaque résultat en soustrayant le changement prévu dans le résultat en vertu du contrefactuel découlant du changement prévu dans le résultat en vertu du programme. Le résultat est un pourcentage estimé dans le résultat qui est attribué au programme, comme évalué par le groupe d’experts : l’impact différentiel du programme relativement à ce résultat.

- Par exemple, si le changement prévu dans le résultat A du programme était de 0,375 et le changement prévu dans le résultat A du contrefactuel était de 0,2, l’impact différentiel du programme sur le résultat A s’élève à 17,5 % (0,375-0,2).

- Dans le tableau 2, l’impact différentiel évalué du programme sur le résultat est de 3 % et de 25 % pour le groupe des bénéficiaires du programme et le groupe de direction du programme, respectivement.

- Il est également utile de calculer l’impact différentiel de chaque résultat évalué par chaque répondant individuel, notamment les experts en la matière individuels en :

- multipliant leur probabilité et leur ampleur évaluées;

- divisant le résultat par la cote maximale autorisée;

- prenant la différence entre le programme et le contrefactuel, tel qu’il est indiqué ci-dessus.

Vous pouvez ensuite comparer les évaluations des experts individuels les unes aux autres ainsi que les évaluations d’autres groupes, ce qui rend plus facile de déceler les tendances et les données aberrantes à l’intérieur des données.

- Finalement, pour obtenir une évaluation du groupe d’intervenants du programme dans son ensemble, calculez l’impact différentiel de chaque résultat pour l’ensemble des sous-groupes.

À la conclusion de ces calculs, vous aurez des évaluations de l’impact différentiel du programme pour chaque résultat direct de chacun des trois groupes d’experts ou, en d’autres termes, une échelle des impacts probables du programme.

Le tableau 2 est un exemple du calcul de deux sous-groupes d’intervenants (les bénéficiaires du programme et la direction du programme) de l’évaluation de l’impact différentiel dans le résultat A. Un calcul similaire serait également effectué pour tous les autres résultats et groupes d’experts. L’utilisation de réponses moyennes permet la pondération égale du sous-groupe des gestionnaires de programme et du sous-groupe des bénéficiaires, même si un plus grand nombre de gestionnaires du programme ont été consultés. Il n’est pas nécessaire de diviser les experts en la matière et les conseillers techniques en sous-groupe, mais ils font l’objet d’un calcul similaire.

Tableau 2 - Version texte

Le tableau 2 donne un exemple de calcul du résultat direct A pour le groupe d’intervenants du programme. On y trouve l’information associée aux répondants A à F, y compris leur groupe d’intervenants, ainsi que leur estimation de la probabilité et de l’ampleur d’un changement dans le résultat A, tant pour le programme que pour le contrefactuel.

Le tableau indique ensuite au groupe d’intervenants les sept étapes du calcul à faire pour évaluer l’impact différentiel. L’information est d’abord insérée dans la feuille de calcul, puis au cours de la deuxième et de la troisième étape, l’évaluation moyenne de la probabilité et de l’ampleur est calculée pour chaque sous-groupe d’intervenants. La quatrième étape consiste à multiplier la probabilité par l’ampleur, puis à diviser par 16 pour obtenir le changement escompté dans le résultat C du programme. Au cours de la cinquième étape, ce calcul est répété pour le contrefactuel. On établit l’impact lors de la sixième étape en calculant la différence entre le changement escompté au résultat du programme et au résultat du contrefactuel. Au cours de la dernière étape, on détermine l’évaluation moyenne de l’ensemble du groupe d’intervenants en calculant la moyenne des intérêts divergents. Dans le cas présent, l’impact différentiel est évalué à 14 %.

- Facultatif : calculer l’impact général

- Au cours de la phase 3, chaque résultat est pondéré en fonction de sa contribution estimative aux impacts différentiels du programme en s’inspirant de la littérature ou d’autres sources ainsi que des discussions avec le conseiller technique et les experts en la matière. Les pondérations attribuées à chaque résultat devraient totaliser 1,0 % ou 100 %. Dans le cas le plus simple, les pondérations peuvent être égales à l’échelle des résultats.

- Pour les experts en la matière, calculez la contribution de chaque impact différentiel à l’impact général en multipliant l’impact pour chaque résultat par la pondération attribuée.

- Calculez l’impact général estimé en établissant la somme de la contribution des impacts différentiels générés à l’étape b).

- Répétez les étapes b) et c) pour les deux autres groupes d’experts.

Le calcul à l’étape 8 donne, pour chaque groupe d’experts, une estimation de leur évaluation de la contribution du programme à l’impact général en termes de pourcentage. Par exemple, imaginez une version simplifiée du projet pilote de RNCan, avec seulement trois résultats :

- l’amélioration des connaissances au sein du milieu de la normalisation;

- une meilleure harmonisation des codes et des normes pour les carburants de remplacement;

- l’efficacité accrue dans le déploiement de véhicules au gaz naturel.

L’ERI constate que les experts en la matière évaluent l’impact différentiel du programme sur chaque résultat à 10 %, à 15 % et à 20 %, respectivement. Cependant, l’évaluateur pourrait arriver à la conclusion, après avoir examiné la littérature et parlé aux experts, que les deux premiers résultats avaient une importance égale pour la contribution à l’impact général, mais que le troisième résultat n’était qu’à moitié aussi important que les deux premiers. Cette pondération serait alors de 40 %, de 40 % et de 20 %, et l’impact général tel qu’il est estimé par les experts en la matière serait de 0,4 × 0,1+0,4 × 0,15+0,2 × 0,2=0,14 (ou 14 %). (Pour consulter l’exemple complet de RNCan, voir l’annexe C du Rapport d’évaluation : Programme écoÉNERGIE pour les carburants de remplacement de RNCan.)

Choisir une pondération

Il n’y a aucune pondération exacte pour le calcul de l’impact général. La détermination des pondérations devrait s’inspirer de la littérature scientifique et il pourrait également être utile de travailler avec les trois groupes d’experts dans le but de déterminer des pondérations appropriées des résultats. Toutefois, peu importe la façon dont la pondération est calculée, il est important que l’évaluation soit transparente à leur égard et qu’elle communique clairement sa justification.

Le tableau 3 présente l’impact général pour un seul groupe d’experts pour un programme comprenant quatre résultats (résultats A à D). On accorde une pondération de 0,2 au résultat A, dont l’impact différentiel est estimé à 0,14, comparativement au résultat B, auquel on attribue une pondération de 0,4. Cela signifie que l’on évalue que le résultat B est deux fois plus important que le résultat A en ce qui a trait à sa contribution à l’impact général du programme. L’impact général est de 0,1625 (ou 16 %).

- Facultatif : vérifier l‘analyse

- Une étape utile dans toute évaluation consiste à vérifier la validité et la fiabilité des renseignements obtenus. On peut le faire de façon statistique ainsi qu’en comparant les constatations de l’ERI aux autres évaluations à l’égard du même programme ou de programmes similaires.

- Rapport

- Vous pouvez maintenant énoncer les constatations de l’évaluation pour chacun des résultats directs et impacts constatés. Par exemple, les experts peuvent juger que les connaissances du milieu de la normalisation se sont améliorées de 30 % de plus, grâce au programme, que la méthode d’exécution utilisée pour la solution de rechange.

| Tableau 3 : Impact général pour un seul groupe d’experts | |||

| Impact général pour chaque résultat, tel qu’estimé par un groupe d’experts | Pondération du résultat | Contribution à l’impact général | |

| Résultat A | 0,14 | 0,2 | 0,028 (0,14 × 0,2) |

| Résultat B | 0,23 | 0,4 | 0,092 (0,23 × 0,4) |

| Résultat C | 0,09 | 0,3 | 0,027 (0,09 × 0,3) |

| Résultat D | 0,155 | 0,1 | 0,0155 (0,155 × 0,1) |

| Impact | 1,0 | 0,1625 (0,028+0,092+0,027+0,0155) L’impact général est de 16 % |

|

La théorie de la phase 4

Facultatif : impact général

Une étape facultative de l’analyse consiste à calculer l’impact général du programme. La méthode la plus simple serait de prendre l’impact moyen de tous les résultats. Cependant, il pourrait y avoir une justification pour la pondération différente des impacts, si on s’attend à ce que certains contribuent plus à l’impact général que d’autres.

Selon la question à laquelle l’évaluation tente de répondre, cette étape pourrait ne pas être nécessaire. Si les résultats sont diversifiés ou si l’évaluation s’intéresse aux impacts différentiels sur des résultats précis, et non pas en général, alors l’impact différentiel sur chaque résultat peut être la question d’intérêt. Cela évite également la nécessité de choisir une pondération pour chaque résultat, ce qui peut être difficile.

Vérification

Une étape utile lors des évaluations consiste à vérifier la validité et la fiabilité des renseignements obtenus. Puisqu’on consulte trois groupes d’experts dans le cadre de l’ERI, il est particulièrement utile de vérifier si les trois groupes sont uniformes (coefficient d’objectivité). Le coefficient alpha de Cronbach est un test normalisé aux fins de la fiabilité interne et peut être calculé dans des trousses statistiques comme SPSS, Stata ou R. Cependant, il n’est pas toujours simple de le faire dans la trousse Excel de base.

L’évaluateur pourrait également vérifier si les estimations de l’ERI sont conformes à celles d’autres évaluations menées à l’égard du programme ou d’études portant sur des programmes similaires. Cette comparaison pourrait être faite de façon statistique ou par l’intermédiaire d’un examen de la littérature ou d’une recherche de base. À titre d’exemple, le fait de constater que toutes les évaluations précédentes de l’impact d’un programme avaient relevé une chose et que l’ERI en a relevé une autre laisserait entendre qu’une recherche plus approfondie était requise pour déterminer la raison expliquant la différence. Les évaluateurs peuvent commencer en vérifiant si les trois groupes d’experts différaient en ceci qu’ils étaient en désaccord avec les constatations antérieures et si les différences s’expliquaient par la méthode, le moment ou d’autres facteurs. Les ERI antérieures ont habituellement conclu que les experts provenant de l’intérieur du programme sont plus optimistes que ceux à l’externe, ce qui pourrait expliquer les différences si les évaluations antérieures étaient fondées en plus grande partie sur des renseignements provenant de l’intérieur du programme.

Établissement de rapports

L’une des forces de l’ERI est d’établir un sommaire clair et concis de ce que les experts jugent être l’impact du programme et celui d’une ou plusieurs solutions de rechange. Les cadres et la direction du programme sont ensuite en mesure de réfléchir aux résultats dans le contexte de solutions de rechange et de discuter des possibilités d’apporter une amélioration directe au programme. Cela s’avère particulièrement important au moment de déterminer l’efficacité du programme, mais peut également être informatif au moment de discuter de l’efficience du programme relativement à des solutions de rechange possibles.

Afin de communiquer l’information aux lecteurs des rapports d’évaluation, il faut expliquer clairement les renseignements fournis par l’ERI. Bref, le processus susmentionné permet d’établir des rapports sur plusieurs éléments clés :

- un sommaire comprenant les résultats prévus et inattendus, qui reçoit l’aval des experts externes et des intervenants et qui reflète raisonnablement le programme;

- une mesure de l’effet du programme et des contrefactuels à l’égard de chaque résultat, tel qu’il est évalué par les groupes d’experts;

- l’impact du programme par rapport à des solutions de rechange faisables et plausibles, c’est-à-dire, ce qui s’est produit grâce au programme et qui ne se serait pas produit avec la solution de rechange;

- facultatif : une mesure de l’impact général du programme.

Les constatations sont habituellement mieux énoncées sous forme de pourcentage. Par exemple, les experts en la matière peuvent juger que les connaissances du milieu de la normalisation se sont améliorées de 30 % de plus, grâce au programme, que la méthode d’exécution utilisée pour la solution de rechange. Les intervenants du programme peuvent évaluer que l’impact se chiffre uniquement à 20 %, alors que les conseillers techniques l’évaluent à 25 %. Par conséquent, les experts ont jugé que le programme avait contribué, en règle générale, à une amélioration des connaissances du milieu de la normalisation de 20 % à 30 % plus que la solution de rechange.

Si l’impact général a été calculé, la meilleure façon de l’énoncer, aux fins de transparence, est au moyen d’une échelle. Si les trois groupes d’experts ont évalué l’impact général à 11 %, 14 % et 16 %, l’évaluateur peut déclarer que l’on s’attendait à que le programme produise une amélioration générale des résultats de l’ordre de 11 % et 16 % de plus que les solutions de rechange envisagées. Même s’il est possible de calculer une moyenne unique pour les trois groupes, cela peut être trompeur si les trois groupes ont présenté une vaste gamme d’évaluations. On privilégie donc le recours à une échelle.

Dans certains cas, les estimations de chaque groupe d’experts peuvent systématiquement diverger, ce qui donne à penser qu’il y a des domaines d’intérêt à analyser ou à discuter. Par exemple, les experts en la matière pourraient être beaucoup moins optimistes que les intervenants internes concernant l’impact du programme. Un tel point de vue pourrait être omis lors d’une évaluation où l’on n’a pas cherché à recueillir des points de vue de l’extérieur et qui peut mettre en évidence des questions importantes. Les intervenants internes pourraient omettre certaines conséquences négatives inattendues, par exemple, ou ne pas être informés d’un programme similaire ailleurs qui a eu un mauvais rendement. De même, les intervenants internes pourraient avoir accès à des renseignements supplémentaires appuyant leur optimisme, mais qui n’ont pas été bien communiqués ou n’ont pas fait l’objet de recherches suffisantes. De telles constatations peuvent intéresser la direction et faire ressortir des points à étudier ou à évaluer de façon plus approfondie.

5.0 Avantages et difficultés de l’évaluation rapide de l’impact

Hors la courbe d’apprentissage, l’ERI comporte, comme toute méthode d’évaluation, des points forts et des contraintes.

Avantages

- Impact au moyen d’un contrefactuel : L’ERI donne une évaluation claire des impacts, qui peut être utilisée pour renforcer et étudier d’autres secteurs évalués, en plus d’éclairer les rapports et les analyses. Il était intéressant, dans le cadre des projets pilotes, d’observer la quantification des différents points de vue du groupe d’experts, qui a permis à l’évaluation de se pencher sur les raisons pour lesquelles il peut y avoir eu des différences lorsque celles-ci ont été observées.

- Contrôle aux fins des partis pris : En incluant tous les domaines d’intérêt dans le groupe des intervenants du programme, ainsi que des experts entièrement externes au programme, l’ERI assure un contrôle des partis pris. Un avantage particulier est l’inclusion d’une preuve d’expert externe qui n’est souvent pas incluse dans les évaluations, mais qui peut s’avérer utile pour jeter une lumière sur les questions d’évaluation liées à la pertinence, à l’efficacité et à l’impact (ou l’impact éventuel).

- Processus participatif : L’ERI est axée sur la participation de tous les intervenants dans le cadre de l’évaluation. Les intervenants du programme externes dans un projet pilote, par exemple, ont commenté qu’ils avaient aimé le fait de voir le portrait complet de ce que le programme tentait d’accomplir, car il n’avait participé qu’à un seul aspect. Le sommaire du programme appuie ce processus, aidant à mobiliser tous les intervenants et à élaborer la base pour le reste de l’évaluation.

- Constatations complémentaires : L’ERI est une source de données supplémentaire qui peut compléter les méthodes d’évaluation utilisées, ce qui permet la triangulation et une confiance accrue à l’égard des résultats de l’évaluation.

- (Relativement) rapide et souple : En raison de sa rapidité et de sa souplesse relatives, ainsi que de l’utilisation du contrefactuel, l’ERI est bien placée pour être menée pendant la conception du programme, ce qui aide à informer les gestionnaires des coûts et des avantages des différentes possibilités. Un des projets pilotes a mis en évidence que cela était particulièrement utile, car, de la façon que l’évaluation était menée, les gestionnaires de programme envisageaient un renouvellement du programme, l’ERI les a donc aidés à discuter de cette question. Elle peut également être menée ex poste.

Difficultés

- Évaluations d’experts : L’ERI s’appuie sur des jugements d’expert pour apprécier l’impact plutôt que sur l’observation et la collecte directe de données sur le rendement du programme, ce qui peut s’avérer insuffisant en soi pour répondre aux besoins de la direction et de la production des rapports publics.

- Conseillers techniques : L’ERI demande aux évaluateurs d’identifier des experts et conseillers techniques de l’extérieur du programme. Cela peut parfois poser des difficultés et nécessiter plusieurs conversations avec les collègues pour identifier la personne appropriée qui apportera une valeur ajoutée.

- Contrefactuels : L’ERI repose sur la présence d’un bon contrefactuel. Pour les évaluateurs qui connaissent moins bien ces outils, notamment la première fois qu’ils procèdent à l’ERI, il y a une période d’apprentissage à laquelle il est important de consacrer le temps nécessaire.

- Contextes complexes : Certains contextes peuvent ne pas se prêter à l’ERI, plus particulièrement si un programme est trop complexe pour permettre l’établissement d’un contrefactuel convaincant ou pour permettre aux experts d’évaluer raisonnablement les impacts du programme.

- Énoncé d’impact : Il est important que le lecteur de l’évaluation soit en mesure de comprendre clairement ce qui est énoncé en déterminant l’impact du programme. Il peut être utile de demander à un autre évaluateur, idéalement une personne qui ne connaît pas très bien l’ERI, d’examiner le rapport d’évaluation. La rétroaction et les questions du programme portant sur le rapport préliminaire peuvent également aider à déterminer les endroits où il faut apporter plus de clarté.

6.0 Conclusions

L’ERI peut constituer un ajout important à la boîte à outils d’un évaluateur. Comme pour toutes les méthodes d’évaluation, elle n’est pas appropriée partout et elle ne permet pas de répondre à toutes les questions, mais elle peut donner une bonne idée de la façon dont les experts évaluent l’impact d’un programme et elle appuie la mobilisation d’une grande variété de perspectives et de points de vue, à la fois internes et externes. Que ce soit dans le cadre d’une approche complète ou dans le cadre d’une évaluation générale à méthodes mixtes, on encourage les évaluateurs à envisager le recours à l’ERI et à d’autres méthodes pour appuyer leurs évaluations.

Renseignements

Pour obtenir de plus amples renseignements sur l’évaluation et les sujets connexes, consultez la section Centre d’excellence en évaluation du site Web du Secrétariat du Conseil du Trésor du Canada et la Politique sur les résultats.

Vous pouvez aussi communiquer directement avec nous à l’adresse suivante :

Division des résultats

Secteur de la gestion des dépenses

Secrétariat du Conseil du Trésor du Canada

Courriel : results-resultats@tbs-sct.gc.ca

Annexe A : organigramme de l’évaluation rapide de l’impact

Figure 01 - Version texte

Figure 1 is a flow chart of the four phases of a rapid impact evaluation.

La figure 1 est un organigramme des quatre phases d’une évaluation rapide de l’impact.

Au cours de la phase 1, l’évaluation est prévue, y compris obtenir les approbations nécessaires, identifier les experts qui seront consultés et entamer le processus de passation des marchés.

Au cours de la phase 2, un sommaire du programme est élaboré.

Au cours de la phase 3, des experts sont consultés sur la probabilité et l’ampleur de chaque résultat par rapport à un contrefactuel fondé sur les scénarios.

Au cours de la phase 4, les jugements des experts servent à estimer l’incidence globale du programme, et les résultats de l’évaluation font l’objet d’un rapport.

Annexe B : projet pilote

Vous trouverez ci-après le détail du processus d’évaluation rapide de l’impact (ERI) utilisé dans chaque ministère participant au projet pilote ainsi que des réflexions et observations d’ordre général. Prière de retenir que le projet pilote ne touchait que trois phases de l’ERI. Par conséquent, une partie de l’information ci-dessous a été remaniée par mesure de conformité au guide.

Rapports d’évaluation

- Évaluation des activités liées aux zoonoses infectieuses non entériques menées par l’Agence de la santé publique du Canada 2010-2011 à 2015-2016

- Rapport d’évaluation : Programme écoÉNERGIE pour les carburants de remplacement