Examiner l'utilisation des ressources des programmes dans le cadre de l'évaluation des programmes fédéraux

Avis aux lecteurs

La Politique sur les résultats est entrée en vigueur le 1er juillet 2016 et elle a remplacé la Politique sur l’évaluation et ses instruments.

Depuis 2016, le Centre d’excellence en évaluation a été remplacé par la Division des résultats.

Pour de plus amples renseignements sur les évaluations et les sujets connexes, veuillez consulter la section Évaluation du site Web du Secrétariat du Conseil du Trésor du Canada.

Centre d'excellence en évaluation

Secteur de la gestion des dépenses

Secrétariat du Conseil du Trésor du Canada

ISBN : 978-0-660-20845-9

No de catalogue BT32-43/2013F-PDF

© Sa Majesté la Reine du chef du Canada,

représentée par le président du Conseil du Trésor, 2013

Ce document est disponible en médias substituts sur demande.

Nota : Pour ne pas alourdir le texte français, le masculin est utilisé pour désigner tant les hommes que les femmes.

Table des matières

- Introduction

- 1.0 L'optimisation des ressources dans le cadre d'évaluations fédérales

- 2.0 Comprendre la question fondamentale 5 : Démonstration d'efficience et d'économie

- 3.0 Définir la portée de la question fondamentale 5 dans les évaluations : Choisir une perspective

- 4.0 Aperçu de diverses approches analytiques permettant d'examiner la question fondamentale 5

- 5.0 Modèles logiques, théorie du programme, information sur les coûts et question fondamentale 5

- 6.0 Les prochaines étapes pour la collectivité fédérale de l'évaluation

- 7.0 Suggestions et demandes de renseignements

- Annexe A : Évolution des enjeux dans les évaluations au gouvernement fédéral de 1977 à 2009

- Annexe B : Le rendement dans les évaluations des programmes fédéraux

- Annexe C : L'état de préparation des programmes en vue de l'examen de la question fondamentale 5

- Annexe D : Rôles et responsabilités en ce qui concerne la question fondamentale 5

- Annexe E : Optimisation des intrants et des extrants

- Annexe F : Analyse de l'efficience opérationnelle

- Annexe G : Analyse de l'économie

- Annexe H : Bibliographie

Introduction

Contexte : Pourquoi examiner l'utilisation des ressources des programmes dans le cadre de l'évaluation des programmes fédéraux?

Au gouvernement du Canada, l'évaluation consiste à recueillir et à analyser systématiquement des preuves sur les résultats des programmes afin d'en déterminer la pertinence et le rendement et d'examiner d'autres modes d'exécution des programmes ou d'autres façons d'obtenir les mêmes résultats. L'évaluation a pour but de fournir aux Canadiens, aux parlementaires, aux ministres, aux administrateurs généraux, aux gestionnaires de programme et aux organismes centraux une appréciation neutre et fondée sur des preuves de l'optimisation des ressources dans le cadre des programmes, des initiatives et des politiques du gouvernement fédéral (Canada, 2009c, paragraphes 3.1, 3.2, 5.1 et 5.2)1. Ce faisant, l'évaluation soutient les activités suivantes :

- Reddition de comptes par la présentation de rapports publics sur les résultats

- Gestion des dépenses

- Gestion axée sur les résultats

- Amélioration des politiques et des programmes

Pour soutenir de manière adéquate ces activités, les évaluations doivent examiner non seulement la pertinence des programmes et l'obtention des résultats, mais aussi les ressources qu'ils utilisent. Les évaluations doivent explorer des questions comme la nature des ressources utilisées pour obtenir les extrants et les résultats ainsi que la façon dont ces ressources ont été utilisées, déterminer si l'ampleur des ressources utilisées était raisonnable, compte tenu du niveau d'extrants et de résultats observés, et vérifier s'il y a des solutions de rechange susceptibles de donner des résultats identiques ou semblables (voire d'autres résultats) à partir d'un niveau de ressources identique ou différent.

L'examen de l'utilisation des ressources des programmes dans le cadre de l'évaluation des programmes fédéraux au Canada n'a rien de nouveau. Toutes les politiques sur l'évaluation, depuis la première qui remonte à 1977, ont exigé que les évaluateurs examinent un aspect ou un autre de l'utilisation des ressources dans le cadre de leur évaluation2. Au fil du temps, cette exigence a trouvé son expression dans les enjeux sur lesquels portait l'évaluation, comme l'efficience et le rapport coûts-efficacité3. Tout récemment, la Directive sur la fonction d'évaluation du Secrétariat du Conseil du Trésor du Canada (Canada, 2009a)4 énonçait une série de cinq « questions fondamentales » devant être prises en considération dans les évaluations des programmes fédéraux. La question fondamentale 5, Démonstration d'efficience et d'économie, exige que les évaluations comportent un examen de l'utilisation des ressources des programmes relativement à la production des extrants et aux progrès réalisés concernant l'atteinte des résultats escomptés.

Au sujet du présent document : destinataires et usages

Le présent document a été conçu pour les évaluateurs des programmes du gouvernement fédéral ainsi que les gestionnaires de programme, les gestionnaires des finances et les planificateurs ministériels. Pour aider ces usagers à mieux comprendre, planifier et exécuter des évaluations qui incluent un examen de l'utilisation des ressources de programme, le document :

- clarifie l'objet de l'examen de l'utilisation des ressources en tant que question fondamentale dans le cadre d'évaluations;

- facilite la définition de la portée des examens de l'utilisation des ressources de programme;

- expose un éventail d'approches pour l'examen de l'utilisation des ressources de programme;

- fournit du soutien méthodologique pour la réalisation de certains genres d'examen de l'utilisation des ressources de programme.

Il importe de noter qu'il n'y a pas d'approche universelle à l'examen de l'utilisation des ressources d'un programme dans le cadre d'évaluations. Le présent document ne se veut donc pas un guide à suivre étape par étape. Il s'agit plutôt d'un document d'orientation pour l'examen de la question fondamentale 5. Au moment de réaliser des examens de l'utilisation des ressources de programme dans le cadre d'évaluations, les chefs de l'évaluation ainsi que les gestionnaires de l'évaluation et les évaluateurs devront veiller à ce que les personnes ou les équipes qui effectuent le travail possèdent les connaissances, les compétences, les aptitudes et l'expérience nécessaires pour mener à bien les examens de l'utilisation des ressources de programme avec un degré acceptable de qualité, de rigueur et de crédibilité.

Remerciements

Le présent document a été préparé par le Centre d'excellence en évaluation du Secrétariat du Conseil du Trésor du Canada avec l'appui de Greg Mason, ph. d.

Le Centre d'excellence en évaluation tient à remercier les ministères et organismes qui ont examiné et commenté les versions préliminaires du présent document.

1.0 L'optimisation des ressources dans le cadre d'évaluations fédérales

Optimisation des ressources

=

Démonstration de la pertinence

+

Démonstration du rendement

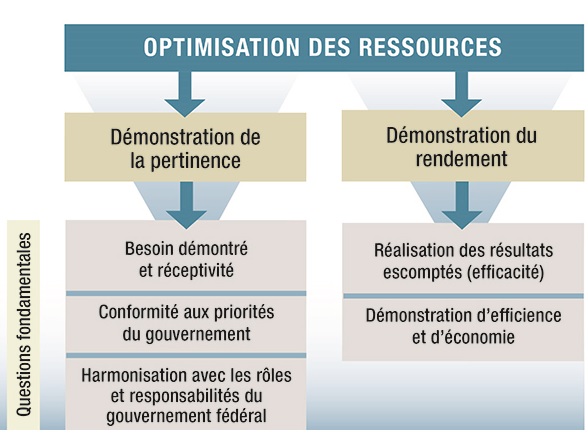

Dans le contexte de l'évaluation, l'optimisation des ressources, telle que le Conseil du Trésor la définit dans la Politique sur l'évaluation (Canada, 2009c), est la mesure dans laquelle un programme est pertinent et affiche un bon rendement. Cette définition table sur les définitions traditionnelles de l'optimisation des ressources, qui, de façon générale, mettent seulement l'accent sur l'efficacité, l'efficience ou l'économie des programmes (Bhatta, 2006, pp. 185 à 187, 662). Aux fins de l'évaluation, l'intégration de la pertinence au concept de l'optimisation des ressources permet aux évaluateurs de présenter des conclusions sur le rendement qui sont mieux contextualisées (c'est-à-dire que les données sur le rendement peuvent être interprétées par rapport à des enjeux comme le besoin sociétal auquel le programme répond ou la priorité que le gouvernement élu accorde au programme). En présentant des constatations et des conclusions plus contextualisées, les évaluations permettront de mieux soutenir le processus décisionnel concernant l'amélioration des programmes et la gestion des dépenses (y compris l'examen des dépenses).

L'annexe A de la Directive sur la fonction d'évaluation offre un cadre analytique qui permet de tirer des conclusions sur la pertinence et le rendement des programmes selon cinq questions fondamentales (QF) que doivent aborder toutes les évaluations entreprises en conformité de la Politique sur l'évaluation5. Parmi ces cinq QF, trois portent sur la pertinence du programme et deux sur le rendement du programme :

Questions fondamentales concernant la pertinence

- Question 1 : Besoin continu du programme : Évaluation de la mesure dans laquelle le programme continue de répondre à un besoin démontrable et est réceptif aux besoins des Canadiens.

- Question 2 : Conformité aux priorités du gouvernement : Évaluation des liens entre les objectifs du programme, les priorités du gouvernement fédéral et les résultats ministériels stratégiques.

- Question 3 : Harmonisation avec les rôles et responsabilités du gouvernement fédéral : Évaluation du rôle et des responsabilités du gouvernement fédéral relativement à l'exécution du programme.

Questions fondamentales concernant le rendement (efficacité, efficience et économie)

- Question 4 : Réalisation des résultats escomptés : Évaluation des progrès réalisés dans l'atteinte des résultats escomptés (y compris les résultats immédiats, intermédiaires et ultimes) par rapport aux cibles de rendement, ainsi qu'à la portée et à la conception du programme, ce qui comprend les liens et la contribution des extrants aux résultats.

- Question 5 : Démonstration d'efficience et d'économie : Évaluation de l'utilisation des ressources relativement à la production des extrants et aux progrès réalisés concernant l'atteinte des résultats escomptés.

Ces cinq QF constituent les secteurs d'intérêt clés que les évaluateurs doivent explorer (mais auxquels ils ne sont pas tenus de se limiter) pour tirer des constatations significatives à l'appui des conclusions sur la pertinence et le rendement des programmes.

Figure 1 - Version textuelle

La Figure 1 représente une déconstruction du concept d'optimisation des ressources qui démontre à son tour de quelle façon les cinq questions fondamentales à être examinées dans l'évaluation des programmes fédéraux cadrent dans le concept.

Selon la Figure 1, l'optimisation des ressources est définie comme comprenant a) une démonstration de la pertinence du programme et b) une démonstration du rendement du programme.

La démonstration de la pertinence du programme est définie comme comprenant et étant abordée par trois questions fondamentales : Question fondamentale 1 – Besoin démontré et réceptivité; Question fondamentale 2 – Conformité aux priorités du gouvernement; et Question fondamentale 3 – Harmonisation avec les rôles et responsabilités du gouvernement fédéral.

La démonstration du rendement du programme est définie comme comprenant et étant abordée par deux autres questions fondamentales : Question fondamentale 4 – Réalisation des résultats escomptés (efficacité) et Question fondamentale 5 – Démonstration d'efficience et d'économie.

On trouvera à l'annexe B une analyse plus détaillée du concept du rendement dans les évaluations des programmes fédéraux.

2.0 Comprendre la question fondamentale 5 : Démonstration d'efficience et d'économie

2.1 Pourquoi examiner l'utilisation des ressources de programme dans le cadre d'évaluations?

Les évaluations qui se concentrent seulement sur la réalisation des résultats des programmes, sans prendre en considération l'utilisation des ressources, ne donnent qu'un aperçu du rendement (Yates, dans l'ouvrage collectif publié sous la direction de Bickman et Rog, 1998, p. 286; Herman et coll., 2009, p. 61). Les besoins en matière d'information des principaux usagers des évaluations sont à l'origine de l'intégration dans la Directive sur la fonction d'évaluation d'une question fondamentale liée à l'utilisation des ressources de programme dans le cadre de l'évaluation des programmes fédéraux. Pour être en mesure de prendre de meilleures décisions (p. ex., au sujet de l'amélioration des programmes ou des politiques et de la gestion des dépenses), les administrateurs généraux des ministères, les cadres supérieurs, les gestionnaires de programme et les organismes centraux doivent être sensibilisés non seulement à la pertinence du programme, aux résultats observés et à la contribution du programme à ces résultats, mais aussi à des questions comme les suivantes :

- Quelles ressources sont consommées par les programmes et comment le sont-elles?

- Quel rapport y a-t-il entre ces ressources et la réalisation des issues (extrants et résultats)?

- De quelle façon la pertinence du programme et d'autres facteurs contextuels influent-ils sur les ressources consommées et les résultats observés?

- Y a-t-il des solutions de rechange possibles aux programmes existants ou aux approches en matière de consommation des ressources?

Comprendre le rôle que jouent les ressources relativement au rendement des programmes fédéraux, voilà qui aide également les gestionnaires de programme et les planificateurs ministériels à rendre des comptes plus complets sur le rendement dans leurs rapports aux parlementaires et à la population canadienne.

En somme, la QF5 est censée être le fondement sur lequel les évaluateurs peuvent appuyer leurs examens de l'utilisation des ressources dans le cadre des programmes fédéraux.

L'évaluation, la vérification et la QF5

Aux fins de la QF5, les évaluateurs ne sont pas tenus d'examiner divers secteurs d'intérêt comme s'ils en faisaient la vérification (c'est-à-dire l'examen de la conception, de la fonction, de l'intégrité et de la qualité de la gestion des risques, des systèmes de contrôle et de la gouvernance) (Canada, 2009d, paragraphe 3.3). La QF5 se concentre plutôt sur la relation qui existe entre l'utilisation des ressources, la réalisation des résultats, la pertinence du programme et le contexte dans lequel il s'inscrit.

2.2 Perspectives flexibles relatives à la question fondamentale 5

2.2.1 Définir la question fondamentale 5

Selon la Directive sur la fonction d'évaluation (Canada, 2009a), la QF5 (Démonstration d'efficience et d'économie) se définit comme une « évaluation de l'utilisation des ressources relativement à la production des extrants et aux progrès réalisés concernant l'atteinte des résultats escomptés. »

En ne se concentrant pas strictement sur le rapport coût-efficacité, comme c'était le cas dans le cadre de la Politique d'évaluation (Canada, 2001) de 2001, la QF5 offre aux évaluateurs une certaine flexibilité pour définir la portée et déterminer les aspects de l'utilisation des ressources qu'il convient d'explorer dans le contexte de telle ou telle évaluation.

Au sens le plus large, l'examen de l'utilisation des ressources s'intéresse à la mesure dans laquelle le programme fait preuve d'efficience ou d'économie dans l'utilisation des ressources. Il importe toutefois de préciser que ces deux concepts – l'efficience et l'économie – représentent un vaste éventail d'axes et d'approches possibles en ce qui concerne l'examen de l'utilisation des ressources de programme.

Rendement du programme

=

Réalisation des résultats escomptés

+

Démonstration d'efficience et d'économie

Il est également important de préciser que les examens de l'efficience et de l'économie sont liés à l'examen de l'efficacité du programme (c'est-à-dire de la mesure dans laquelle les résultats escomptés sont réalisés), comme on le voit dans la QF4 (Réalisation des résultats escomptés). Ensemble, la QF4 et la QF5 représentent une analyse du rendement global des programmes.

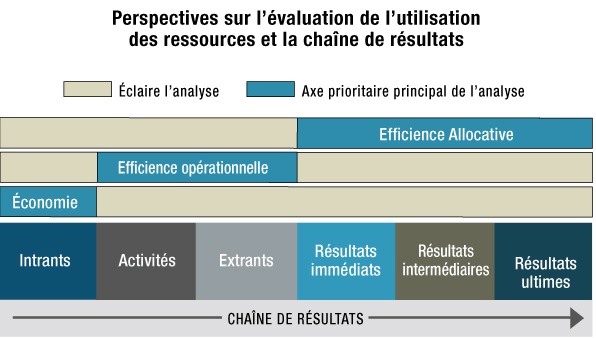

2.2.2 Démonstration d'efficience

Axe prioritaire de l'analyse

- Efficience allocative :

- se concentre généralement sur la relation entre les ressources et les résultats

- Efficience opérationnelle :

- se concentre généralement sur la relation entre les ressources et les extrants

De façon générale, la démonstration d'efficience dans les programmes fédéraux peut être abordée selon deux perspectives : l'efficience « allocative » et l'efficience « opérationnelle ».

- Efficience allocative :

- Cette façon d'aborder l'efficience s'intéresse généralement à la vue d'ensemble, c'est-à-dire à la question de savoir si les ressources consommées pour atteindre les résultats étaient raisonnables, compte tenu d'enjeux comme le degré de réalisation des résultats, le contexte du programme et les solutions de rechange au programme. Les genres de questions posées et d'analyses employées aux fins de l'examen de l'efficience allocative reposent généralement sur une comparaison des coûts et des résultats d'interventions qui ont des buts identiques ou semblables (p. ex., deux programmes ou deux éléments du même programme) ou sur une comparaison d'un programme existant et d'une solution de rechange réelle ou hypothétique. Souvent, l'examen de l'efficience allocative peut se faire par le biais d'approches propres à l'analyse des coûts ou à l'analyse économique (p. ex., analyse du rapport coût-efficacité). Cependant, dans certains cas, on peut aussi avoir recours à des approches plus qualitatives (p. ex., des approches reposant sur l'utilité).

- Efficience opérationnelle

- (Eureval/Centre européen d'expertise en évaluation, 2006, p. 2) : L'efficience opérationnelle, qui revêt divers autres noms (y compris efficience technique [de Salazar et coll., 2007, p. 12], efficience transformationnelle [M. Palenberg et coll., 2011, p. 7.], efficience de la gestion et efficience de la mise en œuvre), s'intéresse avant tout à la façon dont les intrants sont utilisés et convertis en extrants qui soutiennent la réalisation des résultats escomptés. Les questions posées et les analyses employées aux fins de l'examen de l'efficience opérationnelle sont communes, mais non exclusives, aux évaluations formatives, aux évaluations des processus, aux évaluations de la mise en œuvre et aux évaluations de la conception et de l'exécution. Comme on le verra dans la partie qui suit, cet examen comprend souvent une analyse de la mesure dans laquelle les extrants ont été optimisés par rapport aux ressources consommées pour leur production et de la façon dont ils appuient la réalisation des résultats.

2.2.3 Démonstration d'économie

Selon la Politique sur l'évaluation (Canada, 2009c), les évaluations du gouvernement fédéral axent leurs examens de l'économie sur la mesure dans laquelle l'utilisation des ressources a été minimisée dans la mise en œuvre et l'exécution des programmes. Il y a économie lorsque le coût des ressources utilisées se rapproche de la quantité minimale de ressources requises pour obtenir les résultats escomptés. Il ne s'agit pas ici d'un minimum absolu, mais plutôt d'un minimum conceptualisé et contextualisé que l'on détermine en analysant la mesure dans laquelle les coûts des intrants ont été minimisés par rapport au contexte du programme, aux caractéristiques des intrants (comme leur qualité, leur quantité, leur caractère opportun et leur caractère approprié), à la portée des répercussions sur la réalisation des résultats et aux solutions de rechange disponibles. Ce point est abordé plus loin.

La figure 2 illustre la relation qui existe entre les perspectives exposées ci-dessus et les chaînes de résultats des programmes (et donc les modèles logiques).

Figure 2 - Version textuelle

La Figure 2 représente la relation qui existe entre les perspectives analytiques proposées de la Question fondamentale 5 et les éléments d'un modèle logique. À titre d'illustration, on utilise un modèle logique général simplifié. Dans ce modèle, on énumère une liste d'éléments successifs de modèle logique. Ce sont les intrants, les activités, les extrants, les résultats immédiats, les résultats intermédiaires et les résultats ultimes du programme. Ces éléments sont successifs, ce qui signifie que chacun d'eux mène au prochain dans la chaîne (c.-à-d. que les intrants mènent aux activités, les activités mènent aux extrants, les extrants mènent aux résultats immédiats, etc.).

Selon la Figure 2, l'efficience allocative est démontrée comme analyse qui examine principalement la relation entre les intrants et les résultats obtenus d'un programme (au niveau immédiat, intermédiaire ou ultime). L'efficience opérationnelle est présentée comme une analyse qui examine principalement la façon dont les intrants de programmes sont utilisés pour entreprendre des activités qui produisent des extrants. On précise que l'analyse de l'efficience opérationnelle tire son information secondaire des résultats obtenus du programme. Dernièrement, l'économie est présentée comme une analyse qui met principalement l'accent sur les intrants fournis à un programme. On souligne que l'analyse de l'économie tire son information secondaire des extrants et des résultats obtenus du programme.

Dans certains cas, lorsqu'il s'agit d'examiner la QF5, on peut considérer comme étant appropriées des perspectives de rechange qui ne cadrent pas nécessairement dans les catégories énumérées ci-dessus. Si une perspective de rechange est retenue, les évaluateurs devraient présenter une justification appropriée de la sélection de cette approche pour examiner la QF5.

3.0 Définir la portée de la question fondamentale 5 dans les évaluations : Choisir une perspective

Justification du choix de la perspective pour l'examen de la question fondamentale 5

Dans la section Méthodologie des rapports d'évaluation, les évaluateurs devraient expliquer pourquoi ils ont retenu telle ou telle perspective aux fins de l'examen de la QF5.

Les programmes du gouvernement du Canada sont très diversifiés (p. ex., en ce qui a trait aux modèles d'exécution, aux résultats escomptés, aux bénéficiaires, aux priorités gouvernementales, aux cycles de vie et aux niveaux de maturité). Les évaluateurs devront travailler avec les usagers des évaluations et avec les parties intéressées pour déterminer quelles perspectives pour l'examen de la QF5 peuvent et doivent être incluses dans l'évaluation de tel ou tel programme. Voici des exemples de questions susceptibles d'aider les évaluateurs à cet égard :

- À quelles fins l'évaluation servira-t-elle (p. ex., comment sera-t-elle utilisée)? Quels sont les besoins en matière d'information des destinataires? Quelle information et quelles perspectives concernant la QF5 permettront le mieux de soutenir une utilisation significative de l'évaluation?

- À quel stade de développement le programme en est-il (p. ex., en est-il à un stade de son cycle de vie où un examen de l'efficience allocative est faisable)? Ou encore, le programme est-il le plus récent d'une série de programmes qui ont pour objet de régler le même problème?

- Quels sont les principaux mécanismes d'exécution du programme? Y a-t-il des activités et des extrants précis qui contribuent à des résultats particuliers? Ou s'agit-il d'un programme complexe dont les activités et les extrants contribuent à de multiples résultats?

- Quels sont les principaux intrants du programme? S'agit-il principalement de ressources humaines (équivalents temps plein [ETP])? Des biens ou des services sont-ils achetés à titre d'intrants du programme?

- Quel est le profil de risque du programme? Le ministère l'a-t-il désigné comme un programme à risque élevé (p. ex., grande importance relative et grand impact sur la population canadienne)?

- À quand remonte la dernière évaluation? Celle-ci a-t-elle examiné adéquatement la QF5 et permis de tirer des constatations qui suggéraient un rendement acceptable dans ce domaine?

- Y a-t-il des préoccupations connues ou soupçonnées au sujet de l'efficience ou de l'économie du programme? Dans l'affirmative, quelles sont-elles?

- Quelle est la situation des données sur la mesure du rendement disponibles pour soutenir l'évaluation? Les gestionnaires de programme ont-ils mis efficacement en œuvre une stratégie de mesure du rendement qui recueille des données financières et non financières susceptibles d'appuyer un examen de la QF5? Dans la négative, que faudrait-il faire pour recueillir ou formater ces données de façon appropriée, avant ou pendant l'évaluation?6

En explorant ces questions (et d'autres), les évaluateurs peuvent mieux déterminer la ou les perspectives de l'utilisation des ressources qui pourraient être prises en considération dans l'évaluation. Dans plusieurs cas, les évaluations pourraient traiter des trois perspectives. Toutefois, dans certains cas, les évaluations pourraient examiner seulement un sous-ensemble de ces perspectives, afin de soutenir les utilisations prévues de l'évaluation. Le tableau 1 donne des exemples de cas où les trois perspectives pourraient se révéler utiles.

| Perspective | Exemples |

|---|---|

| Efficience allocative |

|

| Efficience opérationnelle |

|

| Économie |

|

À l'appui de l'exercice de définition de la portée exposé ci-dessus, l'annexe C présente une liste de contrôle permettant de déterminer si un programme est prêt à subir un examen au regard de la QF5. L'annexe D, quant à lui, donne un aperçu des rôles et des responsabilités connexes à la préparation et à l'exécution des examens de la QF5.

Comme pour toute évaluation en général, les évaluateurs devront calibrer leur approche de l'examen de la QF5 en fonction des besoins en matière d'information de leurs cadres supérieurs et des risques associés au programme.

La QF5 : Examiner l'efficience et l'économie?

Les évaluations sont utilisées par toute une gamme d'intervenants – administrateurs généraux, gestionnaires de programme, planificateurs ministériels et analystes des organismes centraux – pour soutenir une variété de fonctions de prise de décisions, d'apprentissage et de production de rapports. En principe, la meilleure façon de répondre aux besoins de ces usagers est d'examiner à la fois l'efficience et l'économie dans le cadre des évaluations. Cependant, dans certains cas (p. ex., les évaluations de programmes présentant des risques extrêmement faibles qui comportent des mécanismes d'exécution simples, des chaînes de résultats peu complexes et un seul intrant, comme des ETP), on pourrait soutenir que l'examen de l'économie n'est pas pratique ou faisable. Dans de tels cas, les ministères devraient fournir une explication ou une analyse permettant de comprendre pourquoi il n'est pas pratique ou faisable d'aborder les questions liées à l'économie.

4.0 Aperçu de diverses approches analytiques permettant d'examiner la question fondamentale 5

Dès lors que l'exercice de définition de la portée a permis de déterminer les perspectives à examiner pendant l'évaluation et que les questions sur lesquelles portera l'évaluation ont été établies, les évaluateurs doivent choisir une ou plusieurs approches analytiques pour procéder à l'examen de la QF5.

On peut considérer que les approches permettant d'examiner l'utilisation des ressources de programme dans le cadre d'évaluations se situent sur un continuum qui comprend les éléments suivants7 :

- Les approches comparatives axées sur les coûts :

- Ces approches à l'examen de la QF5 consistent généralement à comparer les ressources utilisées pour un aspect du programme (p. ex., le coût par résultat, le coût par extrant, le coût des intrants) aux ressources utilisées dans le cadre d'autres programmes (souvent des programmes de rechange) dont les résultats escomptés sont identiques ou semblables, ou à une autre norme connue (p. ex., une norme de référence ou une cible en matière de coûts).

- Les approches qualitatives ou mixtes :

- Ces approches nécessitent généralement que l'évaluateur porte un jugement appuyé sur des données qualitatives et quantitatives concernant l'utilisation des ressources dans le cadre du programme, pour en tirer des constatations et des conclusions. Ces approches vont d'examens et de comparaisons d'ordre qualitatif hautement structurés à des solutions de rechange théoriques, en passant par des jugements d'experts et des examens de l'optimisation.

- Les approches descriptives :

- Il s'agit d'approches qui ne comportent pas de critiques et qui se limitent à rapporter des faits au sujet de l'utilisation des ressources dans le cadre d'un programme (p. ex., énoncé des budgets réels, coût par extrant, coût par résultat). Aucune analyse n'est fournie et l'évaluateur ne porte pas de jugement. Même si les analyses descriptives sont généralement insuffisantes pour examiner la QF5 de manière significative, elles peuvent constituer le fondement des approches qualitatives ou mixtes et des approches comparatives axées sur les coûts décrites ci-dessus.

Continuum des approches analytiques pour l'examen de la QF5

Ce continuum des approches analytiques à l'examen de la QF5 est analogue au continuum allant des évaluations expérimentales aux évaluations non expérimentales, puis aux évaluations descriptives pour l'examen de l'efficacité des programmes :

- Approches comparatives axées sur les coûts :

- Tester l'utilisation des ressources à partir d'une approche contrefactuelle.

- Approches qualitatives ou mixtes :

- Bâtir des théories et tester l'utilisation des ressources à partir d'une solution de rechange contre-hypothétique ou postulée.

- Approches descriptives :

- Fournir des données empiriques sans analyse.

Sur ce continuum, diverses approches peuvent être utilisées à l'appui d'une analyse de la QF5. Certaines des approches les plus fréquentes sont exposées au tableau 28. Il est important de savoir qu'il ne s'agit là que d'un petit échantillon des approches que les évaluateurs voudront peut-être retenir pour l'examen de la QF5.

| Approche analytique | Comparative axée sur les coûts (CC) Qualitative ou mixte (QM) | Perspective principale de l'examen de la QF5 qui est généralement analysée au moyen de cette approcheVoir la note * du tableau 2 |

|---|---|---|

Notes du tableau 2

|

||

| Analyse coût-efficacité | CC | Efficience allocative |

| Analyse coût-avantage | CC (QM)Voir la note † du tableau 2 | Efficience allocative |

| Analyse coût-utilité | CC (QM) | Efficience allocative |

| Analyses de l'efficience opérationnelle – Exemples : | ||

|

CC | Efficience opérationnelle |

|

CC | Efficience opérationnelle |

|

QM (CC) | Efficience opérationnelle |

|

QM | Efficience opérationnelle |

|

QM (CC) | Efficience opérationnelle |

|

QM | Efficience opérationnelle |

|

CC ou QM | Efficience opérationnelle |

| Analyse de l'économie – Exemples : | ||

|

CC | Économie |

|

CC | Économie |

|

CC | Économie |

|

QM (CC) | Économie |

Voici des résumés de ces différentes approches.

Analyse coût-efficacité (ACE) : De façon générale, l'ACE consiste en un examen comparatif des coûts par « unité » de résultat (rapport coût-efficacité) entre deux ou plusieurs éléments de programme (p. ex., le programme dans son ensemble, les éléments de son exécution ou des solutions de rechange réelles ou hypothétiques) qui a) ont des résultats escomptés identiques (ou très semblables) et b) peuvent être évalués au moyen des mêmes mesures ou des mêmes critères (Levin et McEwan, 2001, pp. 10 à 11). Par exemple, l'évaluation d'un programme de renoncement au tabac peut faire appel à une ACE pour comparer le coût relatif par participant ayant cessé de fumer selon deux approches, à savoir les groupes de soutien et les méthodes individuelles de remplacement de la nicotine (gomme à mâcher, pastilles ou timbres) (Herman et coll., 2009, pp. 56 à 57).

Analyse coût-avantage (ACA) : Au sens classique du terme, l'ACA (parfois appelée analyse avantage-coût) renvoie à des approches analytiques qui ont pour objet de monétiser (c'est-à-dire attribuer une valeur monétaire) tous les coûts et tous les avantages d'un programme (p. ex., le programme dans son ensemble, les éléments de son exécution) et de comparer leurs valeurs actualisées nettes, habituellement exprimées sous la forme d'un rapport coût-avantage. Ainsi, l'ACA permet aux évaluateurs de comparer les avantages (réels ou possibles) de programmes (ou d'éléments de programme) dont les résultats escomptés sont différents (Brent, 2002, pp. 144 à 146; Levin et McEwan, 2001, pp. 11 à 19). Par exemple, l'ACA peut être utilisée comme outil d'évaluation qui aide les décideurs à choisir entre deux programmes sans rapport l'un avec l'autre (p. ex., investir dans un programme de renoncement au tabac ou investir dans l'éducation de la petite enfance). Toutefois, et peut-être plus fréquemment, l'ACA peut être utilisée pour comparer des programmes plus ou moins connexes (p. ex., comparer les avantages nets d'un programme de détournement des eaux en cas d'inondation conçu pour lutter contre les inondations moyennes et ceux d'un programme conçu pour affronter les pires inondations).

L'une des caractéristiques distinctives de l'ACA est que, en principe, elle aborde les coûts et les avantages d'un point de vue sociétal plus vaste (que d'autres approches comme l'ACE, qui tend à se concentrer sur le programme) (Herman et coll., 2009, p. 56). Ainsi, l'ACA peut être utile, en particulier pour examiner les enjeux connexes à l'efficience allocative. L'ACA peut aussi être utile pour repérer les résultats ou les issues imprévus des programmes. Compte tenu de sa sensibilité, l'ACA peut être moins utile pour éclairer les examens concernant les perspectives de l'efficience opérationnelle ou l'économie des intrants, selon le niveau auquel les coûts et les avantages sont déterminés9.

L'un des défis de l'ACA est celui de la quantification et de la monétisation des coûts et des avantages. Pour relever ce défi, plusieurs auteurs ont proposé des approches permettant d'intégrer des éléments qualitatifs à l'ACA, ce qui a donné lieu à l'émergence de l'analyse qualitative coût-avantage, qui a pour objet de rendre compte des avantages et des coûts des programmes de façon plus exhaustive (Rogers, Stevens et Boymal, 2009, pp. 84, 89; van den Bergh, 2004, pp. 389 à 392).

Analyse coût-utilité (ACU) : L'ACU, qui est apparentée à l'ACE, compare l'utilité d'un programme (c'est-à-dire l'intérêt du programme, sa valeur, son mérite ou le degré de satisfaction vis-à-vis de ses résultats, habituellement du point de vue des bénéficiaires) en fonction de ses coûts (Levin et McEwen, 2001, pp. 19 à 22; White et coll., 2005, pp. 7 à 8). Dans le cadre de certaines ACU, « l'utilité » est un concept hautement structuré (p. ex., dans le secteur de la santé, l'utilité est mesurée du point de vue de l'espérance de vie ajustée selon la qualité de vie ou de l'équivalent d'années en bonne santé). Toutefois, selon de nouvelles indications, on dispose d'une certaine latitude pour élaborer d'autres « unités » quantitatives ou qualitatives de l'utilité (p. ex., des unités construites au niveau des résultats immédiats ou intermédiaires) dans le cadre de ce qu'on pourrait qualifier d'approche réaliste ou calibrée de l'analyse du caractère raisonnable des coûts par rapport aux résultats. L'ACU peut être particulièrement utile pour examiner l'efficience allocative. Parallèlement, l'ACU peut donner des pistes de réflexion au sujet de préoccupations possibles concernant l'efficience opérationnelle ou l'économie selon la perspective des usagers du programme (c'est-à-dire les bénéficiaires) ou des perspectives autres.

Analyse de l'efficience opérationnelle (AEO) : Aux fins des évaluations des programmes fédéraux, l'AEO (qui renvoie directement à la perspective de l'efficience opérationnelle relative à l'examen de la QF5 dont il a été question ci-dessus) réunit une vaste gamme d'approches analytiques qui peuvent être utilisées pour examiner la façon dont les programmes sont gérés et organisés à l'appui de la réalisation des résultats. Ces approches peuvent inclure des modèles fondés sur les coûts qui se concentrent sur l'examen des coûts d'extrants particuliers par rapport à des facteurs de comparaison (p. ex., coûts prévus, normes de comparaison), des examens de l'optimisation des extrants ou des enjeux connexes à l'efficience, et des occasions à exploiter au niveau des activités de programme. Ces analyses sont entreprises sur la base de la pertinence du programme et d'autres enjeux contextuels (Eureval/Centre européen d'expertise en évaluation, 2006, p. 14). Toutefois, même si certaines approches de l'AEO peuvent faire appel à des données de vérification, l'analyse n'est pas conçue pour reproduire ou recouper les vérifications internes qui portent sur la conception et le fonctionnement des processus de gestion des risques, de contrôle et de gouvernance – souvent au niveau de l'organisation (plutôt qu'au niveau du programme) (Canada, 2009d, paragraphe 3.3). Voici quelques exemples d'approches analytiques pour l'analyse de l'efficience opérationnelle :

- Analyse par rapport à une norme de référence : Comparaisons du coût réel par unité d'extrant de programme par rapport à une norme connue ou à une pratique exemplaire (McDavid et Hawthorn, 2006). Lorsque le coût réel par unité d'extrant s'éloigne beaucoup de la norme de référence, l'évaluateur peut chercher une justification raisonnable pour expliquer l'écart et déterminer quel effet, le cas échéant, cet écart a eu sur la production des extrants ou sur la réalisation des résultats.

- Comparaison et analyse des coûts prévus par rapport aux coûts réels/suivi et analyse des dépenses : Comparaisons des coûts prévus du programme (p. ex., par unité d'extrant, par poste budgétaire) avec les coûts réels ou avec une tendance des coûts des extrants au fil du temps. En présence d'écarts significatifs au niveau des coûts, l'évaluateur peut chercher une justification raisonnable pour expliquer l'écart et déterminer quel effet, le cas échéant, cet écart a eu sur la production des extrants ou sur la réalisation des résultats.

- Cartographie et analyse des processus opérationnels : De façon générale, la cartographie et l'analyse des processus opérationnels renvoient à une gamme d'activités qui consistent à repérer les processus clés d'exécution et analyser ces mêmes processus pour déterminer si des défis (p. ex., goulots d'étranglement) entravent la production des extrants et la réalisation des résultats ou si les processus sont inefficaces pour d'autres raisons. Ces processus opérationnels peuvent être cartographiés au moyen de modèles logiques ou de théories de programme. Dans certains cas, on peut chiffrer les processus cartographiés pour pouvoir faire une analyse des coûts. Dans d'autres cas, l'approche pourrait être davantage qualitative (p. ex., reposer sur l'observation des processus opérationnels, des entrevues avec des intervenants de premier plan).

- Examen de fidélité (O'Connor, Small et Cooney, 2007)/mise à l'essai de la théorie d'exécution : Les examens de fidélité, ou la mise à l'essai d'une théorie de l'exécution, représentent généralement des approches qualitatives de l'examen de l'efficience opérationnelle. Ces approches se concentrent sur la détermination de la mesure dans laquelle l'exécution du programme respecte les plans initiaux, la détermination des écarts au chapitre de l'exécution et l'examen de ces écarts pour établir les motifs qui les justifient et l'effet qu'ils ont eu sur les coûts ou sur la production des extrants, la réalisation des résultats ou les coûts. Ces approches permettent également de réaliser un examen des changements apportés par le programme dans son approche d'exécution et de l'incidence de ces changements sur les coûts ou sur la production d'extrants ou la réalisation de résultats. Lorsque c'est possible, ces approches peuvent être combinées avec des approches comparatives basées sur les coûts.

- Appréciation participative : L'appréciation participative est une approche à prédominance qualitative qui repose sur la collaboration avec des intervenants ayant pour objet de déterminer les inefficiences possibles qui consomment peut-être des ressources inutilement ou qui entravent la production des extrants ou la réalisation des résultats. Des outils comme la cartographie des résultats peuvent se révéler utiles à cet égard 10.

- Analyse de l'optimisation11/opinion d'experts : L'analyse de l'optimisation renvoie à l'examen de la mesure dans laquelle on peut dire que les extrants ont été optimisés lorsque certains facteurs, comme le coût, la quantité, la qualité, le caractère actuel et le caractère adéquat des extrants produits, ont été mis en balance par les gestionnaires de programme d'une manière rationnelle défendable en tenant compte de la théorie du programme (c'est-à-dire les hypothèses, les risques, les mécanismes et le contexte), de la pertinence (c'est-à-dire les QF1, QF2 et QF3) et des issues observées (c'est-à-dire les résultats) du programme (QF4). On peut dire qu'il y a des inefficiences lorsqu'un ou plusieurs facteurs d'optimisation n'ont pas été mis en balance adéquatement et que la production des extrants ou la réalisation des résultats en ont subi les conséquences. De la même façon, l'opinion d'experts renvoie à d'autres approches de l'examen de l'optimisation basées sur les connaissances et l'expérience d'un observateur expert. Les approches reposant sur l'opinion d'experts peuvent être formelles (c'est-à-dire recourir à des critères précis) ou informelles. Toutefois, les approches informelles ne devraient être utilisées que rarement et pour des programmes dont le niveau de risque et de complexité ne nécessite qu'une rigueur minimale. On trouvera plus de détails sur le concept de l'optimisation à l'annexe E.

- Comparaison avec des modèles de programme de rechange : Lorsque c'est possible, l'efficience opérationnelle des programmes peut être comparée à celle des programmes de rechange réels ou hypothétiques. Un tel examen peut se baser sur les coûts ou être de nature plus qualitative.

On trouvera à l'annexe F un examen plus poussé de l'analyse de l'efficience opérationnelle, y compris une liste de secteurs d'intérêt courants.

Analyse de l'économie : Aux fins des évaluations des programmes fédéraux, l'analyse de l'économie renvoie à des approches analytiques utilisées pour examiner comment ont été choisis les intrants des programmes12 à l'appui de la production d'extrants et de la réalisation de résultats. Ces approches peuvent comprendre l'analyse des coûts des intrants par rapport à divers facteurs de comparaison (p. ex., les intrants de rechange pour le même modèle d'exécution ou les modèles d'exécution utilisant d'autres intrants) ou un examen des intrants de nature plus qualitative (comme l'analyse de l'incidence des configurations des ressources humaines sur l'exécution du programme et les résultats observés). Ces analyses sont menées sous l'angle de la pertinence du programme et d'autres enjeux contextuels. Comme c'est le cas avec l'analyse de l'efficience opérationnelle, l'analyse de l'économie n'est pas conçue pour reproduire ou recouper les vérifications internes, mais plutôt, lorsque c'est approprié et lorsque de telles données sont disponibles, pour tirer profit de certaines des données produites par les vérifications internes. Exemples d'approches analytiques de l'analyse de l'économie :

- Analyse par rapport à une norme de référence : Semblable à l'analyse par rapport à une norme de référence telle qu'elle est utilisée pour l'analyse de l'efficience opérationnelle (voir ci-dessus), à la différence qu'elle porte ici sur le coût des intrants.

- Comparaison et analyse des coûts prévus par rapport aux coûts réels : Semblable à l'analyse par rapport à une norme de référence telle qu'elle est utilisée pour l'analyse de l'efficience opérationnelle (voir ci-dessus), à la différence qu'elle porte ici sur le coût des intrants.

- Coût comparatif par intrant : Semblable aux comparaisons par rapport à des modèles de programme de rechange dont il a été question ci-dessus. Lorsque c'est possible, l'économie des intrants peut être comparée à celle de solutions de rechange réelles ou hypothétiques.

- Analyse de l'optimisation ou opinion d'experts : Semblable à l'analyse de l'optimisation ou à l'opinion d'experts pour les extrants, à la différence qu'elle porte ici sur les intrants.

On trouvera à l'annexe G un examen plus poussé de l'analyse de l'économie, y compris une liste de secteurs d'intérêt courants.

Cette liste d'approches à l'examen de l'efficience et de l'économie n'est pas exhaustive. D'autres approches analytiques (p. ex., analyse des coût-faisabilité, analyse de la minimisation des coûts, processus décisionnels reposant sur de multiples attributs, etc.) dont nous ne discuterons pas en détail ici peuvent aussi servir de base à l'examen de la QF5.

Un grand nombre des approches exposées ci-dessus nécessitent des connaissances et une expérience précises sur les plans technique et méthodologique. Les chefs de l'évaluation et les gestionnaires de l'évaluation devraient veiller à ce que les personnes ou les équipes qui travaillent à l'examen de la QF5 possèdent (individuellement ou collectivement) les connaissances, les aptitudes et la compétence nécessaires pour exécuter adéquatement les activités et l'analyse requises pour un examen efficace de la QF5.

Comme dans le cas des évaluations en général, les évaluateurs devront calibrer leur approche de l'examen de la QF5 en fonction des besoins en matière d'information de leurs cadres supérieurs et des risques associés au programme.

5.0 Modèles logiques, théorie du programme, information sur les coûts et question fondamentale 5

5.1 Modèles logiques et théorie du programme

Un grand nombre des approches de l'examen de la QF5 exposées dans la section précédente (p. ex., l'analyse coût-efficacité) nécessitent que les évaluateurs définissent des unités d'analyse (p. ex., intrants, activités, extrants, résultats, chaîne de résultats ou gamme de services). De plus, les évaluateurs auront peut-être besoin de se familiariser avec le contexte, les hypothèses, les mécanismes et les risques associés aux programmes. Les modèles logiques et les théories de programme ou théories du changement peuvent aider les évaluateurs à cet égard.

Les modèles logiques

Les modèles logiques constituent un outil de gestion communément reconnu reposant sur les résultats qui est utilisé dans les programmes du gouvernement du Canada. Ils représentent un élément intégral des stratégies de mesure du rendement que les gestionnaires de programme doivent élaborer au stade de la conception des programmes (voir la Directive sur la fonction d'évaluation, 2009, paragraphe 6.2). Dans de nombreux modèles logiques, on retrouve des chaînes de résultats qui alignent les intrants, les activités et les extrants particuliers d'un programme sur ses résultats escomptés.13 Être en mesure de définir les chaînes de résultats du programme, voilà qui peut aider à déterminer les unités d'analyse pour l'examen du coût des extrants ainsi que l'efficience du programme et les processus de gestion censés produire les extrants.

Pour en savoir plus sur les modèles logiques, n'hésitez pas à lire Pour soutenir des évaluations efficaces : Guide d'élaboration de stratégies de mesure du rendement du Secrétariat du Conseil du Trésor du Canada.

La théorie du programme et la théorie du changement

Les gestionnaires de programme sont de plus en plus encouragés, par le biais de leurs stratégies de mesure du rendement, non seulement à définir la logique de leur programme (p. ex., au moyen de modèles logiques), mais aussi à définir une théorie du programme ou théorie du changement qui sous-tendra la logique du programme. Ces théories tablent sur des modèles logiques ou des chaînes de résultats en définissant les mécanismes, les hypothèses, les risques et le contexte qui expliquent comment ou pourquoi un programme est censé fonctionner, comment et pourquoi les résultats escomptés vont se concrétiser, et pourquoi certaines décisions ont été prises quant à l'exécution du programme, le cas échéant.

Une théorie du programme bien énoncée peut aider les gestionnaires de programme et les évaluateurs à définir les unités pouvant être analysées des points de vue de leur économie et de leur efficience relatives.

La théorie du programme peut jouer plusieurs autres rôles relativement à l'examen de la QF5, y compris les suivants :

- Déterminer les processus, les mécanismes et les activités qui sont utilisés pour opérationnaliser le programme et expliquer pourquoi les extrants sont reliés plausiblement aux résultats;

- Déterminer l'attribution prévue des résultats aux extrants, des extrants aux activités et des activités aux intrants, ou la contribution prévue des programmes aux résultats;

- Expliquer les décisions prises par les gestionnaires de programme concernant la conception du programme, la sélection des ressources et de modèles d'exécution, et d'autres décisions clés de mise en œuvre;

- Révéler le contexte du programme (y compris les facteurs sociétaux ou autres qui peuvent appuyer ou entraver la réalisation des résultats escomptés).

Les lecteurs qui souhaitent en savoir plus sont invités à consulter le corpus de plus en plus vaste d'ouvrages sur les évaluations des théories de programme et des théories du changement, ainsi que la publication du Secrétariat du Conseil du Trésor du Canada intitulée Approches d'évaluation axées sur la théorie : Concepts et pratiques.

5.2 Détermination proactive de l'information sur les coûts

Toutes les perspectives en fonction desquelles on peut examiner la QF5 exigent de l'information au sujet des coûts du programme. Les « coûts » s'entendent de la valeur (il s'agit en général, mais pas toujours, de la valeur financière) des ressources consommées pour réaliser une activité, produire un extrant ou atteindre un résultat dans le cadre d'un programme (Guide d'établissement des coûts, Canada, 2008).

Les chefs de l'évaluation, les gestionnaires de programme et l'information sur les coûts

S'il y a lieu, les chefs de l'évaluation devraient profiter de processus comme la formulation de commentaires sur les présentations au Conseil du Trésor, la production du rapport annuel sur l'état de la mesure du rendement et la planification des évaluations ministérielles pour bien faire comprendre aux gestionnaires de programme l'importance de recueillir de l'information sur les coûts d'une manière qui facilite l'examen de la QF5.

Il y a divers coûts normalement associés aux programmes du gouvernement du Canada, et notamment les suivants :

- Coûts d'exploitation :

- On estime généralement qu'il y a quatre genres de coûts d'exploitation – les salaires et avantages sociaux; les coûts opérationnels rattachés aux locaux, les fournitures, les postes de travail, les communications, etc.; les services professionnels; et les frais généraux directs.

- Coûts en capital :

- Ces coûts comprennent le coût des nouvelles immobilisations et le coût du remplacement cyclique des immobilisations.

- Coûts des services fournis par d'autres ministères :

- Dans le cadre de certains programmes, une partie importante des services est offerte par d'autres ministères et organismes gouvernementaux.

- Décaissements à des fins autres que des fins administratives :

- Il s'agit généralement des subventions et contributions ou des paiements de transfert à des tiers responsables de l'exécution ou à d'autres intervenants de l'extérieur du gouvernement fédéral.

- Coûts non gouvernementaux :

- Coûts absorbés par d'autres intervenants que le gouvernement du Canada, y compris les coûts pour les participants (p. ex., les frais d'utilisation, les coûts liés aux demandes ou les coûts de conformité) et les coûts d'autres partenaires gouvernementaux ou non gouvernementaux.

Le calibrage de l'établissement des coûts et du suivi des coûts

Les gestionnaires de programme, les gestionnaires des finances et les chefs de l'évaluation doivent prendre en considération la taille relative, la portée et les risques du programme au moment de déterminer la complexité des systèmes d'établissement des coûts et de suivi financier nécessaires pour soutenir efficacement l'évaluation.

En matière d'établissement des coûts, les gestionnaires de programme et les gestionnaires des finances ont intérêt à suivre les instructions du Guide d'établissement des coûts du Secrétariat du Conseil du Trésor du Canada afin de déterminer les objets des coûts, leurs bases, leurs classifications et leurs attributions. De plus, les gestionnaires de programme et les gestionnaires des finances doivent :

- déterminer les objets des coûts en fonction d'activités, d'extrants, de gammes de services, de chaînes de résultats ou de résultats immédiats visibles, l'idée étant d'établir les « unités d'analyse » qui peuvent être prises en considération dans l'examen de l'efficience et de l'économie du programme;

- consulter les chefs de l'évaluation au sujet des plans visant à recueillir et à faire le suivi des données sur les dépenses pour s'assurer qu'ils appuient efficacement l'évaluation du programme, y compris l'examen de la QF5;

- prendre en considération les genres de question d'évaluation et les besoins connexes en matière de données exposés dans les sections traitant de l'examen de l'économie et de l'efficience qu'on verra plus loin dans le présent document;

- rechercher des attributions et des répartitions de coûts qui contribuent à indiquer le coût véritable des objets et du programme dans son ensemble (p. ex., des façons d'attribuer les coûts d'exploitation et d'entretien à des objets précis ou de répartir les coûts parmi ces mêmes objets).

Les décisions relatives à la complexité de l'établissement des coûts et du suivi des dépenses devraient être prises en fonction de la taille du programme, de sa portée et des risques qui lui sont associés. Par exemple, les programmes présentant peu de risques, dont les gammes de services sont relativement simples et qui ne nécessitent qu'un minimum d'intrants (p. ex., seulement pour l'exploitation et l'entretien) pour donner lieu à des résultats précis, peuvent définir les objets des coûts au niveau des résultats immédiats. En pareil cas, les évaluateurs pourront choisir d'aborder l'examen sous l'angle de l'efficience allocative.

5.3 Détermination rétrospective de l'information sur les coûts

Selon le degré de maturité des systèmes d'établissement des coûts et de suivi financier du programme, les évaluateurs peuvent avoir des défis à relever, notamment les suivants :

- absence de données sur les coûts;

- données sur les coûts de faible qualité;

- rapports sur les coûts qui ne sont pas clairement alignés sur les activités, les extrants, les résultats immédiats, les gammes de services ou d'autres unités d'analyse utiles aux fins de l'évaluation.

Il peut arriver que les programmes n'aient pas de données utilisables sur les coûts, mais il serait vraiment surprenant qu'un programme ne dispose d'aucune donnée financière. Voici des exemples de sources courantes de données financières (ou de données qui aident les évaluateurs à déterminer les coûts) :

- un système de gestion de l'information financière utilisé dans le cadre du programme;

- une vérification ou un examen opérationnel récent;

- les budgets du programme;

- le modèle logique et la théorie du changement connexes au programme;

- des documents relatifs à la planification, aux rapports, à la gestion et aux activités du programme;

- des intervenants travaillant ou non au programme (p. ex., gestionnaires, personnel et clients);

- le budget du ministère ou les rapports sur le budget du ministère;

- des écrits récents sur des programmes semblables;

- des données sur la mesure du rendement (recueillies aux fins de la stratégie de mesure du rendement ou du cadre de mesure du rendement).

Lorsqu'il n'y a pas de données sur les coûts ou que les données ne sont pas alignées sur des unités d'analyse utiles pour l'examen de la QF5, les évaluateurs doivent entreprendre des exercices d'affectation des coûts aux unités d'analyse. Par exemple, ils peuvent utiliser les éléments suivants :

- des sondages auprès du personnel qui permettront d'évaluer le temps que les employés consacrent à différentes activités ou à différents extrants. Ces sondages peuvent également être utilisés à l'appui d'autres approches analytiques pour examiner la QF5 (p. ex., les appréciations participatives);

- des feuilles de temps, même si elles n'ont été tenues que brièvement (p. ex., pendant un mois) peuvent donner une idée approximative du temps que les employés consacrent à différentes activités ou à différents extrants. Les feuilles de temps peuvent également être utiles pour déterminer les activités qui nécessitent le plus d'efforts, et ainsi aider les évaluateurs à cibler leur analyse;

- des schémas des processus peuvent être utiles pour recenser les principales activités et gammes de services associées à un programme donné.

Comme on l'a vu plus tôt, les défis que posent les données financières (p. ex., absence de données, codage des données non aligné sur les unités d'évaluation) ne justifient pas de ne pas examiner les cinq QF ou de revoir à la baisse la portée, l'approche ou la conception de l'évaluation.

6.0 Les prochaines étapes pour la collectivité fédérale de l'évaluation

Les évaluateurs des programmes du gouvernement fédéral trouveront dans ce guide un aperçu de l'examen de la QF5 et des consignes pour le mener à bien. Comme on l'a vu ci-dessus, il existe une vaste gamme d'approches plus traditionnelles pour examiner l'utilisation des ressources, comme l'analyse coût-efficacité et l'analyse coût-avantage, sur lesquelles les évaluateurs peuvent s'appuyer, le cas échéant. La collectivité de l'évaluation est encouragée à renforcer ses capacités de faire ces genres d'analyses.

Parallèlement, des approches nouvelles et novatrices voient le jour (comme l'analyse qualitative des coûts-utilité et la mise à l'essai de théories de l'exécution). Ces approches pourraient constituer des solutions de rechange dans les cas où les approches traditionnelles axées sur les coûts ne conviennent pas ou sont impossibles à mettre en œuvre. La collectivité fédérale de l'évaluation, y compris le Centre d'excellence en évaluation et les fonctions d'évaluation dans les ministères et organismes, devrait mettre à l'essai ces approches de rechange qui semblent prometteuses pour différents programmes et contextes.

7.0 Suggestions et demandes de renseignements

Les suggestions et les demandes de renseignements concernant le présent guide doivent être acheminées au :

Centre d'excellence en évaluation

Secteur de la gestion des dépenses

Secrétariat du Conseil du Trésor du Canada

Courriel : evaluation@tbs-sct.gc.ca

Pour en savoir plus sur les évaluations et des sujets connexes, consultez la section du Centre d'excellence en évaluation du site Web du Secrétariat du Conseil du Trésor du Canada.

Annexe A : Évolution des enjeux dans les évaluations au gouvernement fédéral de 1977 à 2009

| Politique | Politique d'évaluation (1977)Voir la note * du tableau A1 | Politique d'évaluation (1992)Voir la note † du tableau A1 | Politique d'examen (1994)Voir la note ‡ du tableau A1 | Politique d'évaluation (2001) | Politique sur l'évaluation (2009) |

|---|---|---|---|---|---|

Notes du tableau 1

|

|||||

| Questions fondamentales | S.O. | Pertinence | Pertinence | Pertinence | Pertinence |

| Efficacité | Résultats | Résultats | Résultats | Réalisation des résultats escomptés | |

| Efficience | Rapport coût-efficacité | Rapport coût-efficacité | Rapport coût-efficacité | Utilisation des ressources (démonstration d'efficience et d'économie) | |

Pour faire en sorte que la fonction d'évaluation au gouvernement fédéral continue d'être adaptée aux besoins de ses clients (c'est-à-dire les usagers des évaluations), la Politique sur l'évaluation de 2009 table sur les questions d'évaluation recensées dans la Politique d'évaluation de 2001 (c'est-à-dire pertinence, résultats et rentabilité) et clarifie celles-ci comme suit :

- en définissant clairement le concept de l'optimisation des ressources aux fins de l'évaluation;

- en désignant clairement la pertinence et le rendement comme sous-composantes de l'optimisation des ressources;

- en présentant aux évaluateurs trois questions fondamentales sur lesquelles axer l'évaluation pour orienter l'examen de la pertinence du programme;

- en regroupant les résultats et le rapport coût-efficacité à titre d'éléments du rendement du programme;

- en présentant aux évaluateurs deux questions fondamentales sur lesquelles axer l'évaluation pour orienter l'examen du rendement du programme.

L'ensemble de cinq questions fondamentales concernant l'évaluation, s'il est utilisé uniformément au fil du temps, aidera le gouvernement à mettre en place une base fiable de preuves tirées des évaluations à l'appui de l'amélioration des politiques et des programmes, de la gestion des dépenses, du processus décisionnel du Cabinet et des rapports publics, individuellement au niveau des programmes et horizontalement à l'échelle du gouvernement.

Annexe B : Le rendement dans les évaluations des programmes fédéraux

Comme on le voit dans l'annexe A de la Politique sur l'évaluation, le rendement s'entend de la mesure de l'efficacité, de l'efficience et de l'économie d'un programme du gouvernement fédéral.

Composantes du rendement : question fondamentale 4 (QF4) (Réalisation des résultats escomptés) et QF5 (Démonstration d'efficience et économie)

Question fondamentale 4 (Réalisation des résultats escomptés)

Évaluation des progrès réalisés dans l'atteinte des résultats escomptés (y compris les résultats immédiats, intermédiaires et ultimes) par rapport aux cibles et à la portée du programme, à la conception du programme, ce qui comprend les liens et la contribution des extrants aux résultats.

La QF4 et la QF5 représentent pour les évaluateurs deux composantes clés pour l'examen du rendement du programme. La QF4 (Réalisation des résultats escomptés) est une plateforme permettant aux évaluateurs de définir et d'explorer des questions liées à l'efficacité des programmes, et notamment, mais non pas exclusivement, des questions sur les éléments suivants :

- Les résultats observés (qu'ils aient été attendus ou non);

- L'attribution de résultats observés aux programmes gouvernementaux ou la contribution des programmes gouvernementaux aux résultats observés;

- L'étendue des résultats des programmes;

- La conception et l'exécution des programmes;

- Les solutions de rechange aux programmes existants.

Question fondamentale 5 (Démonstration d'efficience et d'économie)

Évaluation de l'utilisation des ressources relativement à la production des extrants et aux progrès réalisés concernant l'atteinte des résultats escomptés.

La QF5 est une plateforme complémentaire permettant aux évaluateurs de définir et d'explorer des questions reliées à l'utilisation des ressources dans le cadre des programmes, et notamment, mais non pas exclusivement, des questions sur les éléments suivants :

- La relation qui existe entre les extrants, les résultats et les coûts observés;

- Le coût relatif des intrants;

- Le caractère raisonnable des coûts des extrants et des résultats en fonction de facteurs contextuels;

- Le caractère raisonnable des approches existantes en matière d'utilisation des ressources et des solutions de rechange connexes.

Le rendement est plus grand que la somme de ses parties

Le processus permettant de tirer des conclusions claires et valides au sujet du rendement du programme repose non seulement sur une analyse donnant lieu à des constatations sur la QF4 et sur la QF5 prises séparément, mais aussi sur une analyse de la relation entre les deux questions fondamentales (p. ex., comment l'efficacité varie en fonction de l'efficience ou de l'économie). De plus, il est important de noter que ces conclusions devront être éclairées et contextualisées par des constatations sur la pertinence du programme tirées de l'examen des questions fondamentales 1, 2 et 3, par d'autres facteurs contextuels ou par des constatations relatives à des approches de rechange visant à atteindre les mêmes résultats. Par exemple :

- Après avoir été déterminés comme des programmes correspondant à une grande priorité pour le gouvernement ou répondant à un besoin important de la population canadienne, ceux-ci peuvent être mis en œuvre selon des échéanciers ou d'autres conditions qui influent sur leur capacité en matière de démonstration d'efficience ou d'économie;

- Des transformations inattendues du contexte international ou du climat économique peuvent avoir des répercussions sur le coût des ressources utilisées dans le cadre du programme;

- Des modèles d'exécution de rechange, qui sont le fruit de nouvelles technologies, peuvent se révéler plus efficaces que le modèle d'exécution utilisé dans le cadre du programme actuel.

Les évaluateurs devront mener ces examens évaluatifs d'une manière qui soit à la fois crédible et calibrée par rapport aux risques associés au programme.

Annexe C : L'état de préparation des programmes en vue de l'examen de la question fondamentale 5

L'évaluation de la mesure dans laquelle un programme est prêt à faire l'objet d'un examen de son économie et de son efficience se base en grande partie sur une évaluation de la logique et de la théorie du programme, ainsi que sur la disponibilité, l'accessibilité et le formatage des données permettant d'éclairer l'examen. La liste de contrôle du tableau C1 a été conçue pour aider les évaluateurs à travailler avec les gestionnaires de programme et les gestionnaires des finances pour déterminer les points forts et les points faibles concernant l'état de préparation du programme pour un examen de la QF5. En remplissant cette liste de contrôle bien avant les évaluations, les évaluateurs pourront signaler aux gestionnaires des programmes les lacunes de leurs systèmes de mesure du rendement aux fins des évaluations. La liste de contrôle peut également être utilisée par les gestionnaires de programme et les gestionnaires des finances pour éclairer l'élaboration et l'exécution de leurs stratégies de mesure du rendement.

| Exigence | Faible état de préparation | Moyen état de préparation | Grand état de préparation |

|---|---|---|---|

| Efficience (allocative et opérationnelle) et économie | |||

| Le programme comporte un modèle logique clairement défini | |||

| La théorie du programme a été décrite dans le cadre de l'exercice d'établissement de son modèle logique | |||

| Une stratégie de mesure du rendement a été élaborée et mise en œuvre dans le cadre du programme | |||

| Les objets des coûts sont clairement liés à des activités, des extrants ou des résultats appropriés (ou encore à des chaînes de résultats ou à des gammes de service dans leur ensemble) | |||

| État de préparation relatif à l'efficience opérationnelle | |||

| Le programme comporte des plans opérationnels dotés d'échéanciers et d'objectifs de mise en œuvre clairement définis | |||

| Il est possible d'assurer le suivi des progrès sur le plan de la mise en œuvre (p. ex., au moyen de plans d'action ou de plans d'activités, et de procès-verbaux se rapportant aux plans opérationnels) | |||

| Des coûts peuvent être associés à chaque extrant | |||

| État de préparation relatif à l'économie | |||

| Des objets de coût sont associés à des objectifs clairement définis | |||

| Les coûts sont adéquatement et uniformément attribués et répartis aux objets de coût | |||

| Le programme se caractérise par la présentation périodique de rapports comportant de l'information exacte sur les coûts, y compris sur l'emploi du temps et les acquisitions | |||

Barème

- Faible état de préparation:

- L'exigence n'est pas satisfaite (p. ex., le programme ne comporte pas de modèle logique clair, les objectifs en matière de coûts ne sont pas associés à des cibles claires).

- Moyen état de préparation :

- L'exigence n'est satisfaite qu'en partie (p. ex., les coûts peuvent être associés à certains extrants).

- Grand état de préparation :

- L'exigence est pleinement satisfaite (p. ex., les objets des coûts sont tous clairement liés à des activités, des extrants ou des résultats appropriés).

Annexe D : Rôles et responsabilités en ce qui concerne la question fondamentale 5

Les rôles et responsabilités énumérés ci-dessous ont pour objet d'aider les évaluateurs (y compris les chefs de l'évaluation des ministères) à communiquer avec les gestionnaires de programme et les gestionnaires des finances au sujet des besoins, des rôles et des responsabilités concernant l'examen de la question fondamentale 5 (QF5).

Les gestionnaires de programme, les gestionnaires des finances, les chefs de l'évaluation et les gestionnaires de l'évaluation ont tous des rôles de premier plan à jouer lorsqu'il s'agit de veiller à ce qu'un programme soit prêt à être évalué dans l'optique de la QF5. Ils doivent assumer leurs rôles dès l'étape de la conception d'un programme et pendant toute sa durée.

Étant donné que les rôles et responsabilités des gestionnaires de programme, des gestionnaires des finances, des chefs de l'évaluation et des gestionnaires de l'évaluation sont étroitement reliés les uns aux autres, les outils – comme la stratégie de mesure du rendement (MR), la stratégie d'évaluation, le cadre d'évaluation et le rapport annuel sur l'état de la mesure du rendement – sont des plateformes importantes qui donnent à ces intervenants de premier plan l'occasion d'interagir régulièrement pour traiter des besoins en matière d'évaluation et de mesure du rendement.

Les gestionnaires de programme

Aux termes de la Directive sur la fonction d'évaluation (Canada, 2009a, paragraphe 6.2.1), les gestionnaires de programme ont la responsabilité d'élaborer, d'actualiser et de mettre en œuvre des stratégies de MR pour leurs programmes14. Ces stratégies comprennent des descriptions de programme, des modèles logiques (et des théories de programme connexes), des mesures du rendement claires et des stratégies d'évaluation15. En ce qui concerne les nouveaux programmes, les stratégies de mesure du rendement devraient être élaborées à l'étape de la conception du programme. Quant aux programmes permanents qui n'ont pas de stratégie de mesure du rendement, une telle stratégie devrait être élaborée rapidement afin que des données soient disponibles pour appuyer les activités de surveillance et d'évaluation du programme. Pour élaborer une stratégie de mesure du rendement, les gestionnaires de programme devront :

- travailler en étroite collaboration avec les gestionnaires des finances afin de veiller à ce que les systèmes de surveillance des dépenses puissent appuyer une évaluation de l'efficience et de l'économie d'un programme et soient adéquats, compte tenu de la complexité relative du programme, de son importance relative et des risques qui y sont associés;

- consulter le chef de l'évaluation au sujet de l'élaboration de la stratégie de mesure du rendement pour confirmer qu'elle appuiera efficacement les évaluations du programme (Directive sur la fonction d'évaluation, Canada, 2009a, paragraphe 6.2.3).

Gestionnaires des finances

Les gestionnaires des finances jouent un rôle important lorsqu'il s'agit :

- de fournir de l'aide, conformément au Guide d'établissement des coûts (2008) du Secrétariat du Conseil du Trésor du Canada, pour cerner les objets de coûts appropriés qui sont clairement liés aux activités, aux extrants ou aux résultats immédiats du programme (p. ex., les chaînes de résultats ou les gammes de service) qui appuieront une évaluation de l'efficience et de l'économie;

- d'opérationnaliser la surveillance permanente des finances et la production subséquente de données à l'appui des activités de surveillance et d'évaluation.

Comme on l'a déjà vu, les gestionnaires des finances devront travailler en étroite collaboration avec les gestionnaires de programmes et les chefs de l'évaluation, notamment au stade de la conception du programme, pour veiller à ce que l'approche adoptée pour recueillir et suivre les données financières puisse appuyer efficacement l'évaluation.

Chefs de l'évaluation

Les chefs de l'évaluation doivent « examiner les stratégies de mesure du rendement pour toutes les dépenses de programmes directes, nouvelles et en cours, y compris tous les programmes de subventions et de contributions permanents, pour s'assurer que ces stratégies appuient efficacement l'évaluation de la pertinence et du rendement, et fournir des conseils à ce sujet » (Directive sur la fonction d'évaluation, Canada, 2009a, paragraphe 6.1.4). De plus, les chefs de l'évaluation ou les gestionnaires de l'évaluation qu'ils désignent sont chargés d'élaborer des approches d'évaluation qui satisfont aux exigences énoncées dans la Politique sur l'évaluation et les documents connexes16. Dans les cas où les programmes sont moins prêts au chapitre de la disponibilité des données, les chefs de l'évaluation doivent collaborer avec les gestionnaires de programmes et les gestionnaires des finances en vue d'élaborer des stratégies (p. ex., affectation ou répartition rétroactive des coûts, sondages auprès du personnel, diagrammes des processus, examens menés par la direction) qui peuvent appuyer l'évaluation de l'efficience et de l'économie. Enfin, les chefs de l'évaluation ont la responsabilité de « présenter au Comité d'évaluation ministériel un rapport annuel sur l'état de la mesure du rendement des programmes à l'appui de l'évaluation » (Directive sur la fonction d'évaluation, Canada, 2009a, paragraphe 6.1.4). Il est recommandé que ce rapport comprenne une évaluation de la collecte des données financières et non financières à l'appui d'évaluations efficaces.

Annexe E : Optimisation des intrants et des extrants

Dans les évaluations des programmes fédéraux qui ont recours à une analyse de l'efficience opérationnelle et à une analyse de l'économie pour examiner la question fondamentale 5, l'analyse ne porte pas uniquement sur le coût par unité d'extrant ou d'intrant, mais aussi sur la mesure dans laquelle les extrants ou les intrants ont été optimisés.

Les intrants ou les extrants sont réputés avoir été optimisés lorsque certains facteurs, y compris le coût, la quantité, la qualité, l'opportunité et le caractère approprié des extrants produits ou des intrants acquis, ont été mis en balance par les gestionnaires de programme d'une manière rationnelle défendable sur la base de la théorie du programme (c'est-à-dire hypothèses, risques, mécanismes et contexte), de la logique, de la pertinence (c'est-à-dire QF1, QF2 et QF3) et des résultats observés (c'est-à-dire la QF4). Les évaluateurs doivent examiner plus en profondeur la façon dont la mise en balance des attributs s'est répercutée sur la réalisation des résultats. On trouvera dans le tableau E1 un complément d'information sur les facteurs d'optimisation des intrants et des extrants.

| Attribut | Extrants (efficience) | Intrants (économie) |

|---|---|---|

| Coût | Le coût des extrants et la mesure dans laquelle le programme a cherché à le minimiser (tout en maintenant un degré approprié de qualité, de quantité et d'opportunité) | Le coût des intrants et la mesure dans laquelle le programme a cherché à le minimiser (tout en maintenant un degré approprié de qualité, de quantité et d'opportunité) |

| Qualité | La mesure dans laquelle les extrants sont adéquats pour obtenir résultats escomptés | La mesure dans laquelle les intrants sont adéquats pour générer les extrants et les résultats escomptés |

| Quantité | La mesure dans laquelle les extrants ont été produits en quantité suffisante pour appuyer l'atteinte des résultats escomptés | La mesure dans laquelle les intrants ont été acquis en quantité suffisante pour générer les extrants et les résultats escomptés |

| Opportunité | La mesure dans laquelle les extrants ont été produits à des stades appropriés du programme | La mesure dans laquelle les intrants ont été acquis ou étaient disponibles à des stades appropriés du programme |

| Caractère approprié | La mesure dans laquelle les extrants étaient susceptibles d'appuyer l'atteinte des résultats escomptés | La mesure dans laquelle les intrants étaient susceptibles d'appuyer la production des extrants et les résultats ont été acquis |

Annexe F : Analyse de l'efficience opérationnelle

L'efficience opérationnelle a essentiellement trait à la question ayant comme objet de déterminer de quelle façon les ressources sont converties en extrants qui appuient la réalisation des résultats escomptés. L'analyse de l'efficience opérationnelle (AEO) ne représente pas une approche analytique unique ou un processus formalisé comme l'analyse coût-avantage. Elle renvoie plutôt à une gamme d'approches, de modèles et de méthodes analytiques qui peuvent être utilisés (lorsque c'est justifié de le faire et selon diverses combinaisons) pour examiner l'efficience des programmes de façon détaillée. De cette façon, les évaluateurs peuvent, entre autres choses :

- calibrer les évaluations en faisant une analyse plus approfondie de chaînes de résultats, d'extrants ou d'activités particuliers dont on juge qu'ils présentent des risques plus élevés;

- réaliser des examens de l'efficience de programmes qui ne sont pas encore au stade de leur cycle de vie ou de leur maturité où une analyse intégrale coût-efficacité ou coût-avantage est justifiée (p. ex., évaluations formatives).

Secteurs d'intérêt de l'AEO

Au moment d'examiner l'efficience opérationnelle, on peut considérer divers secteurs d'intérêt qui rentrent dans des catégories générales, notamment :

- les extrants du point de vue de leurs coûts;

- les dimensions qualitatives des processus et des extrants du programme (y compris des questions concernant l'optimisation des extrants et le processus décisionnel de la direction du programme au sujet de l'utilisation des ressources);